原文作者:Yang

引子

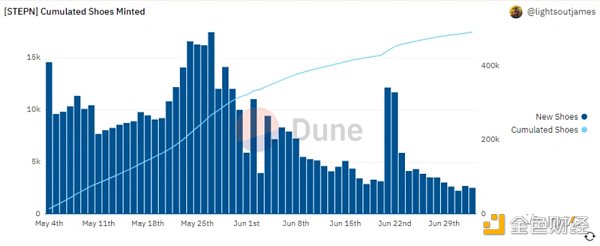

“數”中自有黃金屋,鏈上數據潛藏著無盡的Alpha。當我們跟隨smart money聞風而動,當我們夜以繼日地在NFT Paradise中尋找trending NFT,當我們查詢StepN每日新鞋鑄造數據時,你是否好奇這些數據如何而來?面對眾多鏈上數據分析平台和紛繁複雜的功能,你是否還在尋找最適合自己的那個平台?

1. 背景介紹

隨著鏈上生態的日益蓬勃,如DeFi交易、借貸,NFT的鑄造、交易等,用戶的行為被直接透明地記錄在鏈上。這些鏈上行為的數據對應著鏈上價值的流動,對這些數據的分析和根據分析而得出的洞察和見解變得極為有價值。鏈上數據分析平台,如Nansen,Token Terminal,Dune Analytics,Footprint Analytics,flipsidecrypto, glassnode,Skew等順應這些日益增長的需求,面向個人和機構用戶推出了側重點略有不同的產品。

本文先將簡述鏈上數據分析平台背後的數據架構,意在告訴讀者那些鏈上數據分析結果從何而來,如何而來。隨後我們從數據豐富度(覆蓋區塊鏈數量)、數據粒度、數據延遲、平台易用性和查詢自由度等維度為讀者梳理市場上主流的面向個人用戶的數據分析平台。最後分享我們對Web3未來鏈上數據索引、查詢和分析的一點暢想。

2. 鏈上數據分析平台數據架構介紹

雖然區塊鏈記錄著所有原始的交易數據,鏈上數據本身都是公開透明的,但當我們提出:過去24小時Uniswap的交易量是多少?當前百分之多少的BAYC持有者也同時持有至少一個Moonbirds?……等等問題時,鏈上原始數據並不能給我們答案,我們需要通過索引(indexing),處理(processing),存儲(storage)等等一系列數據攝取(ingestion)的處理過程,再根據所提問題來聚合運算對應的數據,才能得到問題的答案。直接查詢區塊鏈來求得問題答案是非常耗時耗力的,為了讓鏈上數據能夠被快速檢索,當前主流的鏈上數據分析平台會將索引得到的原始鏈上數據,經過一系列處理後,存入由平台負責更新和管理的數據倉庫(data warehouse)中。當用戶在Nansen追踪smart money的交易動態,或在Dune Analytics上查看可視化分析時,用戶對所謂“鏈上數據”的查詢,實際上是在查詢由項目方中心化控制的數據庫而非區塊鏈本身。

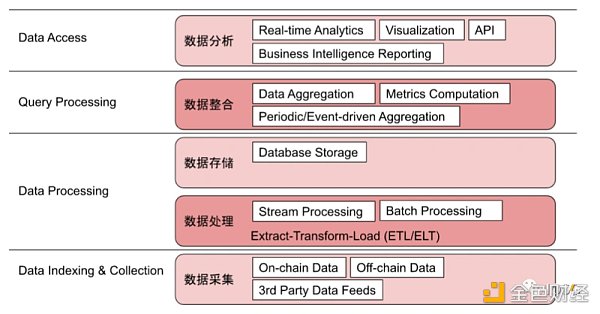

鏈上數據分析平台的數據倉庫架構大致如下:

-

數據採集層: 平台從區塊鏈節點獲取原始鏈上數據,部分平台會接受第三方提供的數據源,還有的平台(如Footprint Analytics)支持用戶上傳鏈下數據來輔助最終的數據分析。

-

數據處理層: 各平台將原始數據以流式處理或批次處理的方式進行數據抽取、轉換和加載。流式處理中,實時原始數據被源源不斷地輸入並被持續處理,通常意味著數據延遲低,分析結果時效性更高;而批次處理雖然數據延遲會稍高,分析結果時效性稍低,但更適用於大容量的數據處理。

-

數據存儲層:經過處理後的數據會根據平台方預先定義的格式存儲進數據集的各數據表中以待後續使用。

-

數據整合層:存儲的數據會被聚合運算。計算可以是根據預先設定好的指標來進行的(metrics computation),也可以階段性的(periodic)或是根據設定好的條件被觸發的(event-driven aggregation)等。

-

數據分析層:運算完成的結果被實時地報告、輸出。對於個人用戶而言,我們主要在數據分析層與鏈上數據分析平台進行交互,比如Nansen提供的Business Intelligence報告界面,Dune Analytics和Footprint Analytics上眾多的的可視化圖表,以及部分平台提供的API接口等。

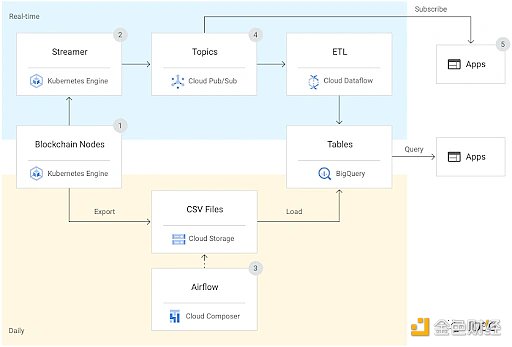

各平台採取了不同的方案來建設和維護自己的數據倉庫。比如Nansen借助第三方Google Cloud Platform完成數據倉庫的建設和維護。

(https://www.nansen.ai/post/nansen-and-google-cloud-empower-web3-investors-with-high-quality-real-time-market-intelligence)

圖片來源:Google Cloud Nansen Case Study https://cloud.google.com/customers/nansen

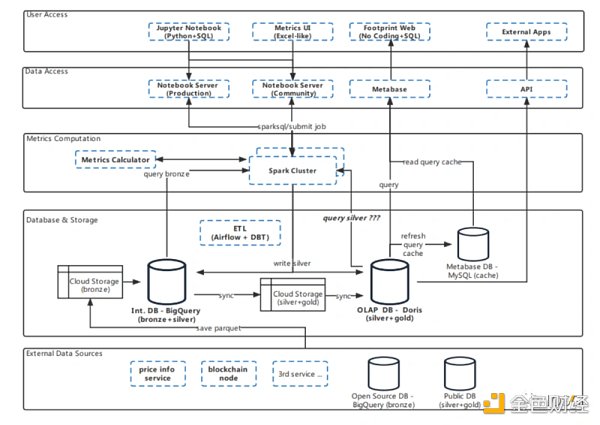

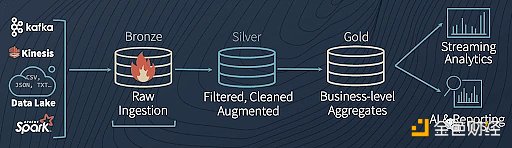

而Dune Analytics,Footprint Analytics,Token Terminal等平台則獨立建設和維護自己的數據倉庫。以Footprint Analytics為例,其數據倉庫架構如下圖所示。

3. 主流鏈上數據分析平台比較

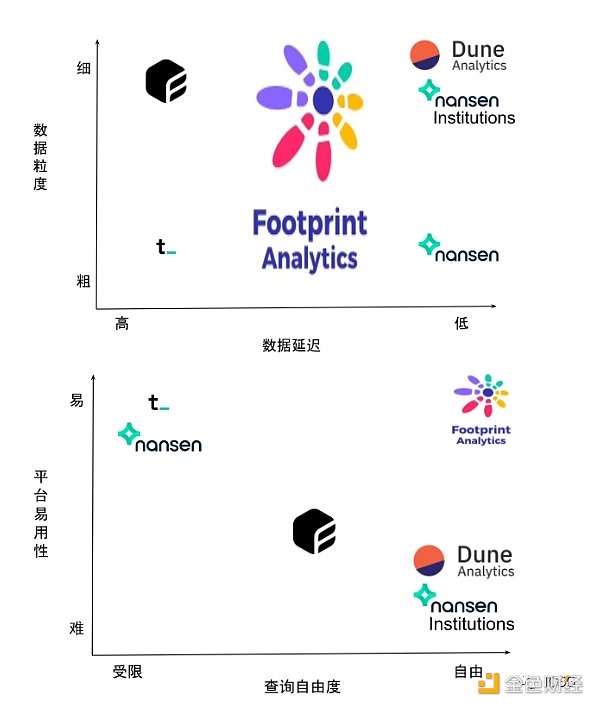

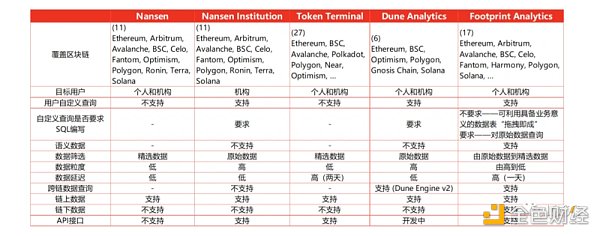

本節以內容視角和用戶視角,從數據豐富度(覆蓋區塊鏈數量)、數據粒度、數據延遲、平台易用性和查詢自由度等維度來對比幾家主流的鏈上數據分析平台,包括Nansen,Token Terminal,Dune Analytics,Footprint Analytics。

部分平台給用戶提供標準化的信息報告界面,比如Nansen,Token Terminal等。

Nansen

Nansen應該是大家最為熟悉的鏈上數據分析平台之一。相較於其他平台,其最為出色的功能是錢包標記(wallet profiler/wallet labeling)。借助錢包標記並結合其他鏈上數據為用戶提煉出極具價值的信息,比如Smart Money,幫助用戶追踪巨鯨、重度DeFi玩家的實時動向。其他熱門產品包括Hot Contract, 發現新興熱門的DeFi和NFT合約;NFT Paradise,一覽實時NFT鑄造數據等等。

【覆蓋區塊鏈】Nansen現在支持Ethereum, Arbitrum, Avalanche, BSC, Celo, Fantom, Optimism, Polygon, Ronin, Terra, Solana共計11條區塊鏈的鏈上數據分析

【數據粒度】Nansen普通版僅為用戶提供精選數據(curated data)

【數據延遲】流式處理和批次處理。部分數據分析已實現近乎實時的報告

【平台易用性】零門檻

【查詢自由度】Nansen普通版僅提供標准信息模板界面。針對機構客戶對自定義鏈上數據查詢和分析的需求,Nansen借助Google Cloud Platform的Blockchain Datasets發布了Nansen Institutions產品,讓專業/機構用戶能夠編寫滿足定制需求的SQL Queries。

值得一提的是,Nansen在Nansen Research頻道中發布了不少鏈上分析報告。研究報告會對重點事件進行抽絲剝繭般的鏈上追踪和分析,讀者不妨偶爾閱讀這些報告(如Nansen針對上月stETH脫錨事件發布的報告https://www.nansen.ai/research/on-chain-forensics-demystifying-steth-depeg),對學習鏈上分析的方法大有裨益。

Token Terminal

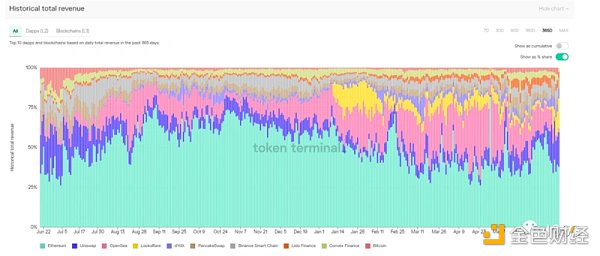

Token Terminal以提供準確的協議收入(protocol revenue)而著名。基於協議收入,Token Terminal計算了各協議的市銷率(P/S),市盈率(P/E)等數據。這些數據在一定程度上為各協議提供了估值基準。

【覆蓋區塊鏈】Token Terminal追踪了超過130個協議的數據

【數據粒度】Token Terminal僅為用戶提供精選數據(curated data)

【數據延遲】批次處理。據IOSG團隊近期與Token Terminal的溝通,目前Token Terminal平台上的數據大約有兩天時間的延遲

【平台易用性】零門檻

【查詢自由度】僅提供標准信息界面

Token Terminal協議收入數據圖例:過去365天收入前十的區塊鍊和協議的收入佔比

另外一些主流鏈上數據分析平台則向用戶開放數據表,用戶可自由編寫代碼進行查詢,在查詢內容上給予用戶一定的自由度,如Dune Analytics和Footprint Analytics。

Dune Analytics

Dune Analytics是最早開放用戶自主查詢的鏈上數據分析平台,擁有最大的分析師團體和用戶社區。 Dune Analytics提供了高度顆粒化的原始鏈上數據,分析師可以自由地利用這些數據寫出自定義的查詢。 Dune Analytics也對項目方團隊開放Abstraction,項目方可以根據自己協議的數據內容創造更適合的數據表供分析師使用。但自主查詢具備一定的門檻,分析師需具備PostgreSQL的編寫能力才能創造滿足自己需求的數據查詢。而且查詢延遲與分析師SQL編寫水平和對Dune Analytics提供的數據表熟悉程度高度相關。

【覆蓋區塊鏈】Dune Analytics提供了Ethereum, BSC, Optimism, Polygon, Gnosis Chain, Solana共計6條區塊鏈的鏈上數據

【數據粒度】極細

【數據延遲】流式處理。數據延遲大約五分鐘

【平台易用性】Dune Analytics對分析師提出了一定的SQL coding要求

【查詢自由度】高

有了高度顆粒化的原始數據,分析師便可以在Dune Analytics自由創建鏈上分析。如每日StepN新鞋鑄造及歷史積累數據https://dune.com/queries/627689/1170627

Dune Analytics於2022年5月30日發布了Dune Engine v2。 Dune Engine v2在將Dune Analytics的數據架構進行大改來為用戶提供更快查詢響應和更好查詢表現的同時,也將對用戶體驗的影響降至最低。

Footprint Analytics

相較於Nansen低使用門檻但僅提供標準化信息界面,Dune Analytics提供了自由查詢但又要求分析師具備編寫PostgreSQL語言的能力,Footprint Analytics為用戶提供了兩全其美的解決方案,在給予極大的查詢自由度的同時降低了使用門檻。它是如何做到的?

“鏈上數據錯綜複雜,分析師可能需要寫成百上千行代碼才得以完成一個指標的計算。為了解決分析門檻高的問題,Footprint清理和集成鏈上數據,給數據賦予了業務意義,使得用戶無需SQL查詢和編碼也可以分析區塊鏈數據。任何人都可以通過豐富的圖表界面在幾分鐘內構建自己的自定義圖表,解密鏈上數據,發現項目背後的價值趨勢。”

Footprint Analytics不僅提供原始區塊鏈數據,更將鏈上數據進行分級。最原始的鏈上數據為銅級別(Bronze data),經過篩選、清洗和增強的數據為銀級別(Silver data),進一步整理出具備業務意義的數據為金級別(Gold data)。

已經整理完成的具有商業邏輯和業務意義的金銀級別數據可以直接用於分析。借助金銀級別數據,Footprint Analytics為用戶提供了通過簡單地拖拽數據表就能自主查詢鏈上數據的服務。不管讀者你是否會寫類SQL語言代碼,你都可以快速創建滿足自己定制化需求的數據分析信息界面,並將所需信息通過直觀且可互動的圖表可視化。

【覆蓋區塊鏈】Footprint Analytics目前提供了Ethereum,Arbitrum,Avalanche,Boba,BSC,Celo,Fantom,Harmony,IOTEX,Moonbeam,Moonriver,Polygon,Thundercore,Solana等共計17條區塊鏈的鏈上數據

【數據粒度】Footprint Analytics既為用戶提供粒度極細的原始數據,也為用戶提供精選數據(curated data)

【數據延遲】目前Footprint Analytics對採集到的原始數據進行每日一次的批次處理,數據延遲為一天

【平台易用性】在Footprint Analytics平台,用戶無需SQL查詢和編碼也可自由分析鏈上數據。對於具備SQL代碼能力的分析師,Footprint也提供原始數據供分析師發揮。

【查詢自由度】高

讀者不妨現在就前往Footprint Analytics,幾分鐘即可上手製作一個自己的鏈上分析界面

圖片來源:IOSG

4. 一點暢想——去中心化鏈上數據分析

鏈上數據分析如此重要,當今用戶卻只能依賴Nansen,Dune Analytics等中心化管理的“鏈上數據”分析平台來輔助投資決策。在這些平台上,用戶無法驗證所用數據是否未經篡改,不得不信任平台所提供的數據集是確鑿真實的。 “Don’t Trust. Verify.”在鏈上數據分析這裡成了一句空話。

Web3浪潮滾滾而來,鏈上生態越發豐富,未來的智能合約和去中心化應用可能不僅僅需要原始鏈上數據和預言機所提供的數據作為輸入信息,還可能需要輸入基於鏈上原始數據計算得出的分析結果,那時候我們還能信任和使用這些中心化鏈上數據分析平台作這類用途嗎?答案恐怕是否定的。

IOSG團隊近期看到已有項目團隊在實現去中心化鏈上數據查詢和分析的道路上邁出了第一步。由於篇幅受限,且聽下回分解——通向去中心化鏈上數據分析之路。