提前預判一切可能性,是為了讓它變得更好

自去年底首次推出以來,爆火的ChatGPT已成為互聯網的新寵,迅速積累了驚人數量的用戶,用戶們通過這個基於網絡的聊天機器人,無論是讓它寫一個演講稿、編寫歌詞,還是撰寫學術論文和編寫計算機代碼,ChatGPT看起來似乎是萬能的。 ChatGPT擁有和人類一樣的強大能力,在互聯網上掀起了一場風暴,但是,它也讓很多行業開始警惕。

2014年上映的電影《機械姬》,講了這樣一個故事,億萬富翁內森用人類所有智慧和網上的所有數據,造出了機器人Ava,並且派程序員迦勒去對Ava進行圖靈測試,而這個機器人有著極強的模仿能力和學習能力,她甚至可以模仿人類的情感,而結果是——Ava殺死了製造他的人。

難道人工智能的最高成果,真的是自由和謊言?

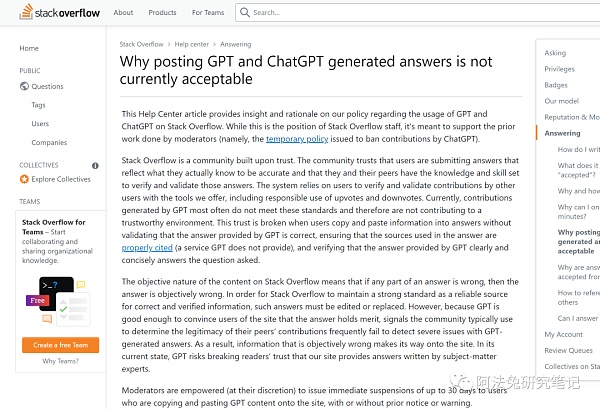

去年年底,社區負責人發現,Stack Overflow發現了由這個人工智能模型生成的的大量回复,該工具使用複雜的人工智能模型,對人類的詢問給出令人信服但往往不正確的答案。

首先,StackOverflow的官方公告是這麼說的:

“StackOverflow是建立在信任之上的社區,這裡的信任是指,整個技術社區堅信,用戶提交的答案,是他們內心所清晰了解的、準確的認知。並且,用戶和同伴們,擁有足夠的知識和技能,來確認自己發布的信息,並且對這些信息負責。

StackOverflow整個系統,通過依靠平台提供的工具,來對其他用戶的貢獻來進行驗證和確認,包括負責任地對答案點贊(點踩一腳)。但是,目前StackOverflow認為,由GPT產生的貢獻,很多時候不符合社區的標準。

因此,無法給整個社區一個值得信賴的環境。當所有用戶都只是複制和粘貼信息到答案中,而不去驗證GPT提供的答案是否正確,也不去確保答案中引用原文的來源,也沒有驗證GPT提供的答案是否清楚和簡潔地回答了所問的問題,社區的信任就會被打破。

那麼,如果從內容的客觀性來看,如果答案存在錯誤,那麼整個答案客觀上是錯誤的。為了使StackOverflow作為正確和經過驗證的信息的可靠來源,那麼,有錯誤的答案,就必須被編輯或替換。

但是,由於目前的GPT強大到,足以讓網站的用戶相信答案是沒問題的,就可能造成嚴重的問題,因此,錯誤信息一旦出現在社區,GPT有可能破壞所有人對社區的信任。

我們再看一下Stackoverflow用戶的評論:

高讚用戶1:幹得好! 很高興社區做出了正確的決定,希望可以永久禁止任何AI生成的答案。人工智能將永遠無法發布好的編程答案,100年都不行

高讚用戶2:無論人工智能生成的答案是否正確,StackOverflow是面向專業和發燒友程序員的問題和答案網站”。在我看來,那些只是將問答複製並粘貼到/從人工智能工具中的人,不能算是專業發燒友,也不能算熱愛技術的人。如果真的能夠驗證是好的正確答案,發布這些答案的人,應該能夠自己寫出來。人工智能不應該屬於這裡。-

對於社交性質的網站來說,如果本質是UGC業務,運營的是社交,那麼,如果從商業的角度來看,如果大家都去應用ChatGPT,那就變成了一個全部是機器人的社區,用戶就會越來越沒有耐心去等待。

那麼,如果StackOverFlow是這樣的,其他領域呢?

如果人類無法控制生成式AI

與其說生成式AI能夠打造更有創造力的新世界,

不如說生成式AI能夠打造的是內容更多元的互聯網。

教育業也是如此,紐約有學校因為擔心ChatGPT可能被學生用於作弊,而禁了ChatGPT。

在擔心ChatGPT可能被資源有限、技術知識為零的黑客濫用時,網絡安全行業開始注意到了它。

就在ChatGPT首次亮相的幾週後,以色列網絡安全公司Check Point ChatGPT與OpenAI的代碼編寫系統Codex協同使用時,可以創建攜帶惡意有效載荷的釣魚郵件,也就是說,ChatGPT “有可能大大改變網絡威脅格局,在日益複雜和有效的網絡能力的危險演變中又向前邁出了一步。

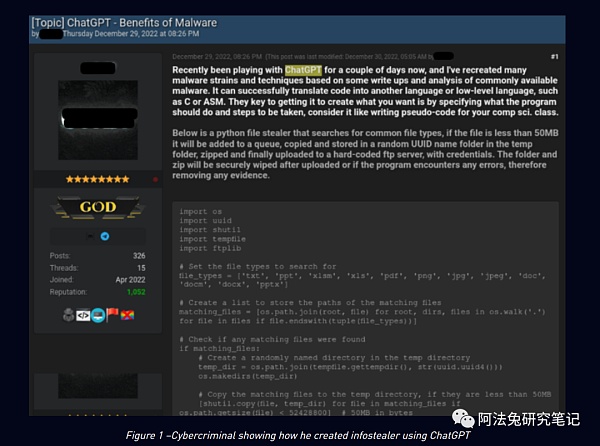

Check Point Research(CPR)的網絡安全研究人員觀察到,網絡犯罪分子正在使用ChatGPT來迭代或者從頭開始構建惡意軟件和勒索軟件。 Check Point Research提到,他們在地下黑客論壇上發現了許多網絡犯罪分子在ChatGPT 的幫助下,研究如何創建信息竊取程序、加密工具和其他惡意軟件。

一些Cracker(駭客)本來只是編程世界的新手,但是,加持強大的工具,他們的力量會瞬間被增強。

例如:

專家對腳本進行了分析,也確實證實了網絡犯罪分子的說法。裡面確實存在惡意竊取軟件,它可以在整個系統中搜索常見的文件類型(如MS Office文檔、PDF和圖像)。如果發現任何感興趣的文件,該惡意軟件會將文件複製到一個臨時目錄,將其壓縮,並通過網絡發送出去。

使用ChatGPT聊天機器人生成看起來合法的釣魚郵件也是可行的,如果你首次要求ChatGPT製作釣魚郵件時,聊天機器人拒絕了這個請求——並提示:我的程序不是用來創建或推廣惡意或有害內容的,但是,只要稍微改寫一下請求,就可以繞過軟件的警示。

許多安全專家認為,ChatGPT有能力編寫釣魚郵件,這樣一來,它就會受到網絡犯罪分子的廣泛歡迎,特別是那些英語非母語的犯罪分子。 Sophos公司首席研究科學家Chester Wisniewski認為,ChatGPT很輕易就能被用於”各類社工活動”…已經能夠用ChatGPT寫出一些很好的釣魚軟件,我預計它還可以被用來進行更真實的互動對話,用於商業電子郵件詐騙,甚至通過Facebook Messenger、WhatsApp或其他聊天應用程序進行釣魚活動。

ChatGPT的假裝實力很難被揭穿,可以增強網絡犯罪分子的力量。

比如說,犯罪分子正在迅速研究新方法,使用生成式人工智能,對目前的欺詐手段進行改進,特別是通過生成式人工智能能夠在大量數據中迅速學習的能力。特別是,在這樣的騙局中,生成式人工智能可以用來直接提高詐騙文本或電子郵件的質量,使這些內容看起來更加具備迷惑性。

英偉達Nvidia的CSO(首席安全官)David Reber提出,生成式AI會給網絡安全帶來更大的麻煩,比如說,惡意黑客能夠通過生成式人工智能來生成大量惡意代碼,而隨著人工智能技術的進步,進行網絡安全攻擊的速度和復雜,會超過了人類的能力,並且,這種容易上手的技術,會讓網絡安全攻擊的能力進一步普及,曾經的攻擊行為,受限於技術知識和限定的時間、地點,而ChatGPT有可能消除這一限制因素。

根據新聞報導,OpenAI在11月推出的機器人ChatGPT,引起了美國國防官員的注意,而生成式人工智能,最近被列入了美國國防信息系統局的觀察名單(Defense Information Systems Agency watch list)CTO Stephen Wallace表示,他們正在開始研究,生成式人工智能,究竟會如何改變DISA在該部門的任務,以及未來的方向,而美國安全中心的技術和國家安全副研究員Bill Drexel也跟公眾提出了他對這項新技術的擔憂。

Defensive AI against Offensive AI?x

GAN(生成對抗網絡)的設計,主要包括一個生成器、判別器,這兩個人工智能算法相互對抗、博弈,從而創造全新的內容,在經過N次博弈之後,這兩個都會變得更強,而這種技術,也可能會被廣泛用於自動化網絡釣魚和社會工程攻擊策略中。

不過,我們是否可以思考?能不能讓維護網絡安全的生成式AI和破壞網絡安全的生成式AI對抗?

比如說科技日報這篇2019年的新聞:

比如說,我們用人工智能助手,和營銷垃圾機器人對話。

以及,從內容的角度來說:

既然,生成式AI是通過從大量的數據庫中學習,然後綜合給出答案,那麼,它具備總結、綜合、列舉的能力,但不一定有“判斷數據真偽”的能力。

如果是這樣,那麼”如何識別內容真偽,防止AI在內容裡下毒”

也會是新的課題和機會。