撰文:玄寧

來源:矽星人

進入2023 年,ChatGPT 著實讓人類感受了一把被AI 支配的恐懼。

它超強的上下文理解,泛化,學習和推理能力,以逼近人類互動體驗的方式呈現出來,讓所有人耳目一新。哪怕它和它的同類競品紛紛暴露出諸多的問題,依然難阻人們每天驚呼一次「奇點」來臨,日日擔心自己的工作被取代,紛紛轉述比爾蓋茨,納德拉和黃仁勳們對ChatGPT 的讚賞。各路人馬也紛紛行動起來,最新的是馬斯克,在批評了自己參與創辦但早已沒有股份的OpenAI 旗下ChatGPT 的安全問題後,隨即傳出他自己正在計劃組隊開發ChatGPT 的替代品。

一切都飛快的發展著,這個沉寂了一段時間的行業終於又被焦慮和聒噪籠罩,這給人一種錯覺:

彷彿這場關於ChatGPT 的競爭就要在一夜之間決出勝負。

圖源:Unsplash

而在這些焦躁裡,那些本該更清晰指向這場競爭真正本質的特徵——ChatGPT 的千億參數,每一次調用的可觀費用,OpenAI 坐的多年冷板凳等等——也被用於了製造短期恐慌。這些或主動或無意的討論事實上都在糾結於ChatGPT 裡「chat」的部分——對商業模式,對可能改變的人類對互聯網的使用習慣以及對錯失新投資或是投機機會的恐慌。

這些焦慮對想把水攪渾而入局的人以及煽動人工智能威脅論的人們來說是喜聞樂見的,但對於真正理性看待這場技術競爭是無益的。

某種意義上,與其說ChatGPT 證明了某一條AI 研究路線的成功,倒不如說它更大的意義是證明了AI 這些年不斷收斂但依然存在多種選擇的各類路線裡,最終真的是會走出一條路的:也就是,它第一次證明了這場技術革命真的會到來。

而當我們真的把它當作一場技術革命來看時,就會明白這是一場將持續很久的複雜系統的比拼,也才有可能尋找到真正具備競爭能力的中國參與者,會明白這場新的技術浪潮的競爭不會「濃縮於一個晚上」。

讓Chat 的歸Chat,GPT 的歸GPT

「ChatGPT 是AI 的iPhone 時刻。」英偉達創始人及CEO 黃仁勳在近期的一次演講裡形容。 「iPhone 時刻」的說法隨之變得十分流行,它代表了今天對ChatGPT 的熱鬧討論裡非常流行的思考方式——人們與AI 終於找到了最佳交互界面,從此一切新技術都可以用來替代舊應用。而這也成了很多中國的焦慮者參與ChatGPT「創業潮」的通行證。

但這種「iPhone 時刻」的說法,有道理,但無益處。

與黃仁勳類似,微軟創始人比爾蓋茨和微軟現在的CEO 納德拉也對ChatGPT 做了與黃仁勳「互文」般的表達:比爾蓋茨把它的意義比作互聯網的誕生,納德拉說它堪比工業革命。但對這幾家公司在最近這波浪潮裡的角色稍加分析,就會明白,通過投資OpenAI 而佔盡ChatGPT 紅利的微軟,和因為ChatGPT 而再次進入新的「收稅」模式的英偉達,如此表達的另一層含義,是希望這場技術革命最終建立在它們自己的商業帝國之上。

至少現在來看,iPhone 時刻還只是他們的,並不是我們的。

因此跟著這樣的思路去討論是偷懶的且無益的,尤其是作為ChatGPT 沒有率先誕生在中國這個事已成事實的今天,它只會讓人們繼續關注被他人定義的「Chat」的部分,著急的去跟著iPhone 做應用,最終給iPhone 添磚加瓦;它也會讓人們陷入窘迫而難以靜下來,無暇真正了解我們自己「GPT」部分的進展。

在大模型上,一些從業者早已對「iPhone」時刻足夠警惕,對建立在它人底座上的模式創新已有充足反思和警惕,並已付諸了行動。

OpenAI 在2020 年發布了1750 億參數的GPT3,根據公開資料,那之後中國公司和機構發布的超過千億參數規模的大模型包括百度發布的Ernie(文心),華為發布的盤古大模型,和阿里巴巴發布的M6 大模型等。

2021 年,百度基於其已有的ERNIE 模型框架,發布了百億參數的對話大模型PLATO-XL,到了最新發布的ERNIE 3.0 Zeus,模型已有千億級參數。結合自身的PaddlePaddle 訓練框架,讓Ernie 從一開始的對中文語境的優化到現在得到全球研究者越來越多的關注。 2021 年4 月, 華為對外公佈了盤古大模型。根據公開資料,其在預訓練階段學習了40TB 的中文文本數據,並也已達到千億級參數規模。

而2021 年4 月,阿里巴巴達摩院發布的270 億參數語言大模型PLUG,被稱為中文版「GPT-3」。同年阿里巴巴還發布了國內首個千億參數多模態大模型M6。

圖源:達摩院官網

阿里巴巴的這兩個大模型都在過去幾年繼續進化, 2021 年10 月,PLUG 模型實現2 萬億參數,2022 年11 月,它所屬的阿里通義-AliceMind,在中文語言理解領域權威榜單CLUE 中首次超越人類成績。而M6 在不斷提高著訓練效率,2021 年10 月,達摩院使用512 卡GPU 即訓練出全球首個10 萬億參數大模型M6,同等參數規模能耗為此前業界標杆的1%。並且,M6 還在進一步做多模態的打通。達摩院的諸多模型集成在2022 年發布的「通義」大模型系列中。

這些大模型的進步也引來了包括OpenAI 在內的同行的關注,OpenAI 的前政策主管Jack Clark 曾公開點評M6 模型,稱它「規模和設計都非常驚人。這看起來像是眾多中國的AI 研究組織逐漸發展壯大的一種表現。」

可以看出,中國的參與者並不少,參與的也並不晚,成果也並非乏善可陳,否認這一點是虛無的。而且,但凡親自訓練過大模型的研究者都不難得出結論:最好的方式就是在已有建制的基礎上去繼續加速。

因為今天諸多對AI 模型的研究已經發現,大模型許多能力上的驚人突破,並非一個線性的過程,而是會在模型尺寸達到一個量級時發生突然的「進化」,也就是「突現」。不管你喜不喜歡,但事實就是,雖然AI 看起來高大上,但它的突破需要的,的確是一次不期而至的「大力出奇蹟」。

但如果留意最近一段時間的討論,會發現一些此前曾表示開發出大模型的機構和領頭者或明星科學家,卻選擇跳離這些機構,避而不談曾經高調宣揚的自己已有的進展,放棄更接近突現的節點而去從零開始,背後原因可能不言自明。

一些人抓住「一生一遇」機會的方式,是追隨別人的iPhone 時刻而去,試圖重新來過,過度興奮於「chat」高度擬人的實現效果帶來的資本與商業想像力。但那些真正在產業裡摸爬的中國科技公司,那些真正花很多年的心血打造自己的大模型的中國人工智能科學家們心裡清楚:真正的屬於自己的iPhone 時刻,不在眾聲喧嘩之側,不在「chat」本身,而是在「GPT」上,也就是自己曾經多年的辛苦建模、訓練和調參的基礎之上。

只有讓Chat 的歸Chat,才能讓GPT 的歸GPT,自己的GPT,比什麼都重要。

論系統戰,論持久戰

當我們從這種「歷史在一夜之間改變」的興奮脫離出來,會明白大模型的競爭是一場全面戰爭,它像所有歷史上波瀾壯闊的技術變革一樣,也將是曠日持久的。

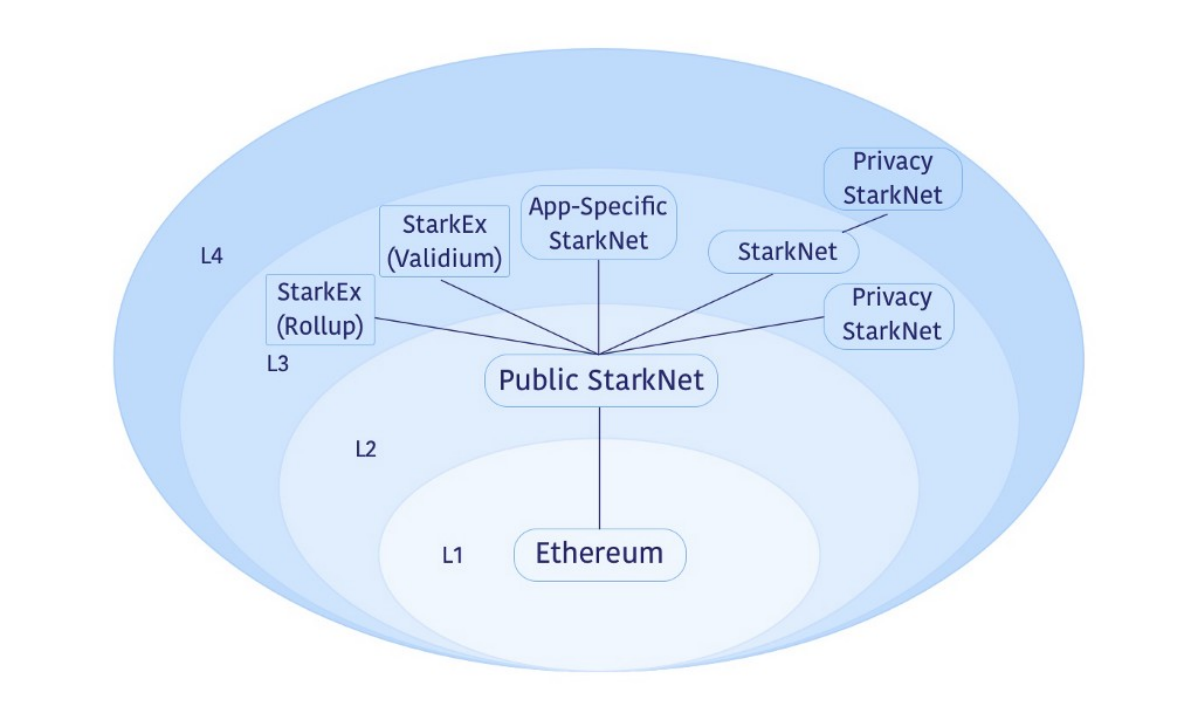

這種全面戰爭首先體現在它不只是某一個模型的問題,而是一個系統的問題。

在人們津津樂道的微軟借助OpenAI 逆襲谷歌的故事裡,有些被忽略的是微軟提供給OpenAI 的雲計算能力對ChatGPT 的重要性。

根據公開資料,微軟為OpenAI 的GPT3 訓練,提供了一個有一萬塊GPU 的分佈式集群,並且這些昂貴的計算資源和計算能力也專門為OpenAI 做了優化。

微軟的雲計算Azure,為OpenAI 建立和部署了多個大規模的高性能計算(HPC)系統,根據一些研究數據,微軟Azure「與其他雲服務對手相比,為每個GPU 提供了近2 倍的計算吞吐量,並且由於其網絡和系統軟件的優化,可以近乎線性地擴展到數千個GPU。在模型推理方面,微軟Azure 更具成本效益,每美元的推理能獲得2 倍的性能。」

這說明類似ChatGPT 的大模型是AI+ 雲計算的全方位競爭,需要超大規模智算平台對芯片、系統、網絡、存儲到數據進行全盤系統優化。

這些作為基礎設施的計算平台提供的不只是高效率的支持,往後更多的甚至是定制化的支持——一丁點的算力浪費,都會是這場競爭裡致命的成本。

這種複雜的系統是以雲計算為代表的新技術發展到極高複雜度階段的結果,而中國科技公司在這個技術週期裡生長出來的技術自覺和為此付出的長期努力,讓它們也擁有了自己的複雜系統,從而也有了參與這場ChatGPT 競爭的「入場券」。

其中能力最為完備的當屬阿里巴巴,因為雲、數據、系統和芯片。

阿里雲的飛天智算平台在去IOE 的過程中誕生,逐漸成長為一個超大規模的高性能計算集群,並且已是國內唯一能實現萬卡規模的AI 集群。它在一個超大規模高性能網絡中,構建了一個可以持續進化的智能算力系統,與此同時,阿里云自研的高性能集合通信庫ACCL 和自研的網絡交換機也建立了無擁塞、高性能的集群通訊能力。

據公開資料,飛天智算平台的千卡並行效率達90%。針對數據密集型場景的大規模集群,還進行了數據IO 優化,通過自研KSpeed 和RDMA 高速網絡架構,最高可將存儲IO 性能提升10 倍,將時延顯著降低了90%。此外飛天智算平台的機器學習平台PAI,專門針對AI 大模型推理和訓練場景進行針對性優化,可將計算資源利用率提高3 倍以上,AI 訓練效率提升11 倍,推理效率提升6 倍。阿里的M6 模型,在訓練階段使用的正是阿里雲機器學習PAI 平台自研的分佈式訓練框架EPL(Easy Parallel Library)。

這場全面戰爭還體現在,它並不是一場比拼誰更接近標準答案的戰爭。

圖源:Unsplash

大模型本身也是一個精妙的系統,它不會只有一個答案,甚至無法只有一個答案。一個例證就是,ChatGPT 的真正復現到今天依舊無人實現。一方面,是技術本身越來越閉源,另一方面,真正實現性能突破的許多關鍵環節,有時真的是一種藝術性的存在,或者更直白的說,是碰運氣的過程,因此沒有答案可抄。

比如,根據GPT3 的論文,這個模型的大小和數據量,是根據OpenAI 自己的擴展規律決定,因此對於另外一個模型,哪怕是同樣的算力條件,模型和數據的配比也可以有不同的思路,GPT3 最終的配方是1750 億參數和2500 億token 的數據,而另一個知名的類似模型,DeepMind 旗下的Chinchilla,則是1100 億參數和5000 億token,但後者在一些性能上也與GPT3 不相上下。也就是,任何一種「配方」都很難直接使用,它很大程度取決於基礎模型的特點,很多時候在那些模型的論文裡簡單的一句結論,背後就是巨大的試錯成本。

這是挑戰,但也是機遇所在:能最極致的做好「軟硬件結合」的模型和平台,就有機會用最適合自己的配方更進一步。

最典型的當屬英偉達。當幾乎所有的模型訓練都需要在它的硬件上完成,最能發揮硬件性能的軟件框架自然也最可能由英偉達製造。英偉達發布的NeMo Megatron 就曾宣稱僅用11 天就完成了GPT-3 的訓練,還和微軟合作,在6 週內完成了Megatron 的一個5300 億參數模型的訓練。

同樣的,阿里雲的計算硬件,軟件平台和大模型的全方位系統優化,也帶來效率的提升。通義-M6 已經實現使用512 位GPU 在10 天內訓練出具有可用水平的10 萬億模型的能力,相比GPT-3,同等參數規模能耗僅為其1%,此外達摩院研發的超大模型落地關鍵技術S4 框架(Sound、Sparse、Scarce、Scale)也提供了「濃縮」能力,讓百億參數大模型在高壓縮率下仍能高精度完成多個任務,使「通義」系列模型已在服務的200 多個場景中實現了2%-10% 的應用效果提升。

也就是說,這場全面競爭裡最需要的是一個自己的方案,一個能自主掌控更多環節從而實現全局調優的自己的方案。這樣的能力更重要的意義在於,它們將不只是用於跟隨——面對一場全面的技術浪潮,人們往往習慣在短期過於興奮與高估,激動的把開局理解為終結,但事實上技術浪潮會是長期的。這也是每一場全面戰爭裡都會發生的事情。而擁有自己的複雜系統掌控能力和基於此的技術理解能力,會在長期的競爭裡提供一定的技術定力。

對於當前的ChatGPT 來說,它其實有著鮮明的開局感:它基本上還是一個語言模型,而AI 研究者這些年已經開始奮力追逐多模態模型——過往人工智能模型有些八仙過海的意味,架構眾多,但2017 年之後,Transformer 的出現改變了這種趨勢,這之後算法架構從包括ChatGPT 的NLP 到視覺都迅速統一到以Transformer 為底層架構的路線,於是不同模態的模型更有了統一的可能。因此,某種意義上,ChatGPT 可能只是未來真正「恐怖」的多模態大模型的第一個明確了的組成部分。

這樣的一場全面戰爭剛剛開始。曾經因為相信所以看見而衍生出來的技術路線,讓一些中國互聯網公司在技術浪潮來臨前握住了那最初的浪花,而今天ChatGPT 預示了大浪終將到來,對於那些用了多年建立起來自己的技術完備能力的中國互聯網巨頭來說,終於到了因為看見所以相信的時刻。

聲明:本內容為作者獨立觀點,不代表0x财经 立場,且不構成投資建議,請謹慎對待,如需報導或加入交流群,請聯繫微信:VOICE-V。

來源:矽星人