每一個大模型都是一台昂貴的“碎鈔機”,這已經成為各路AI 觀察家們津津樂道的常識。

作者:陳彬

編輯:戴老闆

每一個大模型都是一台昂貴的“碎鈔機”,這已經成為各路AI 觀察家們津津樂道的常識。

大模型訓練成本有一個簡單的比例:訓練費用跟參數量的平方成正比。比如OpenAI 訓練1750 億參數的GPT-3 費用大概是1200 萬美元,訓練5000 億參數(業界預估)的GPT-4 成本就飆升至1 億美元。

成本大都來自GPU 使用時長。 Meta 訓練650 億個參數的LLaMA 模型耗費100 萬個GPU 小時;HuggingFace(號稱機器學習屆的GitHub)訓練Bloom 模型耗費了超過兩個半月的時間,使用的算力相當於一台裝有500 個GPU 的超級計算機。

Google 在訓練5400 億參數的PaLM 模型時,在6144 塊TPU v4 芯片上訓練了1200 小時,然後又在在3072 塊TPU v4 芯片上訓練了336 小時,總共消耗了2.56 e24 FLOPs 的算力,折合成Google 雲計算的報價,大概在900~1700 萬美元左右。

但是……幾百上千萬美金的訓練費用和幾億美金的硬件投入,相比AIGC 開啟的浪潮,真的算貴嗎?

微軟2022 年的淨利潤是727 億美金,Google 是600 億美金,Meta 則是230 億美金,在OpenAI 花費460 萬美金訓練GPT-3 之前,這些巨頭都投入了幾十甚至上百億美金用來尋找所謂的“新方向”。

微軟迄今為止向OpenAI 投入了100 多億美金,這個數字看起來很多,但要知道微軟當年收購LinkedIn 就花了262 億美金,而在更早的時候收購諾基亞手機業務花了71.7 億美金,基本等於打了水漂。

Meta 則花了更多“冤枉錢”來尋找第二曲線。 2021 年扎克伯格把Facebook 的名字改成了“Meta”,投入巨資All in 元宇宙,2022 年元宇宙部門虧損137 億美元。在ChatGPT 問世之前,Meta 甚至一度準備把2023 年的20% 預算投入到元宇宙中去。

Google 對AI 一向重視,不僅收購了“前GPT 時代”的明星DeepMind,還是Transformer 這一革命性模型的提出者,但Google 並沒有像OpenAI 那樣孤注一擲地“死磕”大語言模型,而是在多個方向上“撒胡椒面”——總投入並不少,但效果加起來都不如一個ChatGPT。

拉開視野來看,全球科技巨頭——包括國內的大型互聯網企業在移動互聯網滲透率見頂之後,展開了慘烈的“存量博弈”,卷算法推薦、卷短視頻、卷Web3、卷本地生活……投入的資金遠遠超過OpenAI 在ChatGPT 誕生前燒掉的10 億美金。

發現新大陸的費用,跟舊大陸的內耗向來不在一個數量級。歐洲人在哥倫布發現新大陸之前內捲了1000 年,而發現新大陸只花了西班牙王室投資的200 萬馬拉維迪(大約14000 美元)——跟新大陸給世界帶來的變化相比,這點兒錢其實微不足道。

事實上,“資金”從來都不是啟動本輪AI 浪潮的核心因素。真正核心的因素是另外兩個字:信仰。

蠻力的神蹟

ChatGPT 走紅後,好事兒的媒體跑去採訪了Google 旗下的DeepMind 創始人Demis Hassabis。

被OpenAI 搶去了所有風頭的Hassabis 言辭有點兒不客氣:“面對自然語言這一挑戰,ChatGPT 的解決方案如此不優雅——僅僅是更多的計算能力和數據的蠻力,我的研究靈魂對此倍感失望。”

Demis Hassabis 和柯潔

這句話聽起來很“酸”,然而他接著話鋒一轉:“但這的確是獲得最佳結果的方式,所以我們(的大模型)也以此為基礎。”意思就是雖然不太認同,但OpenAI 的“蠻力”真的很香,我們也不得不去學。

Hassabis 身段靈活,但早期對“蠻力”這件事的態度,讓Google 和OpenAI 有了致命的分野。

2017 年,谷歌在論文中公開了革命性的Transformer 模型,業界逐漸意識到這個模型對於構建AGI(通用人工智能)的意義。然而,基於同樣的Transformer,谷歌與OpenAI 卻走上了兩條不同的兩條路。

OpenAI 旗幟鮮明地從Transformer 構建大語言模型,瘋狂堆參數,2018 年6 月發布GPT-1,參數1.17 億;2019 年2 月發布GPT-2,參數15 億;2020 年5 月發布GPT-3,參數1750 億,在蠻力的道路上“一條路走到黑”。

而Google 雖然也地祭出BERT(3 億參數)、T5(110 億參數)和Switch Transformer(1.6 萬億參數),表面上跟OpenAI 鬥的有來有回,但光從模型的名字就能看出來:Google 總在更換模型搭建的策略,而OpenAI 的策略更單一更專注。

比如GPT-2 和GPT-1 相比,OpenAI 沒有重新設計底層結構,而是將Transformer 堆疊的層數從12 層增加到48 層,並使用了更大的訓練數據集,而GPT-3 進一步把層數增加到了96 層,使用比GPT-2 還要大的數據集,但模型框架基本上沒有改變。

另外,基於Transformer 的大模型演化有三個分支:Encoder Only,Encode-Decoder,Decoder Only。 OpenAI 一直堅持只用Decoder Only 方案,而Google 則變來變去:BERT 模型使用Encoder Only,T5 模型又改成了Encode-Decoder。

等到OpenAI 突破後,Google 匆忙轉向Decoder Only 方案(PaLM 模型),時間已經錯失了至少一年半。

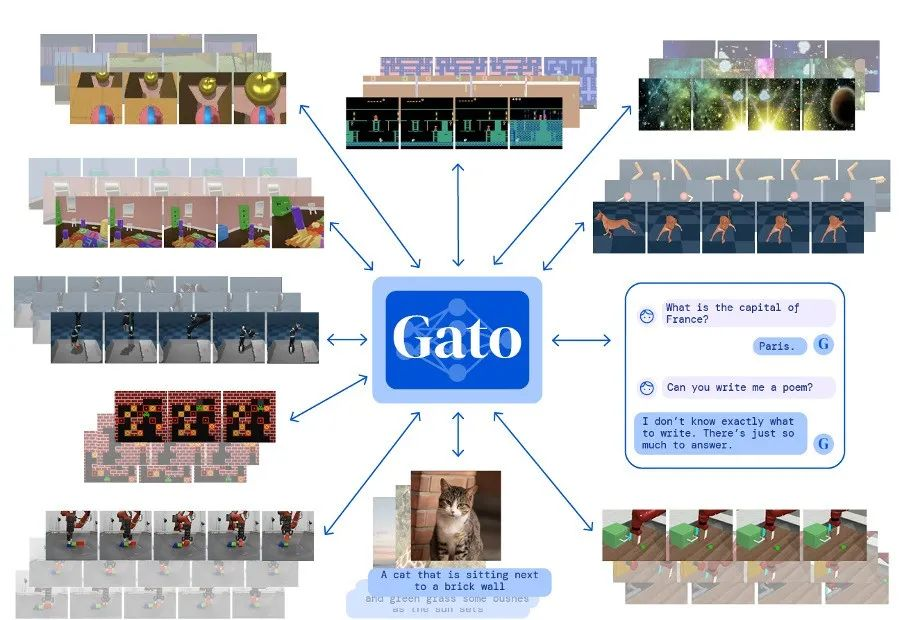

在跟OpenAI 的軍備競賽中,Google 卻總沉浸在一些貌似炫酷,但實則對AI 缺乏信心的產品上——比如2022 年發布的Gato。 Gato 的思路是先做一個大模型底座,然後再灌不同的數據,以此生成出大量小模型——每個小模型都有特定的能力。

這麼做的目的是讓單個AI 具備盡可能多的功能,更加通用。做一個簡單的類比:谷歌路線相當於讓一個上完九年義務教育的12 歲小孩兒,去參加鋼琴、寫作、編程、舞蹈等一系列專業技能培訓班,靠著“1+1+1…”培養出一個多才多藝的“全才”。

Gato 能執行604 種不同的任務,包括給圖片配文、玩雅達利遊戲、操作機械臂搭積木。不過,Gato 雖做到了“通才”,但實用性卻相當堪憂:其中近一半功能,還不如便宜小巧的“專才AI”好使,有媒體評價:一個平庸的人工智能。

“萬能”但又不那麼萬能的Gato

“萬能”但又不那麼萬能的Gato

相比之下,OpenA 更熱衷於讓AI“做好一件事”,即像人類一樣理解自然語言——這是通向AGI 的必經之路。

在所有站在Transformer 模型肩膀上的團隊中,OpenAI 是把“蠻力”發揮到最淋漓盡致的一個,算力不夠就買算力,數據不夠就找數據,別人的牛逼技術我直接拿來用,反正就是要把規模堆上去。終於,在“暴力美學”的指引下,奇蹟出現了。

從成立第一天起,OpenAI 就把創造接近甚至超越人類的AGI(通用人工智能)作為幾乎唯一的目標。而且相比Google 的遲疑不定,OpenAI 發起人們(包括馬斯克)是真的相信AI 可以成為一個18 歲的成年人,而不是永遠停留在12 歲上打轉。

黃仁勳在今年3 月對談OpenAI 聯合創始人Ilya Sutskever 時,問了一個問題:“在這個(GPT 研發的)過程中,你一直相信,擴大規模會改善這些模型的性能嗎?”Ilya 回答道:“這是一個直覺。我有一個很強烈的信念,更大意味著更好。”

這是一場蠻力的勝利,但更是一種信仰的勝利。大模型回報給“信仰”的禮物,也遠超想像——隨著參數量的暴力提升,研究人員突然有一天發現大模型出現了令人驚喜,但又難以解釋的能力飆升。

他們找了一個老詞來形容這種現象:Emergence(湧現)。

虔誠的回報

Emergence(湧現)這個詞,常見於哲學、系統學、生物學等領域,其經典的定義是:當一個實體被觀察到具有各個部分單獨存在時不具備的屬性和能力時,這種現象就被稱之為“湧現”,早在古希臘時代,這種現象就被亞里士多德研究過。

後來,英國哲學家George Lewes 在1875 年第一次發明了Emergence 這個詞,用來專門形容上述現象。 1972 年,諾貝爾物理學獎得主Philip Anderson 撰寫了一篇名叫“More is Different”的文章,用一句經典的金句來給“湧現”做了解釋:

當一個系統的量變導致質變時,就稱之為“湧現”。

“湧現”被引入到大模型中,可以說是相當貼切:AI 工程師們觀察到一個現象,隨著模型的參數量越來越大,當超過某個閾值或者“臨界點”的時候——比如參數量達到100 億,模型會出現一些讓開發者完全意想不到的複雜能力——比如類似人類的思維和推理能力。

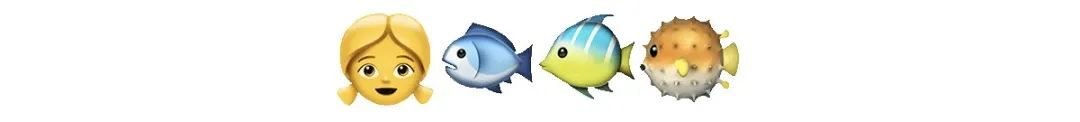

比如,Google 大模型測試基準BIG-Bench 裡有一項任務:給出4 個emoj 表情符號,讓模型回答代表什麼電影。簡單和中等複雜度的模型都回答錯了,只有參數超過100 億的大模型會告訴測試者 [4]:這是電影Finding Nemo(海底總動員)。

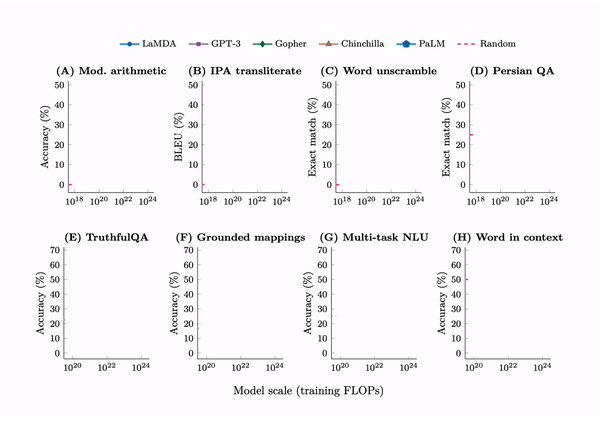

2022 年,來自Google、DeepMind、斯坦福和北卡萊羅納大學的學者分析了GPT-3、PaLM、LaMDA 等多個大模型 [3],發現隨著訓練時間(FLOPs)、參數量和訓練數據規模的增加,模型的某些能力會“突然”出現拐點,性能肉眼可見地驟然提升。

這些“湧現”能力超過了137 多種 [5],包括多步算術、詞義消歧、邏輯推導、概念組合、上下文理解等。這項研究給大模型的“湧現”下了一個定義:如果一項能力只有在大模型中存在,在小模型中觀測不到,這項能力就是“湧現”出來的。

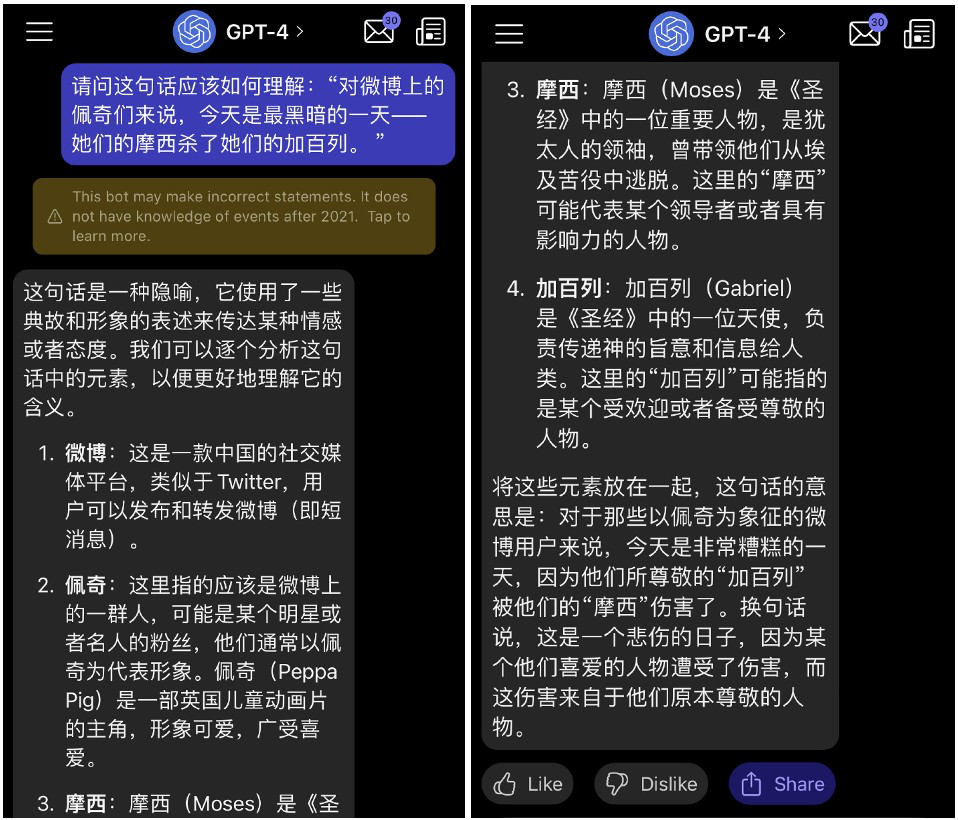

微博博主tombkeeper 做過這樣一個測試:在ChatGPT 剛誕生時,他將發表於2018 年的一篇充滿隱喻的微博——“對微博上的佩奇來說,今天是黑暗的一天——她們的摩西殺死了她們的加百列”,交給ChatGPT 理解,但ChatGPT 回答失敗了。

來源:微博tombkeeper

來源:微博tombkeeper

而等到2023 年3 月OpenAI 推出了GPT-4,tombkeeper 再次將這個問題扔給AI,回答基本接近滿分。

來源:微博tombkeeper

來源:微博tombkeeper

Google 在訓練大模型PaLM 時,也發現隨著參數規模的增加,模型會不斷“湧現”出新的能力。

當最終把PaLM 的參數堆到5400 億時,模型就具備了區分因果關係、理解上下文概念、解釋冷笑話等能力。比如像前文一樣根據4 個emoj 表情符號來猜電影名字。

對於大模型“湧現”的背後邏輯,現在幾乎沒有科學家能徹底講清楚。這讓人想起了1950 年阿蘭・圖靈在《計算機器與智能》這篇論文中論述過一個觀點:“學習機器有一個重要的特徵,即它的老師往往對機器內部運行情況一無所知。”

當然,有人對此欣喜若狂,有人則會覺得毛骨悚然。不過無論是哪一派,都不得不承認那句老話:大力真的能出奇蹟。 “大力”背後就是信仰——人類一定可以用矽基來模仿大腦結構,最終實現超越人類的智能。而“湧現”告訴我們:這一刻越來越近了。

信仰的充值

有信仰,就要對信仰充值。中世紀基督徒用的是贖罪券,新世紀AI 信徒用的則是晶體管。

文心一言面世之後,李彥宏的一段採訪曾衝上熱搜——李廠長直言“中國基本不會再誕生一家OpenAI”,這似乎有點兒不太給王慧文面子 [9]。但這一觀點確實有理有據:大模型軍備競賽,大概率會比曾經燒掉數十億美金的網約車戰爭還要慘烈。

如果按照業界預估的成本,GPT-4 訓練成本大約在1 億美金左右,GPT-3 的訓練費用也要1200 萬美元。先不說昂貴的人才團隊費用,王慧文的5000 萬美元光是投入到GPU 購買或租賃上,都顯得捉襟見肘。

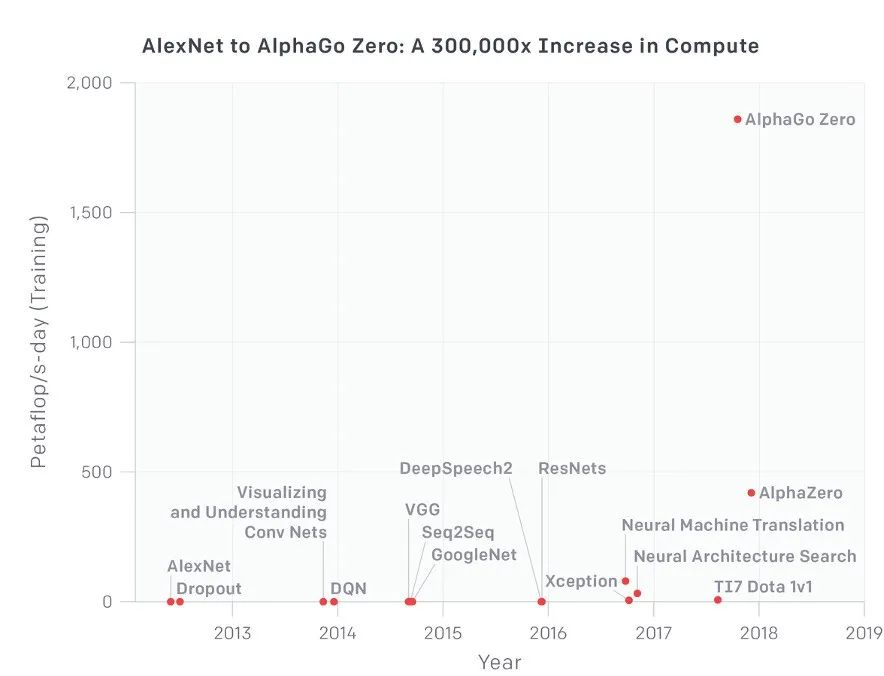

大模型發展的三要素:算法、算力、數據。其中算力是數字時代的“石油”,未來的缺口一定會越來越大。自2012 年開啟黃金時代後,AI 對算力的需求開始呈現指數級增長。從2012 年的AlexNet,到2017 年的AlphaGo Zero,算力消耗足足翻了30 萬倍。

訓練大模型需要專門的GPU 集群,傳統數據中心的用場不大。微軟為了“迎娶”OpenAI,曾特地配備了一台擁有數万塊A100 與H100 GPU 的超級計算機,光硬件入場費就花了近10 億美金 [1]。

即便如此,據相關機構測算,由於ChatGPT 與GPT-4 的訪問量仍在增長,10 億美金的超級計算機馬上又要不夠用了。要么進一步擴大算力,要么只能盡力控製成本,繼續採用限流等手段 [12]。

英偉達AI 超算產品的第一個客戶,就是OpenAI

對此,貼心的賣鏟人英偉達推出了AI 超算雲服務:租賃8 塊旗艦版A100,每月只需37000 美元,童叟無欺。若要達到訓練GPT-4 的算力(一萬塊A100)月租金需4600 萬美元左右——每月淨利潤不足一個小目標的企業,的確可以洗洗睡了。

跟用神經網絡來模仿大腦一樣,AI 算力的昂貴也跟人腦的屬性保持一致。

一個人的大腦大約有860 億個神經元,每個神經元平均跟其它7000 個神經元相連接,所以大約有6000 萬億個連接。儘管大腦的重量只佔人體的2% 左右,但當無數神經元連接工作的時候,它們每天需要消耗人體總能量的20%~30%。

因此,即使是碳基生物的“智能”,也是一種暴力堆砌神經元後的“湧現”,對能量的消耗巨大。而相比經過上億年進化的碳基神經元,晶體管構建的神經網絡離“低功耗”相距甚遠——比如柯潔功率是20 w,而跟他下棋的AlphaGo 功耗是他的5 萬倍。

因此,人類要想做出真正的AGI,還需要繼續給信仰來充值。

對全人類來說,這種充值顯然是無比划算的。仔細算一算,OpenAI 燒掉的10 億美金,不僅給全球的科技公司找到了一片“新大陸”,還給愈發內捲的全球經濟點亮了增量邏輯。在美元氾濫的當下,還有比這10 億美元性價比更高的項目嗎?

當“新大陸”被發現後,全世界都會蜂擁而至。比爾・蓋茨雖然現在是AI 的狂熱鼓吹者,但早在微軟第一次投資OpenAI 時,他是強烈的懷疑者,直到去年年底看到GPT-4 的內部演示才對外表示:It’s a shock,this thing is amazing。

比爾・蓋茨在未來可能擁有人工智能領域最雄偉大廈的冠名權,但OpenAI 的創始人們、以及更多連接主義學派的人工智能先驅,值得人們在廣場上樹立雕像。大模型的煉丹之路,信則靈,不信則妄,跟風的投機主義者不配留下姓名。

最後,人類通往地獄或者天堂的道路,一定是由AI 虔誠的信徒用一顆顆晶體管鋪就的。

參考資料

[1] ChatGPT and generative AI are booming, but the costs can be extraordinary, CNBC

[2] Microsoft spent hundreds of millions of dollars on a ChatGPT supercomputer,The Verge

[3] Emergent Abilities of Large Language Models, Jason Wei 等,TMLR

[4] The Unpredictable Abilities Emerging From Large AI Models

[5] 137 emergent abilities of large language models, Jason Wei

[6] Harnessing the Power of LLMs in Practice

[7] Alphabet’s Google and DeepMind Pause Grudges, Join Forces to Chase OpenAI,The Information

展開全文打開碳鏈價值APP 查看更多精彩資訊