撼動英偉達的壟斷,沒那麼容易。

ChatGPT爆火之後,谷歌和微軟兩巨頭的AI大戰戰火,已經燒到了新的領域——服務器芯片。

如今,AI和雲計算都成了必爭之地,而芯片,也成為降低成本、贏得商業客戶的關鍵。

原本,亞馬遜、微軟、谷歌這類大廠,都是以軟件而聞名的,而現在,它們紛紛斥資數十億美元,用於芯片開發和生產。

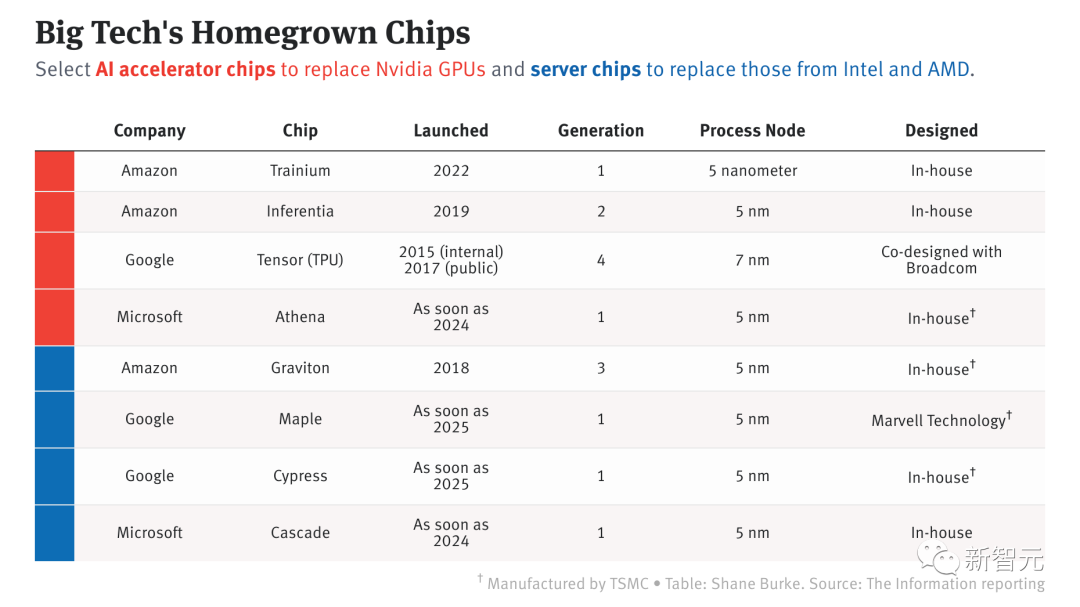

各大科技巨頭研發的AI芯片

ChatGPT爆火,大廠開啟芯片爭霸賽

根據外媒The Information的報導以及其他來源,這三家大廠現在已經推出或計劃發布8款服務器和AI芯片,用於內部產品開發、雲服務器租賃或者二者兼有。

「如果你能製造出針對AI進行優化的矽,那前方等待你的將是巨大的勝利」,研究公司Forrester的董事Glenn O’Donnell這樣說。

付出這些巨大的努力,一定會得到回報嗎?

答案是,並不一定。

英特爾、AMD和英偉達可以從規模經濟中獲益,但對大型科技公司來說,情況遠非如此。

它們還面臨著許多棘手的挑戰,比如需要聘請芯片設計師,還要說服開發者使用他們定制的芯片構建應用程序。

不過,大廠們已經在這一領域取得了令人矚目的進步。

根據公佈的性能數據,亞馬遜的Graviton服務器芯片,以及亞馬遜和谷歌發布的AI專用芯片,在性能上已經可以和傳統的芯片廠商相媲美。

亞馬遜、微軟和谷歌為其數據中心開發的芯片,主要有這兩種:標準計算芯片和用於訓練和運行機器學習模型的專用芯片。正是後者,為ChatGPT之類的大語言模型提供了動力。

此前,蘋果成功地為iPhone,iPad和Mac開發了芯片,改善了一些AI任務的處理。這些大廠,或許正是跟蘋果學來的靈感。

在三家大廠中,亞馬遜是唯一一家在服務器中提供兩種芯片的雲服務商,2015年收購的以色列芯片設計商Annapurna Labs,為這些工作奠定了基礎。

谷歌在2015年推出了一款用於AI工作負載的芯片,並正在開發一款標準服務器芯片,以提高谷歌云的服務器性能。

相比之下,微軟的芯片研發開始得較晚,是在2019年啟動的,而最近,微軟更加快了推出專為LLM設計的AI芯片的時間軸。

而ChatGPT的爆火,點燃了全世界用戶對於AI的興奮。這更促進了三家大廠的戰略轉型。

ChatGPT運行在微軟的Azure雲上,使用了上萬塊英偉達A100。無論是ChatGPT,還是其他整合進Bing和各種程序的OpenAI軟件,都需要如此多的算力,以至於微軟已經為開發AI的內部團隊分配了服務器硬件。

在亞馬遜,首席財務官Brian Olsavsky在上週的財報電話會議上告訴投資者,亞馬遜計劃將支出從零售業務轉移到AWS,部分原因是投資於支持ChatGPT所需的基礎設施。

在谷歌,負責製造張量處理單元的工程團隊已經轉移到谷歌云。據悉,雲組織現在可以為TPU和在其上運行的軟件製定路線圖,希望讓雲客戶租用更多TPU驅動的服務器。

谷歌:為AI特調的TPU V4

早在2020年,谷歌就在自家的數據中心上部署了當時最強的AI芯片——TPU v4。

不過直到今年的4月4日,谷歌才首次公佈了這台AI超算的技術細節。

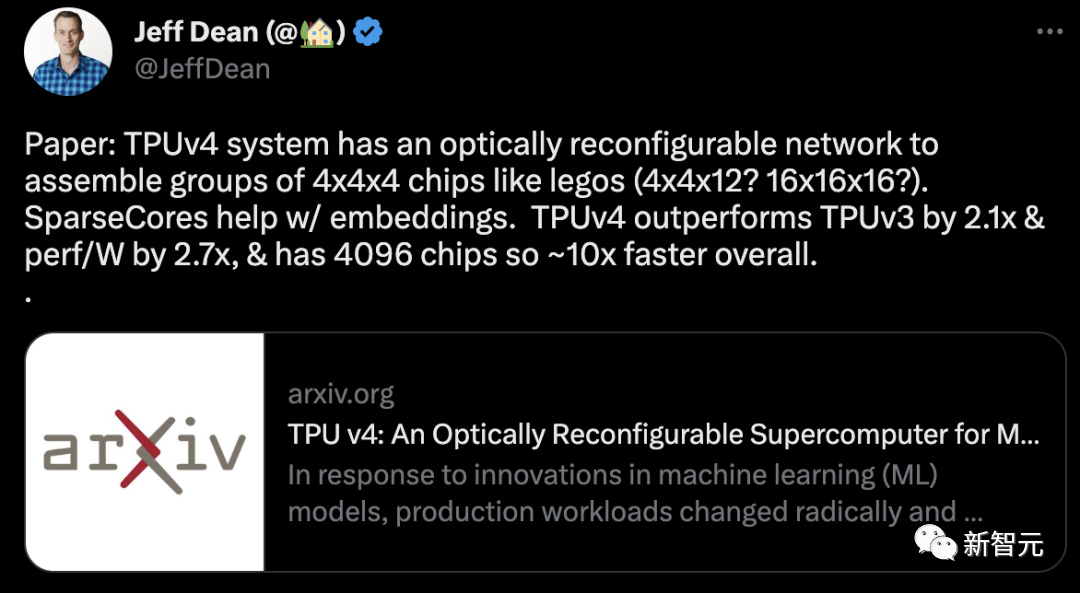

相比於TPU v3,TPU v4的性能要高出2.1倍,而在整合4096個芯片之後,超算的性能更是提升了10倍。

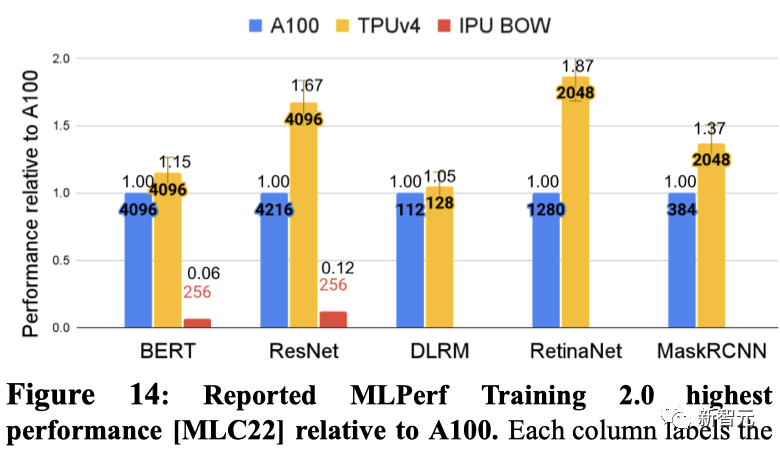

同時,谷歌還聲稱,自家芯片要比英偉達A100更快、更節能。對於規模相當的系統,TPU v4可以提供比英偉達A100強1.7倍的性能,同時在能效上也能提高1.9倍。

對於相似規模的系統,TPU v4在BERT上比A100快1.15倍,比IPU快大約4.3倍。對於ResNet,TPU v4分別快1.67倍和大約4.5倍。

另外,谷歌曾暗示,它正在研發一款與Nvidia H100競爭的新TPU。谷歌研究員Jouppi在接受路透社採訪時表示,谷歌擁有「未來芯片的生產線」。

微軟:秘密武器雅典娜

不管怎麼說,微軟在這場芯片紛爭中,依舊躍躍欲試。

此前有消息爆出,微軟秘密組建的300人團隊,在2019年時就開始研發一款名為「雅典娜」(Athena)的定制芯片。

根據最初的計劃,「雅典娜」會使用台積電的5nm工藝打造,預計可以將每顆芯片的成本降低1/3。

如果在明年能夠大面積實裝,微軟內部和OpenAI的團隊便可以藉助「雅典娜」同時完成模型的訓練和推理。

這樣一來,就可以極大地緩解專用計算機緊缺的問題。

彭博社在上週的報導中,稱微軟的芯片部門已與AMD合作開發雅典娜芯片,這也導致AMD的股價在周四上漲了6.5%。

但一位知情者表示,AMD並未參與其中,而是在開發自己的GPU,與英偉達競爭,並且AMD一直在與微軟討論芯片的設計,因為微軟預計要購買這款GPU。

亞馬遜:已搶跑一個身位

而在與微軟和谷歌的芯片競賽中,亞馬遜似乎已經領先了一個身位。

在過去的十年中,亞馬遜在雲計算服務方面,通過提供更加先進的技術和更低的價格,一直保持了對微軟和谷歌的競爭優勢。

而未來十年內,亞馬遜也有望通過自己內部開發的服務器芯片——Graviton,繼續在競爭中保持優勢。

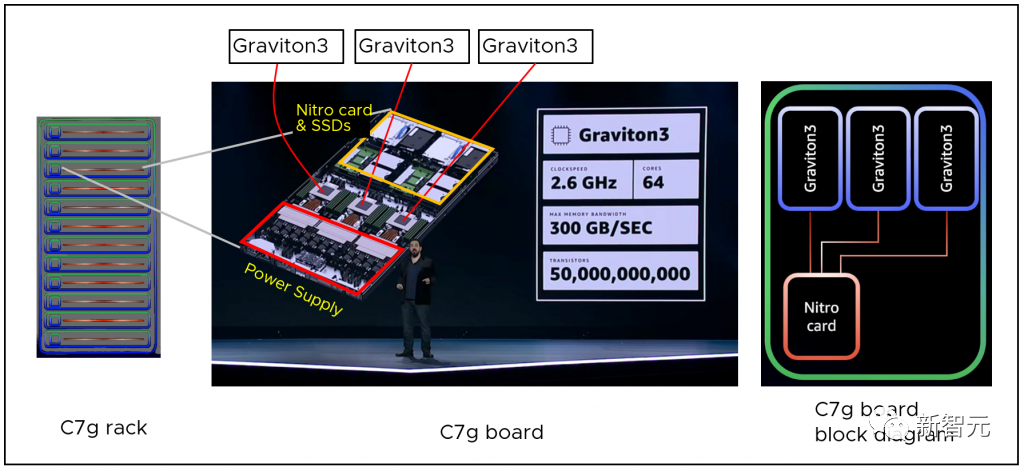

作為最新一代的處理器,AWS Graviton3在計算性能上比上一代提高多達25%,浮點性能提高多達2倍。並支持DDR5內存,相比DDR4內存帶寬增加了50%。

針對機器學習工作負載,AWS Graviton3比上一代的性能高出多達3倍,並支持bfloat16。

基於Graviton 3芯片的雲服務在一些地區非常受歡迎,甚至於達到了供不應求的狀態。

亞馬遜另一方面的優勢還表現在,它是目前唯一一家在其服務器中提供標準計算芯片(Graviton)和AI專用芯片(Inferentia和Trainium)雲供應商。

早在2019年,亞馬遜就推出了自己的AI推理芯片——Inferentia。

它可以讓客戶可以在雲端低成本運行大規模機器學習推理應用程序,例如圖像識別、語音識別、自然語言處理、個性化和欺詐檢測。

而最新的Inferentia 2更是在計算性能提高了3倍,加速器總內存擴大了4倍,吞吐量提高了4倍,延遲降低到1/10。

在初代Inferentia推出之後,亞馬遜又發布了其設計的主要用於AI訓練的定制芯片——Trainium。

它對深度學習訓練工作負載進行了優化,包括圖像分類、語義搜索、翻譯、語音識別、自然語言處理和推薦引擎等。

在一些情況下,芯片定制不僅僅可以把成本降低一個數量級,能耗減少到1/10,並且這些定制化的方案可以給客戶以更低的延遲提供更好的服務。

撼動英偉達的壟斷,沒那麼容易

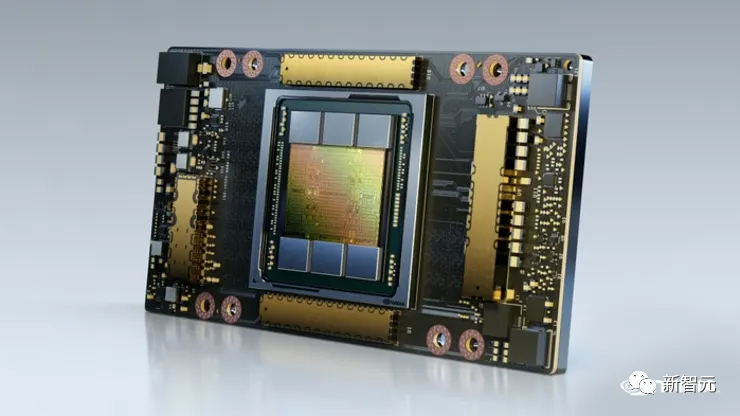

不過到目前為止,大多數的AI負載還是跑在GPU上的,而英偉達生產了其中的大部分芯片。

據此前報導,英偉達獨立GPU市場份額達80%,在高端GPU市場份額高達90%。

20年,全世界跑AI的雲計算與數據中心,80.6%都由英偉達GPU驅動。 21年,英偉達表示,全球前500個超算中,大約七成是由自家的芯片驅動。

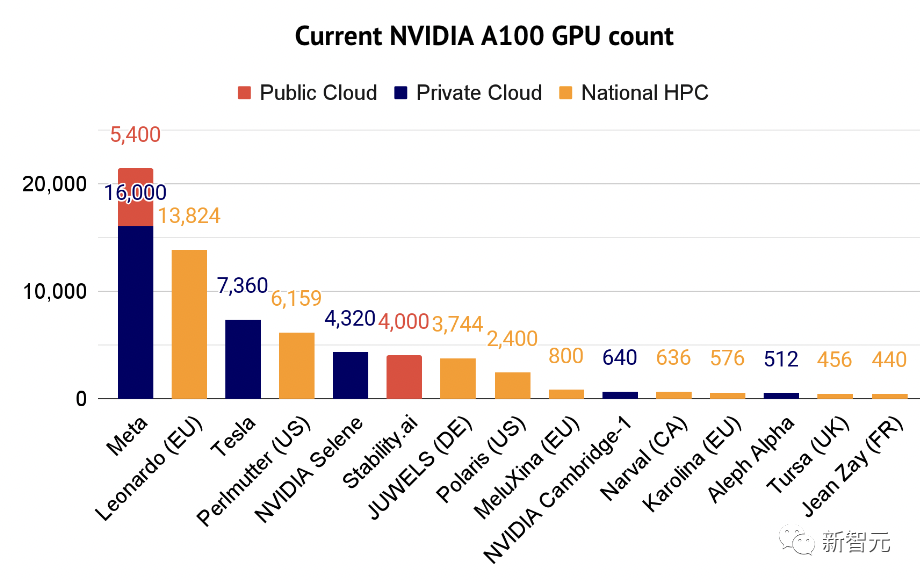

而現在,就連運行ChatGPT的微軟數據中心用了上萬塊英偉達A100 GPU。

一直以來,不管是成為頂流的ChatGPT,還是Bard、Stable Diffusion等模型,背後都是由每個大約價值1萬美元的芯片英偉達A100提供算力。

不僅如此,A100目前已成為人工智能專業人士的「主力」。 2022人工智能現狀報告還列出了使用A100超級計算機部分公司的名單。

顯而易見,英偉達已經壟斷了全球算力,憑藉自家的芯片,一統江湖。

根據從業者的說法,相比於通用芯片,亞馬遜、谷歌和微軟一直在研發的專用集成電路(ASIC)芯片,在執行機器學習任務的速度更快,功耗更低。

O’Donnell董事在比較GPU和ASIC時,用了這樣一個比較:「平時開車,你可以用普銳斯,但如果你必須在山上用四輪驅動,用吉普牧馬人就會更合適。」

然而儘管已經做出了種種努力,但亞馬遜、谷歌和微軟都面臨著挑戰——如何說服開發者使用這些AI芯片呢?

現在,英偉達的GPU是占主導地位的,開發者早已熟悉其專有的編程語言CUDA,用於製作GPU驅動的應用程序。

如果換到亞馬遜、谷歌或微軟的定制芯片,就需要學習全新的軟件語言了,他們會願意嗎?

展開全文打開碳鏈價值APP 查看更多精彩資訊