2023年,投資機構與股民們,正向AI芯片領域的上市公司,發起奪命三連問:

你做存算一體芯片了嗎?

(投資者向瀾起科技提問圖源:同花順財經)

存算一體芯片進度如何?

(投資者向東芯股份提問圖源:同花順財經)

存算一體芯片前景如何?

(投資者向恆爍股份提問圖源:同花順財經)

以上的一系列發問,意味著存算一體不再“停留”於學界與產界,儼然火到了二級市場:股民、券商機構正加班加點狂補存算一體的課,於是傳統芯片大廠從2023年初至今,一直被“拷問”存算一體的佈局情況。

一個自然而然的疑問是,存算一體為何突然變得如此火爆?

7.14發布新存儲產品OceanStor A310的華為,給出了自己的答案。華為數據存儲產品線總裁周躍峰表示,在通用大模型與行業大模型的訓練推理中面臨著諸多數據難題:海量數據跨域歸集慢、預處理與訓練中數據交互效率低、數據安全流動難。

AI大模型對存儲帶來了新的挑戰,比如穩定性相較於傳統AI更差,同時有大量的數據預處理和準備工作,需要用近存計算(存算一體的一種)來系統性處理這個問題。

那麼,這裡“大量的數據”究竟有多少?據偲睿洞察測算,現階段ChatGPT 日活一億,若每日有5%的人每秒同時提問,將會吞噬三峽大壩近一年的發電量。

換言之,大模型正瘋狂索取算力,而以存算一體為代表的新興解決方案能夠解決大模型帶來的諸多挑戰。而事實上,大模型除了對算力提出嚴苛要求外,也給了AI芯片廠商“不少糖吃”。

本文試圖探究,大模型背景下,給了AI芯片廠商怎樣的好處?被ChatGPT“帶火”的存算一體廠商,未來格局如何?

PART-01 “福禍相依”的AI芯片廠商

大模型的風還在呼嘯,有關大模型的討論仍在如火如荼地進行。

8月初,在中國計算機學會(CCF)人工智能會議分論壇——“見疆見崑崙·AI大模型算力前沿”上,專家學者們一致表示,大模型時代,智能算力成為“稀缺資產” ,如何善用算力資源,發揮其最大效益,已經成為每個參與者必鬚麵對的挑戰。

而光是GPT-3對算力索取量,保守情況下,需三峽大壩徹夜“打工”才能滿足:

假設有1億人同時在線,每日有5%的人每秒同時提問,每個prompt佔30個token,便需要1530萬顆H100芯片來提供其推理算力;而每顆H100的功耗在750W左右,若每天運行10個小時,這些H100芯片所在的數據中心一年的耗電量將達到840億kW*h,而三峽大壩一年的發電量是882億kW*h。

讓AI芯片廠商更為焦慮的是,這還只是ChatGPT一個大模型在推理階段的耗電量,百家大模型全階段、全部運作的耗電量,難以估量。

於是,一系列新興的解決方案紛紛被廠商挖掘出來:存算一體、chiplet、HBM等等。在這之中,由於存算一體推翻了傳統馮諾依曼架構下的存儲牆,實實在在做到了降本增效,成為今年的“紫微星”。

(圖源:偲睿洞察《AI大算力芯片行業報告-百舸爭流,創新者先》)

除了新興方案湧現讓AI芯片廠商喘了一口氣之外,大模型也為芯片廠商尤其是初創芯片廠商,帶來一個利好消息:軟件生態重要性正在下降。

早先技術不夠成熟之時,研究者們只能從解決某個特定問題起步,參數量低於百萬的小模型由此誕生。例如穀歌旗下的AI公司DeepMind,讓AlphaGO對上百萬種人類專業選手的下棋步驟進行專項“學習”。

而小模型多了之後,硬件例如芯片的適配問題迫在眉睫。故,當英偉達推出統一生態CUDA之後,GPU+CUDA迅速博得計算機科學界認可,成為人工智能開發的標準配置。

現如今紛紛湧現的大模型具備多模態能力,能夠處理文本、圖片、編程等問題,也能夠覆蓋辦公、教育、醫療等多個垂直領域。這也就意味著,適應主流生態並非唯一的選擇:在大模型對芯片需求量暴漲之時,芯片廠商或許可以只適配1-2個大模型,便能完成以往多個小模型的訂單。

也就是說,ChatGPT的出現,為初創芯片廠商們提供了彎道超車的機會。這就意味著,AI芯片市場格局將發生巨變:不再是個別廠商的獨角戲,而是多個創新者的群戲。

當算力成為稀缺貨,同時適應主流生態不再成為必選項時,存算一體難掩光芒。此時,要不要投入,要投入多少,成為擺在AI芯片廠商面前的第二道難題。

對此,“過來人”芯片巨頭NVIDIA摸爬滾打多年給出的答案是,勇於創新,重金投入:

每一個新興技術的研發廠商,在前期無疑要面臨技術探索碰壁,下游廠商不認同等各個層面的問題。而在早期,誰先預判到未來的發展趨勢,並勇於邁出探索的腳步,鋪下合理的資源去嘗試,就會搶到先機。

當數據中心浪潮還未鋪天蓋地襲來、人工智能訓練還是小眾領域之時,英偉達已經投入重金,研發通用計算GPU和統一編程軟件CUDA,為英偉達謀一個好差事——計算平台。

而在當時,讓GPU可編程,是“無用且虧本”的:不知道其性能是否能夠翻倍,但產品研發會翻倍。為此,沒有客戶願意為此買單。但預判到單一功能圖形處理器不是長遠之計的英偉達毅然決定,在所有產品線上都應用CUDA。

在芯東西與英偉達中國區工程和解決方案高級總監賴俊傑博士的採訪中,賴俊傑表示:“為了計算平台這一願景,早期黃仁勳快速調動了英偉達上上下下非常多的資源。”

遠見+重金投入,在2012年,英偉達拿到了創新者的獎勵:2012年,深度學習算法的計算表現轟動學術圈,作為高算力且更為通用、易用的生產力工具,GPU+CUDA迅速風靡計算機科學界,成為人工智能開發的“標配”。

在AI大算力芯片的征途上,存算一體芯片迎來了自己的“黃金期”,超前投入,是為正解。

PART-02 非技術、資金雄厚者,勿進

窺見到存算一體的種種好處,現階段,存算一體芯片玩家陣營日益龐大。

(圖源:偲睿洞察《AI大算力芯片行業報告-百舸爭流,創新者先》)

據偲睿洞察不完全統計,自2019年起,新增的AI芯片廠商,多數在佈局存算一體:在2019-2021年新增的AI芯片廠商有20家,在這之中,有10家選擇存算一體路線。

這無一不說明著,存算一體將成為繼GPGPU、ASIC等架構後的,一顆冉冉升起的新星。而這顆新星,並不是誰都可以摘。

在學界、產界、資本一致看好存算一體的境況下,強勁的技術實力、紮實的人才儲備以及對遷移成本接受度的精準把控,是初創公司在業內保持競爭力的關鍵,也是擋在新玩家面前的三大門檻。

強勁的技術實力,永遠是芯片領域的最高山。

首先是存算一體“涉獵廣泛”,涉及到芯片製造的全環節:從最底層的器件,到電路設計,架構設計,工具鏈,再到軟件層的研發;其次是其“牽一發而動全身”:在每一層做相應改變的同時,還要考慮各層級之間的適配度。

我們一層一層來看,一顆存算一體芯片被造出來,有怎樣的技術難題。

首先,在器件選擇上,廠商就“如履薄冰”:存儲器設計決定芯片的良率,一旦方向錯誤將可能導致芯片無法量產。

其次是電路設計層面。電路層面有了器件之後,需要用其做存儲陣列的電路設計。而目前在電路設計上,存內計算沒有EDA工具指導,需要靠手動完成,無疑又大大增加了操作難度。

緊接著,架構層面有電路之後,需要做架構層的設計。每一個電路是一個基本的計算模塊,整個架構由不同模塊組成,存算一體模塊的設計決定了芯片的能效比。模擬電路會受到噪聲干擾,芯片受到噪聲影響後運轉起來會遇到很多問題。

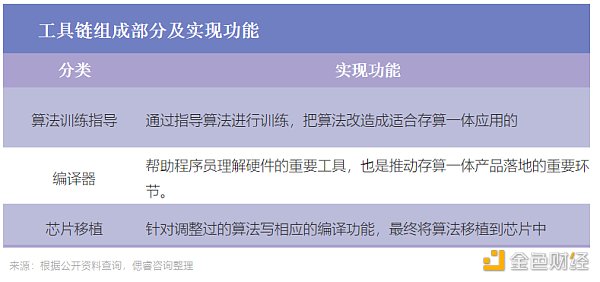

這種情況下,需要芯片架構師足夠了解模擬存內計算的工藝特點,同時針對這些特點去設計架構,在此基礎上,還要考慮到架構與軟件開發的適配度。軟件層面架構設計完成後,還需要開發相應的工具鏈。

(圖源:偲睿洞察《AI大算力芯片行業報告-百舸爭流,創新者先》)

而由於存算一體的原始模型與傳統架構下的模型不同,編譯器要適配完全不同的存算一體架構,確保所有計算單元能夠映射到硬件上,並且順利運行。

一條完整的技術鏈條下來,考驗著器件、電路設計、架構設計、工具鏈、軟件層開發各個環節的能力,與協調各個環節的適配能力,是耗時耗力耗錢的持久戰。

同時,根據以上環節操作流程可以看到,存算一體芯片亟需經驗豐富的電路設計師、芯片架構師。

鑑於存算一體的特殊性,能夠做成存算一體的公司在人員儲備上需要有以下兩點特徵:

1、帶頭人需有足夠魄力。在器件選擇(RRAM、SRAM等)、計算模式(傳統馮諾依曼、存算一體等)的選擇上要有清晰的思路。這是因為,存算一體作為一項顛覆、創新技術,無人引領,試錯成本極高。能夠實現商業化的企業,創始人往往具備豐富的產業界、大廠經驗和學術背景,能夠帶領團隊快速完成產品迭代。

2、在核心團隊中,需要在技術的各個層級中配備經驗豐富的人才。例如架構師,其是團隊的核心。架構師需要對底層硬件,軟件工具有深厚的理解和認知,能夠把構想中的存算架構通過技術實現出來,最終達成產品落地;

3、此外,據量子位報告顯示,國內缺乏電路設計的高端人才,尤其在混合電路領域。存內計算涉及大量的模擬電路設計,與強調團隊協作的數字電路設計相比,模擬電路設計需要對於工藝、設計、版圖、模型pdk以及封裝都極度熟悉的個人設計師。

而這一系列的人才與技術,都要以落地效果為終極目標——落地才是第一生產力。在交付時,客戶考量的並不僅僅是存算一體技術,而是相較於以往產品而言,存算一體整體SoC的能效比、面效比和易用性等性能指標是否有足夠的提升,更重要的是,遷移成本是否在承受範圍內。

如果選擇新的芯片提升算法表現力需要重新學習一套編程體系,在模型遷移上所花的人工成本高出購買一個新GPU的成本,那麼客戶大概率不會選擇使用新的芯片。

因此,存算一體在落地過程中是否能將遷移成本降到最低,是客戶在選擇產品時的關鍵因素。

在大模型背景下,存算一體芯片憑藉著低功耗但高能效比的特性,正成為芯片賽道,冉冉升起的一顆新星。現如今,存算一體市場風雲未定,仍處於“小荷才露尖尖角”階段。

但我們不可否認的是,存算一體玩家已然構築了三大高牆,非技術實力雄厚,人才儲備紮實者,勿進。