作者:Zeke,YBB Capital;翻譯:0xjs@金色財經

前言

2 月16 日,OpenAI 宣布推出名為「Sora」的最新文生視訊生成式擴散模型,憑藉其在各種視覺資料類型上生成高品質視訊的能力,標誌著生成式AI的另一個里程碑。與Pika 等從多個圖像生成幾秒鐘視訊的AI 視訊生成工具不同,Sora 在視訊和圖像的壓縮潛在空間中進行訓練,將它們分解為時空補丁,以生成可擴展的視訊。此外,該模型展示了模擬物理和數位世界的能力,其60 秒的演示被描述為「物理世界的通用模擬器」。

Sora延續了以往GPT模型中「源資料-Transformer-Diffusion-emergence」的技術路徑,顯示其發展成熟度也依賴算力。鑑於視訊訓練所需的數據量比文字更大,其對運算能力的需求預計將進一步增加。然而,正如我們之前的文章《潛力產業前瞻:去中心化算力市場》中所討論的那樣,算力在AI時代的重要性已經被探討,隨著AI的日益普及,眾多算力項目應運而生,惠及DePIN專案(儲存、運算能力等),它們的價值激增。除了DePIN之外,本文旨在更新和完善過去的討論,思考Web3和AI交織可能產生的火花以及AI時代這條賽道中的機會。

AI發展的三大方向

AI是一門旨在模擬、延伸和增強人類智慧的新興科學技術。自1950年代和1960年代誕生以來,AI已經發展了半個多世紀,現在已成為推動社會生活和各行業變革的關鍵技術。在這個過程中,符號主義、連結主義、行為主義三大研究方向的交織發展,為當今人工智慧的快速發展奠定了基礎。

符號主義

符號主義也稱為邏輯主義或基於規則的推理,認為透過符號的處理來模擬人類智慧是可行的。這種方法使用符號來表示和操縱問題域內的物件、概念及其關係,並採用邏輯推理來解決問題。符號主義取得了巨大的成功,特別是在專家系統和知識表示方面。符號主義的核心思想是智慧行為可以透過符號的操縱和邏輯推理來實現,其中符號代表了現實世界的高級抽象。

聯結主義

或稱為神經網路方法,旨在透過模仿人腦的結構和功能來實現智慧。該方法建立由許多簡單處理單元(類似於神經元)組成的網絡,並調整這些單元(類似於突觸)之間的連接強度以促進學習。連結主義強調從資料中學習和概括的能力,使其特別適合模式識別、分類和連續輸入輸出映射問題。深度學習作為聯結主義的演變,在圖像辨識、語音辨識、自然語言處理等領域取得了突破。

行為主義

行為主義與仿生機器人和自主智慧系統的研究密切相關,強調智能體可以透過與環境的互動來學習。與前兩者不同,行為主義並不注重模擬內在表徵或思考過程,而是透過知覺和行動的循環來實現適應性行為。行為主義認為,智慧是透過與環境的動態互動和學習來體現的,這使得它對於在複雜和不可預測的環境中運作的移動機器人和自適應控制系統特別有效。

這三個研究方向雖然存在根本差異,但在AI的實際研究和應用上可以相互作用、相互融合,共同推動人工智慧領域的發展。

AIGC的原則

AIGC的爆炸性發展領域代表了聯結主義的演變和應用,能夠透過模仿人類創造力來產生新穎的內容。這些模型使用大型資料集和深度學習演算法進行訓練,學習資料中的底層結構、關係和模式。根據使用者提示,它們產生獨特的輸出,包括圖像、影片、程式碼、音樂、設計、翻譯、問題答案和文字。目前,AIGC基本上由三個要素組成:深度學習、大數據和海量運算能力。

深度學習

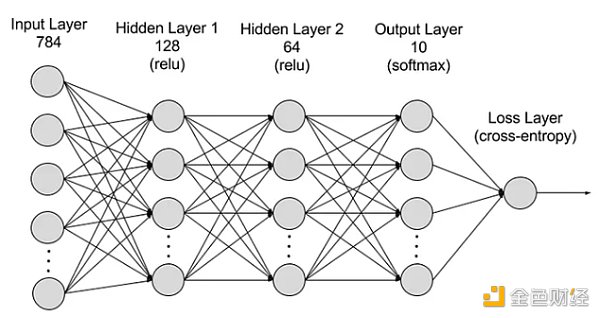

深度學習是機器學習的一個子領域,它採用模仿人腦神經網路的演算法。例如,人腦由數百萬個相互連接的神經元組成,它們一起工作來學習和處理資訊。同樣,深度學習神經網路(或人工神經網路)由在電腦內協同工作的多層人工神經元組成。這些人工神經元(稱為節點)使用數學計算來處理資料。人工神經網路利用這些節點透過深度學習演算法解決複雜問題。

神經網路分為層:輸入層、隱藏層和輸出層,參數連接不同層。

神經網路分為層:輸入層、隱藏層和輸出層,參數連接不同層。

輸入層:神經網路的第一層,負責接收外部輸入資料。輸入層中的每個神經元對應於輸入資料的一個特徵。例如,在處理影像資料時,每個神經元可能對應於影像的一個像素值。

隱藏層:輸入層處理資料並將其進一步傳遞到網路中。這些隱藏層在不同層級處理訊息,在接收新訊息時調整其行為。深度學習網路有數百個隱藏層,可以從多個角度分析問題。例如,當呈現需要分類的未知動物的圖像時,你可以透過檢查耳朵形狀、腿數量、瞳孔大小等將其與你已經知道的動物進行比較。深度神經網路中的隱藏層以類似的方式運作方式。如果深度學習演算法嘗試對動物影像進行分類,每個隱藏層都會處理動物的不同特徵並嘗試準確分類。

輸出層:神經網路的最後一層,負責產生網路的輸出。輸出層中的每個神經元代表一個可能的輸出類別或值。例如,在分類問題中,每個輸出層神經元可能對應一個類別,而在迴歸問題中,輸出層可能只有一個神經元,其值代表預測結果。

參數:在神經網路中,不同層之間的連接由權重和偏差表示,它們在訓練過程中進行最佳化,以使網路能夠準確識別資料中的模式並做出預測。增加參數可以增強神經網路的模型能力,即學習和表示資料中複雜模式的能力。然而,這也增加了對運算能力的需求。

大數據

為了進行有效的訓練,神經網路通常需要大量、多樣化、高品質和多來源的資料。它構成了訓練和驗證機器學習模型的基礎。透過分析大數據,機器學習模型可以學習數據中的模式和關係,從而實現預測或分類。

海量運算能力

神經網路多層結構複雜,參數眾多,大數據處理要求,迭代訓練方式(訓練時模型需要反覆迭代,涉及到每一層的前向和後向傳播計算,包括激活函數計算、損失函數計算、梯度計算和權重更新)、高精度運算需求、平行運算能力、最佳化和正則化技術以及模型評估和驗證過程共同導致了高運算能力的需求。

Sora

作為OpenAI 最新的影片生成AI 模型,Sora 代表了人工智慧處理和理解多樣化視覺數據的能力的重大進步。透過採用視訊壓縮網路和時空修補技術,Sora 可以將全球範圍內不同裝置擷取的大量視覺資料轉換為統一的表示形式,從而實現對複雜視覺內容的高效處理和理解。利用文字條件擴散模型,Sora 可以產生與文字提示高度匹配的影片或圖像,展現出高度的創造力和適應性。

然而,儘管Sora在視訊生成和模擬現實世界互動方面取得了突破,但它仍然面臨一些局限性,包括物理世界模擬的準確性、生成長視頻的一致性、理解複雜的文本指令以及訓練和生成的效率。本質上,Sora透過OpenAI的壟斷算力和先發優勢,延續了「大數據-Transformer-Diffusion-emergence」的老技術路徑,實現了一種蠻力美學。其他人工智慧公司仍然有透過技術創新實現超越的潛力。

雖然Sora與區塊鏈的關係並不大,但相信未來一兩年,由於Sora的影響力,其他優質的AI生成工具將會出現並迅速發展,衝擊各個Web3領域如GameFi、社交平台、創意平台、Depin等。因此,對Sora有一個大致的了解是必要的,未來AI如何與Web3有效結合是一個重點考慮的問題。

AI x Web3融合的四種途徑

如同前面所討論的,我們可以理解生成式AI所需的基本要素本質上有三重:演算法、資料和運算能力。另一方面,考慮到其普遍性和產出效果,AI是一種徹底改變生產方式的工具。同時,區塊鏈最大的影響是雙重的:重組生產關係和去中心化。

因此,我認為這兩種技術的碰撞可以產生以下四種路徑:

去中心化算力

如前所述,本節旨在更新運算能力格局的狀態。談到AI,運算能力是不可或缺的一個面向。 Sora的出現,讓原本難以想像的AI對算力的需求凸顯出來。近日,在2024年瑞士達沃斯世界經濟論壇期間,OpenAI執行長Sam Altman公開表示,算力和能源是目前最大的限制因素,暗示它們未來的重要性甚至可能等同於貨幣。隨後,2月10日,Sam Altman在推特上宣布了一項令人震驚的計劃,將籌集7萬億美元(相當於2023年中國GDP的40%)來徹底改革當前的全球半導體產業,旨在打造一個半導體帝國。我之前對算力的思考僅限於國家封鎖和企業壟斷;一家公司想要主宰全球半導體產業的想法確實很瘋狂。

因此,去中心化運算能力的重要性是不言而喻的。區塊鏈的特性確實可以解決當前運算能力極度壟斷的問題,以及與取得專用GPU 相關的昂貴成本的問題。從AI需求的角度來看,算力的運用可以分為推理和訓練兩個方向。專注於訓練的項目還很少,因為去中心化網路需要整合神經網路設計,對硬體要求極高,是一個門檻較高、實施難度較大的方向。相較之下,推理相對簡單,因為去中心化網路設計沒有那麼複雜,對硬體和頻寬的要求也較低,是更主流的方向。

中心化算力市場想像空間廣闊,常與「萬億級」關鍵字連結在一起,也是AI時代最容易炒作的話題。然而,縱觀最近出現的眾多項目,大多數似乎都是利用趨勢的考慮不周的嘗試。他們經常高舉去中心化的旗幟,但卻避免討論去中心化網路的低效率。另外,設計同質化程度很高,很多專案非常相似(一鍵L2加挖礦設計),最終可能會導致失敗,很難在傳統AI競賽中佔有一席之地。

演算法與模型協同系統

機器學習演算法是那些可以從資料中學習模式和規則,並根據它們做出預測或決策的演算法。演算法是技術密集的,因為其設計和優化需要深厚的專業知識和技術創新。演算法是訓練人工智慧模型的核心,定義如何將資料轉化為有用的見解或決策。常見的生成式AI 演算法包括生成對抗網路(GAN)、變分自編碼器(VAE) 和Transformers,每種演算法都是針對特定領域(例如繪畫、語言辨識、翻譯、視訊生成)或目的而設計的,然後用於訓練專門的AI模型。

那麼,這麼多的演算法和模型,各有千秋,是否有可能將它們整合成一個通用的模型呢? Bittensor是最近備受關注的項目,它透過激勵不同的AI模型和演算法相互協作和學習,從而創建更有效率、更有能力的AI模型,從而引領了這個方向。其他專注於這個方向的專案包括Commune AI(程式碼協作),但演算法和模型對於AI公司來說是嚴格保密的,不容易分享。

因此,AI協作生態系統的敘述新穎而有趣。協作生態系統利用區塊鏈的優勢來整合孤立的AI演算法的劣勢,但是否能夠創造相應的價值還有待觀察。畢竟,擁有自主演算法和模型的領先AI公司,擁有強大的更新、迭代和整合能力。例如,OpenAI 在不到兩年的時間內從早期的文本生成模型發展到多領域生成模型。像Bittensor 這樣的計畫可能需要在其模型和演算法目標領域中探索新路徑。

去中心化大數據

從簡單的角度來看,利用隱私資料來餵食AI和註釋資料是與區塊鏈技術非常吻合的方向,主要考慮的是如何防止垃圾資料和惡意行為。此外,資料儲存可以使FIL 和AR 等DePIN專案受益。從更複雜的角度來看,使用區塊鏈資料進行機器學習來解決區塊鏈資料的可訪問性是另一個有趣的方向(Giza 的探索之一)。

理論上,區塊鏈數據是隨時可存取的,反映了整個區塊鏈的狀態。然而,對於區塊鏈生態系統之外的人來說,存取這些大量數據並不簡單。儲存整個區塊鏈需要豐富的專業知識和大量的專業硬體資源。為了克服存取區塊鏈數據的挑戰,行業內出現了多種解決方案。例如,RPC 提供者透過API 提供節點訪問,索引服務使透過SQL 和GraphQL 進行資料檢索成為可能,在解決該問題方面發揮了至關重要的作用。然而,這些方法都有其限制。 RPC服務不適合需要大量資料查詢的高密度用例,往往無法滿足需求。同時,儘管索引服務提供了一種更結構化的資料檢索方式,但Web3 協定的複雜性使得建構高效查詢變得極其困難,有時需要數百甚至數千行複雜程式碼。這種複雜性對於一般資料從業者和對Web3 細節了解有限的人來說是一個重大障礙。這些限制的累積效應凸顯了需要一種更易於存取和利用的方法來獲取和利用區塊鏈數據,這可以促進該領域更廣泛的應用和創新。

因此,將ZKML(零知識證明機器學習,減輕鏈上機器學習的負擔)與高品質的區塊鏈資料結合,可能會創建解決區塊鏈資料可訪問性的資料集。 AI可以顯著降低區塊鏈資料的存取障礙。隨著時間的推移,開發人員、研究人員和機器學習愛好者可以存取更多高品質、相關的資料集,以建立有效和創新的解決方案。

AI賦能Dapp

自2023年ChatGPT3爆發以來,AI對Dapp的賦能已成為一個非常普遍的方向。廣泛適用的生成式人工智慧可以透過API集成,從而簡化和智慧化資料平台、交易機器人、區塊鏈百科全書和其他應用程式。另一方面,它還可以充當聊天機器人(如Myshell)或AI 伴侶(Sleepless AI),甚至可以使用生成式AI 在區塊鏈遊戲中創建NPC。但由於技術門檻較低,大多數只是整合API後的調整,與專案本身的整合並不完善,因此很少被提及。

但隨著Sora的到來,我個人認為AI對GameFi(包括元宇宙)和創意平台的賦能將是未來的重點。鑑於Web3領域自下而上的性質,它不太可能生產出可以與傳統遊戲或創意公司競爭的產品。然而,Sora的出現可能會打破這一僵局(也許只需兩到三年)。從Sora的演示來看,它有與短劇公司競爭的潛力。 Web3活躍的社區文化還可以催生出大量有趣的想法,當唯一的限制就是想像力時,自下而上的行業與自上而下的傳統行業之間的壁壘將被打破。

結論

隨著生成式人工智慧工具的不斷發展,未來我們將見證更多突破性的「iPhone時刻」。儘管人們對AI與Web3的整合持懷疑態度,但我相信目前的方向基本上是正確的,只需要解決三個主要痛點:必要性、效率和契合度。雖然這兩者的融合還處於探索階段,但並不妨礙這條路徑成為下一次多頭市場的主流。

對新事物保持足夠的好奇心和開放的態度是我們的基本心態。從歷史上看,從馬車到汽車的轉變是瞬間解決的,正如銘文和過去的NFT 所顯示的那樣。持有太多偏見只會導致錯失機會。