io.net是IO Research開發的基於Solana的去中心化AI算力平台,在其最新一輪融資中達到了10億美元的FDV 估值。

io.net 在今年3月宣佈在Hack VC的領投下完成了3000萬美元的A輪融資,其中還包括Multicoin Capital、6th Man Ventures、Solana Ventures、OKX Ventures、Aptos Labs、Delphi Digital、The Sandbox和The Sandbox的Sebastian Borget等參與。

io.net 專注於為AI和機器學習公司聚合GPU資源,致力於以更低的成本和更快的交付時間提供服務。自去年11月啟動以來,io.net已成長到超過25,000個GPU,並為人工智慧和機器學習公司處理了超過40,000個運算小時。

io.net 的願景是建構一個全球化的去中心AI運算網絡,為AI與機器學習團隊/企業與世界各地的強大GPU資源之間建立生態系統。

在這個生態系中,AI運算資源變得商品化,供需雙方不再會因為沒有資源而困擾。未來io.net 也將提供存取IO模型商店和進階推理功能,如無伺服器推理、雲端遊戲和像素流等服務。

業務背景

在介紹io.net 的業務邏輯之前,我們先從兩個維度了解去中心化算力這條賽道:一個是AI計算的發展歷程,另一緯度是了解過去同樣使用去中心化算力的案例。

AI運算的發展歷程

我們可以從幾個關鍵時間點來描繪這AI計算的發展軌跡:

一、機器學習的早期(1980s – 早期2000s)

在這段時期,機器學習方法主要集中在較為簡單的模型,如決策樹、支援向量機(SVM)等。這些模型的計算需求相對較低,可以在當時的個人電腦或小型伺服器上運行。資料集相對較小,特徵工程和模型選擇是關鍵任務。

時間點:1980年代至2000年代初

算力要求:相對較低,個人電腦或小型伺服器即可滿足需求。

運算硬體:CPU主導運算資源。

二、深度學習的崛起(2006年-近期)

2006年,深度學習的概念被重新引入,這段時期以Hinton等人的研究為標誌。隨後,深度神經網絡,特別是卷積神經網路(CNN)和循環神經網路(RNN)的成功應用,標誌著這一領域的突破。這一階段對運算資源的需求顯著增加,尤其是在處理影像和語音等大數據集時。

時間點:

ImageNet大賽(2012):AlexNet在這場比賽中的勝利是深度學習歷史上的標誌性事件,它首次展示了深度學習在影像辨識領域的巨大潛力。

AlphaGo(2016):Google DeepMind的AlphaGo擊敗世界圍棋冠軍李世石這應該是AI 目前為止最為高光的時刻,這不僅展示了深度學習在複雜策略遊戲中的應用,也向世界證明了其在解決高度複雜問題方面的能力。

算力需求:顯著增加,需要更強大的運算資源來訓練複雜的深度神經網路。

運算硬體:GPU開始成為深度學習訓練的關鍵硬件,因為它們在平行處理方面遠勝於CPU。

三、大型語言模式的時代(2018至今)

隨著BERT(2018年)和GPT技術(2018年後)的出現,大模型開始主導AI賽道。這些模型通常具有數十億至數萬億的參數,對運算資源的需求達到了前所未有的水平。訓練這些模型需要大量的GPU或是更專業的TPU,並且需要大量的電力和冷卻設施支援。

時間點:2018年至今。

算力需求:極高,需要大量的GPU或TPU形成規模並輔以相應的基礎設施支援。

運算硬體:除了GPU和TPU,還有大型機器學習模型最佳化的專用硬體開始出現,如穀歌的TPU,Nvidia 的A、H系列等。

從過去30年AI對算力需求的指數級增長來看,早期機器學習對算力的需求較低,深度學習時代增加了對算力的需求,而AI大型模型進一步將這一需求推向極致。我們見證了計算硬體從數量到效能的顯著提升。

這種成長不僅反映在傳統資料中心的規模擴大和GPU等硬體效能的提高上,更體現在高昂的投入門檻以及豐厚的回報預期,足以讓網路巨頭間的廝殺公開化。

傳統的中心化GPU 算力中心,初期投資需要昂貴的硬體採購(如GPU本身)、資料中心的建置或租賃費用、冷卻系統、以及維修人員的成本。

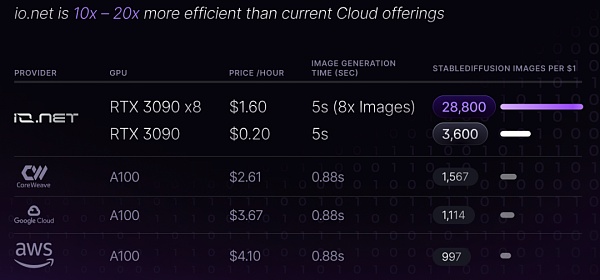

相較之下, io.net 所建立的去中心化運算平台專案在搭建成本方面具有明顯的優勢,能顯著降低初期投資和營運成本,可以為小微團隊建立自己的AI模型創造了可能。

去中心化GPU專案利用已存在的分散式資源,不需要集中投資於硬體和基礎設施建設。個人和企業可以將閒置的GPU資源貢獻到網路中,減少了集中採購和部署高效能運算資源的需求。

其次,在營運成本方面,傳統的GPU集群需要持續的維護、電力和冷卻費用。而去中心化GPU專案透過利用分散式的資源,可以將這些成本分攤給各個節點,從而降低單一組織的營運負擔。

根據io.net的文檔,io.net透過聚合來自獨立資料中心、加密貨幣礦工以及Filecoin、Render等其他硬體網路中未充分利用的GPU資源極大地降低了營運成本。再加上Web3的經濟誘因策略,使得io.net 在定價上擁有極大優勢。

去中心化計算

回顧歷史,過去確實有一些去中心化計算項目取得了顯著的成功,在沒有經濟激勵的情況下,依舊吸引了大量參與者並產生了重要成果。比如:

Folding@home:這是一個由史丹佛大學發起的項目,旨在透過分散式運算來模擬蛋白質折疊過程,幫助科學家了解疾病機理,尤其是與蛋白質折疊不當相關的疾病如阿茲海默症、亨廷頓氏症等。在COVID-19疫情期間,Folding@home計畫聚集了大量的運算資源,以協助研究新冠病毒。

BOINC (Berkeley Open Infrastructure for Network Computing)**:這是一個開源軟體平台,支援各種類型的志工和網格運算項目,包括天文學、醫學、氣候科學等多個領域。使用者可以貢獻閒置的運算資源,參與各種科學研究專案。

這些項目不僅證明了去中心化計算的可行性,也展現了去中心化計算的巨大發展潛力。

透過動員社會各界貢獻未利用的運算資源,能顯著增強運算能力,若再創新地加入Web3的經濟模型,還能在經濟上實現更大的成本效益。 Web3 經驗表明,一個合理的激勵機制對於吸引和維持使用者的參與。

透過引入激勵模型可以建構一個互助共贏的社區環境,可以進一步促進業務規模擴大,正向循環推進技術進步。

因此,io.net能夠透過激勵機制的引入,吸引廣泛的參與者,共同貢獻算力,形成一個強大的去中心化計算網絡。

Web3的經濟模型與去中心化算力潛力為io.net提供了強大成長動力,並實現高效的資源利用和成本優化。這不僅促進了技術創新,也為參與者提供了價值,可以讓io.net 在AI領域的競爭中脫穎而出,擁有巨大的發展潛力和市場空間。

io.net 技術

叢集

GPU 集群是指複雜的運算透過網路將多個GPU連接起來,形成一個協作的運算集群,這種方法大幅提升了處理複雜AI任務的效率和能力。

叢集運算不僅加快了AI模型的訓練速度,也增強了處理大規模資料集的能力,使得AI應用更加靈活且可擴展。

在傳統網路訓練AI模型的過程中,都需要用大規模的GPU 叢集。然而,當我們考慮將這種叢集運算模式轉向去中心化時,一系列技術挑戰隨之浮現。

相較於與傳統的網路公司的AI運算叢集,去中心化的GPU叢集運算,會面對更多問題,例如:節點可能遍布不同地理位置,這帶來了網路延遲和頻寬限制問題,可能影響到資料在節點間的同步速度,進而影響整體的運算效率。

此外,如何保持資料在各個節點間的一致性和即時同步,也對於確保計算結果的準確性至關重要。因此這就需要去中心化運算平台開發出高效率的資料管理和同步機制。

而如何管理和調度分散的運算資源,確保運算任務能有效完成,也是去中心化叢集運算需要解決的問題。

io.net透過整合Ray 和Kubernetes ,建構了一個去中心化的叢集運算平台。

Ray作為一個分散式運算框架,直接負責在多個節點上執行運算任務,它優化了資料處理和機器學習模型的訓練過程,確保了任務在各個節點上有效運作。

而Kubernetes則在這過程中扮演關鍵的管理角色,它自動化了容器應用的部署和管理,確保了運算資源根據需求動態地分配和調整。

在這個體系中,Ray 和Kubernetes 的結合實作了一個動態且有彈性的運算環境。 Ray 確保運算任務能夠在適當的節點上有效執行,而Kubernetes 保證了整個系統的穩定性和可擴展性,自動處理節點的增加或移除。

這種協同作用使得io.net 能夠在去中心化的環境中提供連貫且可靠的運算服務,無論是在資料處理或模型訓練方面,都能夠滿足使用者的多樣化需求。

透過這種方式,io.net不僅優化了資源的使用,降低了運作成本,還提高了系統的靈活性和使用者的控制。使用者可以方便地部署和管理各種規模的運算任務,而無需擔心底層資源的具體配置和管理細節。

這種去中心化的運算模式,借助Ray和Kubernetes的強大功能,確保了io.net平台在處理複雜和大規模運算任務時的高效性和可靠性。

隱私

由於去中心化的集群的任務調配邏輯的使用場景遠比機房中的集群邏輯要複雜得多,又鑑於數據和計算任務在網路中的傳輸增加了潛在的安全風險,去中心化的集群還要考慮安全性和隱私保護。

io.net 透過利用網狀( mesh)私有網路通道的去中心化特性,提升了網路的安全性和隱私性。在這樣的網路中,由於沒有中心集中點或網關,網路面臨的單點故障風險大幅降低,即使部分節點遇到問題,整個網路仍能保持運作。

資料在網狀網路內沿著多條路徑傳輸,這種設計增加了追蹤資料來源或目的地的難度,從而加強了使用者的匿名性。

此外,透過採用諸如資料包填充和時間混淆等技術(Traffic Obfuscation),網狀VPN網路能進一步模糊資料流的模式,使得竊聽者難以分析流量模式或識別特定使用者或資料流。

io.net的隱私機制之所以能有效解決隱私問題,是因為它們共同建構了一個複雜且多變的資料傳輸環境,使得外部觀察者難以捕捉有用的資訊。

同時,去中心化結構避免了所有資料流經單一一點的風險,這種設計不僅提高了系統的穩健性,也降低了被攻擊的可能性。同時,資料的多路徑傳輸和流量的混淆策略共同為使用者的資料傳輸提供了一層額外的保護,增強了io.net 網路的整體隱私性。

經濟模型

IO 是io.net 網路的原生加密貨幣和協議通證,可以滿足生態系統內兩大主體的需求:AI新創公司和開發者,以及算力提供者。

對於AI新創公司和開發者而言,IO簡化了叢集部署的支付流程,更加方便;他們還可以使用與美元掛鉤的IOSD Credits來支付網路上運算任務的交易費用。每個在io.net上部署的模型都需要透過微小的IO幣交易來推斷。

對於供應商來講,特別是GPU資源的提供者,IO幣保證了他們的資源得到公平的回報。不論是GPU被租用時的直接收益,還是在空閒時參與網路模型推斷的被動收益,IO幣都為GPU的每項貢獻提供了獎勵。

在io.net生態系統中,IO幣不僅是支付和激勵的媒介,也是治理的關鍵。它讓模型開發、訓練、部署和應用開發的每個環節都更加透明、高效,並確保了參與者之間的互利共贏。

透過這種方式,IO幣不僅激勵了生態系統內的參與和貢獻,也為AI新創公司和工程師提供了一個全面的支援平台,推動了AI技術的發展和應用。

io.net 在激勵模型上下足了功夫,確保整個生態系統可以正向循環。 io.net的目標是為網路中每張GPU卡建立一個以美元表示的直接小時費率。這需要提供一個清晰、公平且去中心化的GPU/CPU資源定價機制。

作為一個雙邊市場,激勵模型的核心關鍵是旨在解決兩大挑戰:一方面降低租用GPU/CPU運算能力的高昂成本,這對於擴大AI和ML算力需求關鍵指標;另一方面解決在GPU雲服務提供者中租用GPU節點的短缺問題。

因此在設計原則上,需求方面的考量包括競爭對手的定價和可用性,以在市場上提供有競爭力和吸引力的選擇,並在高峰時段和資源緊張時調整定價。

算力供應方面,io.net 著眼於兩個關鍵市場:遊戲玩家和加密GPU礦工。遊戲玩家擁有高階硬體和快速的網路連接,但通常只擁有一張GPU卡;而加密GPU礦工擁有大量的GPU資源,儘管可能面臨網路連線速度和儲存空間的限制。

因此,算力定價模型包括多維度因素,如硬體效能、網路頻寬、競爭對手定價、供應可用性、高峰時段調整、承諾定價和地點差異。此外,還需要考慮硬體進行其他工作證明加密挖礦時的最佳利潤。

未來,io.net 會進一步給出一套完全去中心化定價的方案以及為礦工硬體創建一個類似speedtest.net的基準測試工具,打造一個完全去中心化、公平、透明的市場。

參與方式

io.net 推出了Ignition 活動,這是io.net社群激勵計畫的第一階段,目的是加速IO網路的成長。

計劃總共設有三個獎勵池,它們之間完全獨立。

-

Worker 獎勵(GPU)

-

銀河任務獎勵

-

Discord角色獎勵(Airdrop Tier Role)

這三個獎勵池之間是完全獨立的,參與者可以從這三個獎勵池中分別獲得獎勵,並且不需要將相同的錢包與每個獎勵池關聯起來。

GPU節點獎勵

對於已經接入的節點,空投積分根據是從2023年11月4日- 2024年4月25日活動結束時計算。 Ignition活動結束時,用戶所賺取的空投積分都會轉換為空投獎勵。

空投積分會考慮四方面:

A. 被雇用的時間(Ratio of Job Hours Done – RJD)從2023年11月4日開始到活動結束被雇用的總時長。

B. 頻寬(Bandwidth – BW)根據頻寬速度範圍對節點的頻寬進行等級分類:

低速:下載速度100MB/每秒,上傳速度75MB/每秒。

中速:下載速度400MB/每秒,上傳速度300MB/每秒。

高速:下載速度800MB/每秒。

C. GPU 型號(GPU Model – GM)將會根據GPU型號決定,效能越高的GPU積分越多。

D. 成功運行的時間(Uptime – UT)從2023年11月4日接入Worker開始到活動結束的總共成功運行的時長。

值得注意的是空投積分預計在2024年4月1日左右可供用戶查看。

銀河任務獎勵(Galxe)

銀河任務連接網址https://galxe.com/io.net/campaign/GCD5ot4oXPAt

Discord 角色獎勵

該獎勵將由io.net 的社群管理團隊監督進行,並要求用戶在Discord中提交正確的Solana錢包地址。

將會根據使用者的貢獻度,活躍度,內容創作等參與其他活動來獲取對應的Airdrop Tier Role等級。

總結

總的來說,io.net和類似的去中心化AI運算平台正在開啟AI運算新的篇章,雖然也面臨技術實現的複雜性、網路的穩定性和資料安全性的挑戰。但io.net 有潛力徹底改變AI商業模式。相信隨著這些技術的成熟和算力社群的擴大,去中心化AI算力可能成為推動AI創新和普及的關鍵力量。