作者:陳默來源:cmdefi

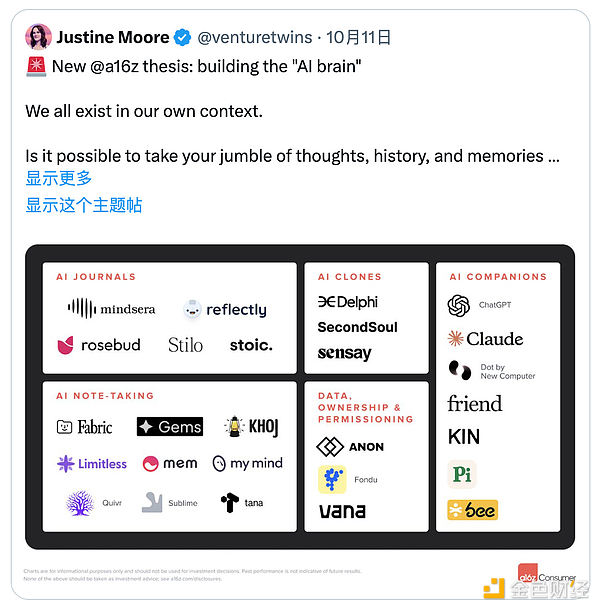

“AI大腦” 時代

Justine Moore 花了6個月的時間做一項實驗,每天與ChatGPT交流,不斷分享個人想法和情感,試圖創建一個真正理解自己的“AI大腦”,結果AI的能力完全超出預期,她列舉了以下幾個場景:

1. 與他人溝通:透過使用大語言模型(LLM),可以幫助我們更清楚地傳達複雜的想法,大幅提升溝通能力。

這一點本身我自己也在用,目前我用到的AI最強能力,我覺得就是總結和溝通能力,如果你的總結能力比較欠缺,特別是對於在需要把一件事情或是一個項目給別人講清楚的情況下,利用AI學習總結和溝通能力真的太強了。

2. 自我理解:AI大腦能夠很好地「心理分析」你,幫助你更清楚地認識自己的優勢和弱點,並糾正認知偏見。

3. 與應用程式互動:AI大腦可以被帶入其他應用,解鎖真正個人化的體驗,例如一個完全理解你風格的寫作助手,或為你量身定制的工作或社交工具。

實際上如果你是個重度AI使用者,可能已經有過類似的體驗,至少我覺得未來每個人都會有一個適配自己的AI大腦。

那麼,建構一個屬於自己的AI大腦,關鍵因素是什麼?

1. 用戶資料的完整性與品質

要讓AI大腦真正理解你,首先需要大量且高品質的個人資料。這包括你的歷史對話、行為記錄、情感傾向、偏好和決策等。數據越豐富越完整,AI大腦越能完美捕捉你的思考模式和個性。

2. 資料的隱私與安全性

個人資料的隱私保護至關重要,因為它已經學習了你大量的生活習性、性格喜好,甚至弱點缺陷。在建構「AI大腦」時,使用者需要對資料有完全的控制權,確保這些資料不會被濫用或洩漏。畢竟,你的AI大腦最好不要讓別人入侵。

3. 透明的模型訓練與資料使用機制

一個真正理解自己的AI大腦,透明度是關鍵。使用者應該知道他們的資料如何被使用、AI模型如何訓練,這也可以被理解是安全性的一種。

解決方案:去中心化的架構與資料所有權?

在Justine的理念中,也基於以上3條,AI大腦應該完全掌握在使用者手中,避免大科技公司對數據的壟斷與利用。

所以,去中心化的架構可能成為一條通道,它可以透過讓使用者成為資料和AI模型的實際所有者,確保使用者在資料和AI模型的整個生命週期中都保持對其貢獻的控制和利害關係人。

Vana DataDAO方案

這項方案的核心理念是-賦予使用者對資料的完全主權,這基本上與「AI大腦」的理念完全契合。

Vana引入「非託管資料」的概念,確保資料僅用於使用者授權的操作。用戶始終擁有對自己資料的控制權,不會被平台或第三方託管。

實作方式就是,資料在貢獻給伺服器之前會進行加密處理。每個用戶將自己的資料透過伺服器的公鑰進行加密,確保即使資料傳輸到集體伺服器或用於AI訓練時,資料本身仍然是保密的,只有擁有解密金鑰的參與者才能解密和存取數據。

這一點不僅解決了用戶的數據主權和隱私性,也為數據品質奠定了基礎,這也很重要,因為保證了隱私性,用戶才能沒有顧慮的提供真實數據,配合Vana區塊鏈的貢獻證明( Proof-of-Contribution)機制,加入了Crypto已經深入骨髓的代幣激勵模型,能夠讓用戶更有動力提供高品質數據。

綜合來說,Vana DataDAO 主要解決的就是資料主權問題,當然包括資料隱私和安全。事實上想訓練一個AI助理並不難,很多訓練語言模型的API都能夠提供這種環境,但未來我們的需求是否只會滿足於一個「助手」? AI 就像一個潘朵拉魔盒,打開之後釋放出的魔力之強大可能越來越讓人難以拒絕,如果人類的需求上升到AI大腦、AI超級大腦的級別,關於數據主權的問題就不可避免。