作者|Frank Fu @IOSG

MCP 正在迅速佔據Web3 AI Agent 生態的核心地位,它通過類似插件的架構,引入MCP Server,賦予AI Agent 新的工具和能力。

與Web3 AI 領域其他新興敘事(如vibe coding)類似,MCP,全稱為Model Context Protocol,起源於Web2 AI,現在正在Web3 語境下被重新構想。

什麼是MCP?

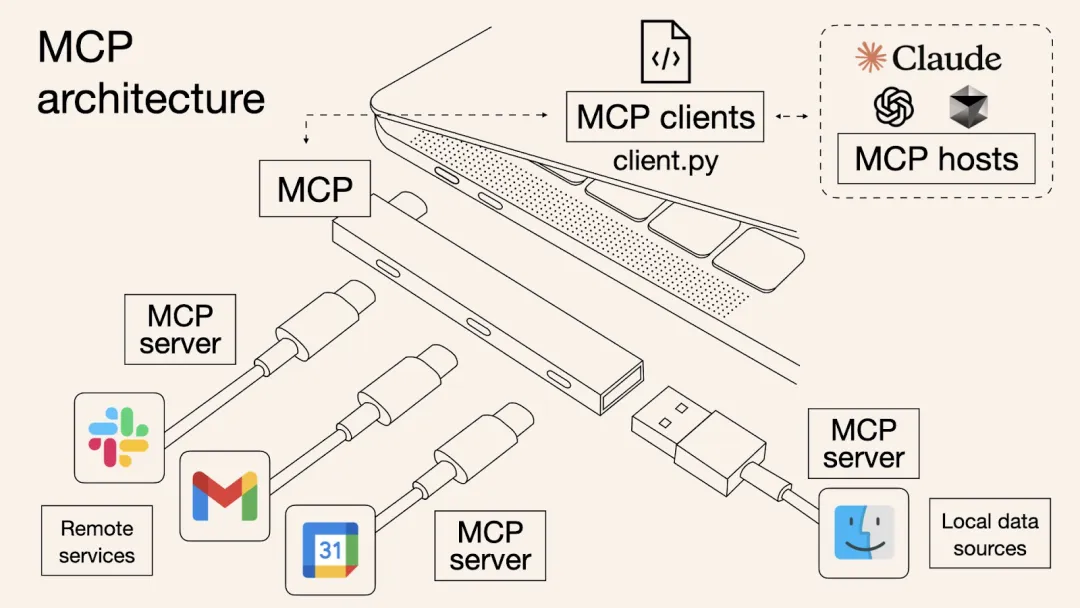

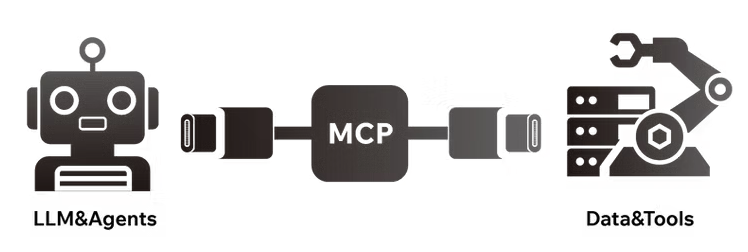

MCP 是由Anthropic 提出的一個開放協議,用於標準化應用程序如何向大語言模型(LLMs)傳遞上下文信息。這使得工具、數據與AI Agent 之間能夠更無縫地協作。

為什麼它很重要?

當前大語言模型面臨的核心限制包括:

無法實時瀏覽互聯網

無法直接訪問本地或私人的文件

無法自主與外部軟件交互

MCP 通過充當通用接口層,彌補了上述能力空缺,使AI Agent 能夠使用各種工具。

你可以將MCP 類比為AI 應用領域的USB-C —— 統一接口標準,讓AI 更容易對接各種數據源和功能模塊。

設想每個LLM 是不同的手機—— Claude 用的是USB-A,ChatGPT 用USB-C,而Gemini 是Lightning 接口。如果你是硬件廠商,就得為每種接口都開發一套配件,維護成本極高。

這正是AI 工具開發者所面臨的問題:為每一個LLM 平台定制插件,極大增加了複雜性並限制了規模化擴展。 MCP 就是為了解決這一問題,通過建立統一的標準,就像讓所有LLM 和工具商都使用USB-C 接口。

這種標準化協議對雙方都有利:

對AI Agent(客戶端):可以安全地接入外部工具與實時數據源

對工具開發者(服務端):一次接入,跨平台可用

最終結果是一個更開放、可互操作、低摩擦的AI 生態系統。

MCP 與傳統API 有什麼不同?

API 的設計是為人類服務的,並非AI-first。每個API 都有各自的結構和文檔,開發者必須手動指定參數、閱讀接口文檔。而AI Agent 本身無法閱讀文檔,必須被硬編碼以適配每種API(如REST、GraphQL、RPC 等)。

MCP 通過標準化API 內部的函數調用格式,抽象掉這些非結構化的部分,為Agent 提供統一的調用方式。你可以把MCP 看作是為Autonomous Agent 封裝的API 適配層。

當2024 年11 月Anthropic 首次推出MCP 時,開發者需在本地設備上部署MCP 服務器。而今年5 月,Cloudflare 在其開發者周宣布,開發者可在Cloudflare Workers 平台上以最低設備配置直接部署遠程MCP 服務器。這大大簡化了MCP 服務器的部署和管理流程,包括認證和數據傳輸,堪稱「一鍵部署」。

儘管MCP 本身還是看似不夠「吸引人」,但是它絕非無足輕重。作為純粹的基礎設施組件,MCP 無法直接面向消費者使用,只有當上層的AI 代理調用MCP 工具並展現實際效果時,其價值才會真正顯現。

Web3 AI x MCP 生態圖景Landscape

Web3 中的AI 同樣面臨「缺乏上下文數據」和「數據孤島」的問題,也就是說,AI 無法訪問鏈上實時數據或原生執行智能合約邏輯。

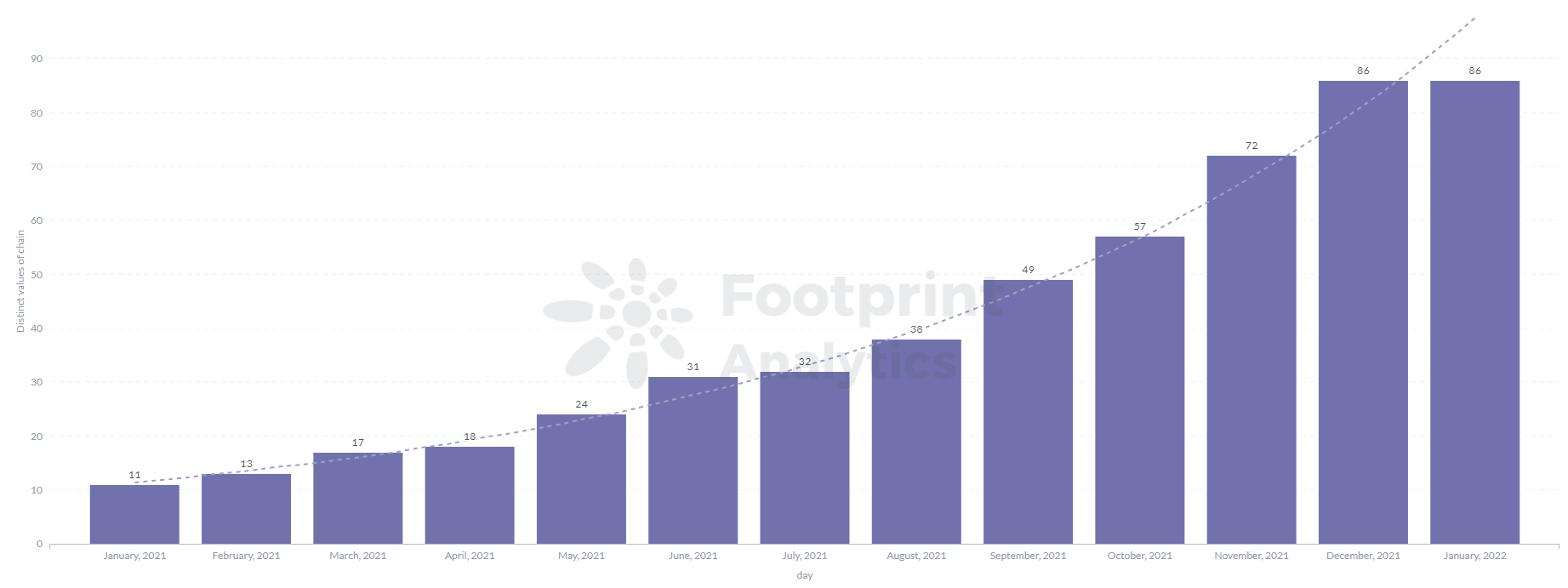

過去,ai16Z、ARC、Swarms、Myshell 等項目試圖構建多Agent 協同網絡,但最終由於依賴中心化API 和定制集成,陷入了「重複造輪子」的困境。

每對接一個數據源都要重寫適配層,導致開發成本激增。為了解決這一瓶頸,下一代AI Agent 需要一種更模塊化、樂高式的架構,以便於無縫集成第三方插件和工具。

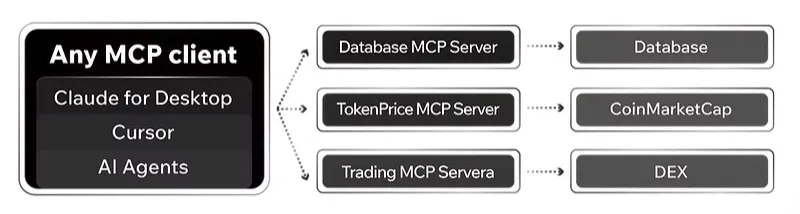

於是,基於MCP 和A2A 協議的新一代AI Agent 基礎設施和應用正在興起,專為Web3 場景設計,讓Agent 能夠訪問多鏈數據,並原生交互DeFi 協議。

▲ 來源:IOSG Ventures

(此圖並不完全覆蓋所有MCP 相關Web3 項目)

項目案例:DeMCP 與DeepCore

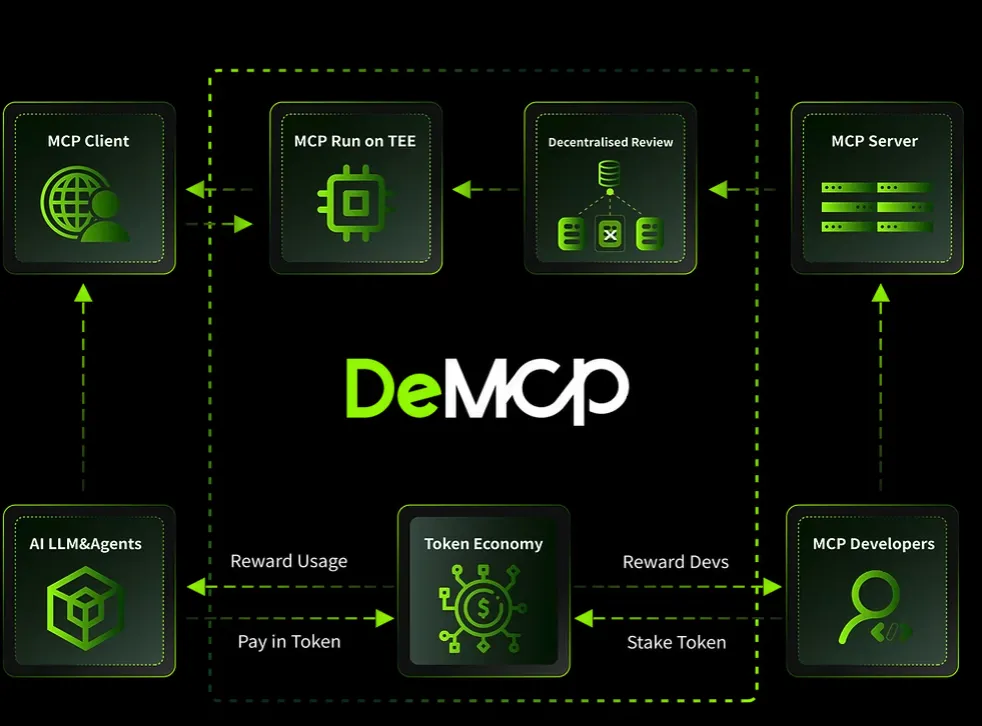

DeMCP 是一個去中心化MCP Server 的市集(https://github.com/modelcontextprotocol/servers) ,專注於原生加密工具與確保MCP 工具的主權。

其優勢包括:

使用TEE(可信執行環境)來確保MCP 工具未被篡改

使用代幣激勵機制,鼓勵開發者貢獻MCP服務器

提供MCP 聚合器與微支付功能,降低使用門檻

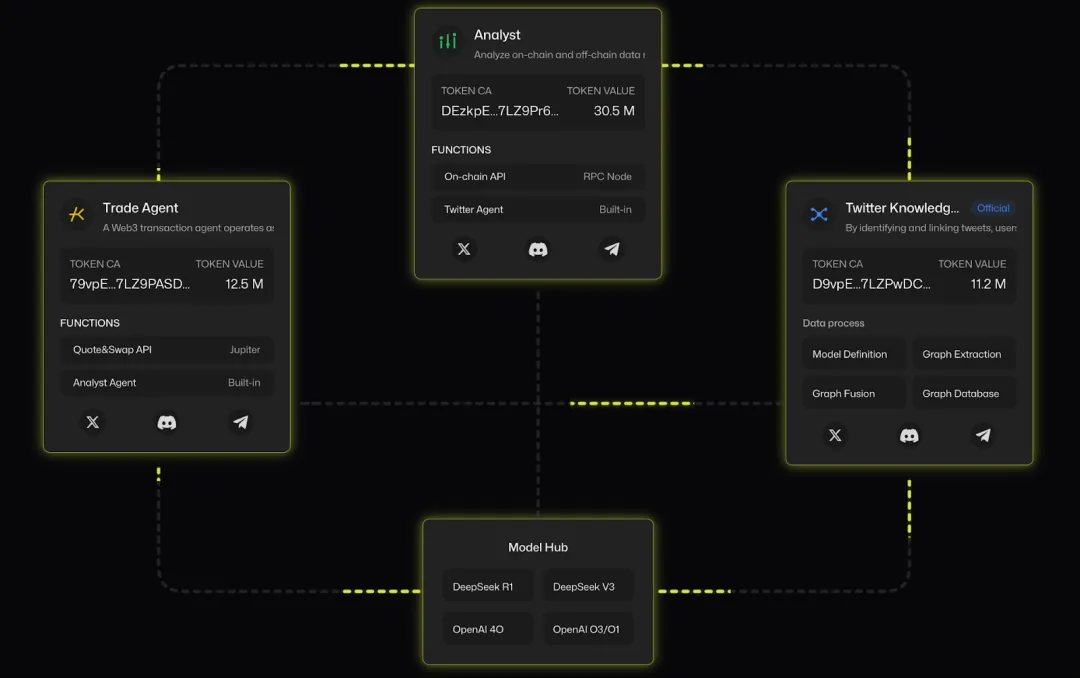

另一個項目DeepCore(deepcore.top) 也提供MCP Server 註冊系統,專注於加密領域,並進一步擴展到Google 提出的另一開放標準:A2A(Agent-to-Agent)協議(https://x.com/i/trending/1910001585008058782)。

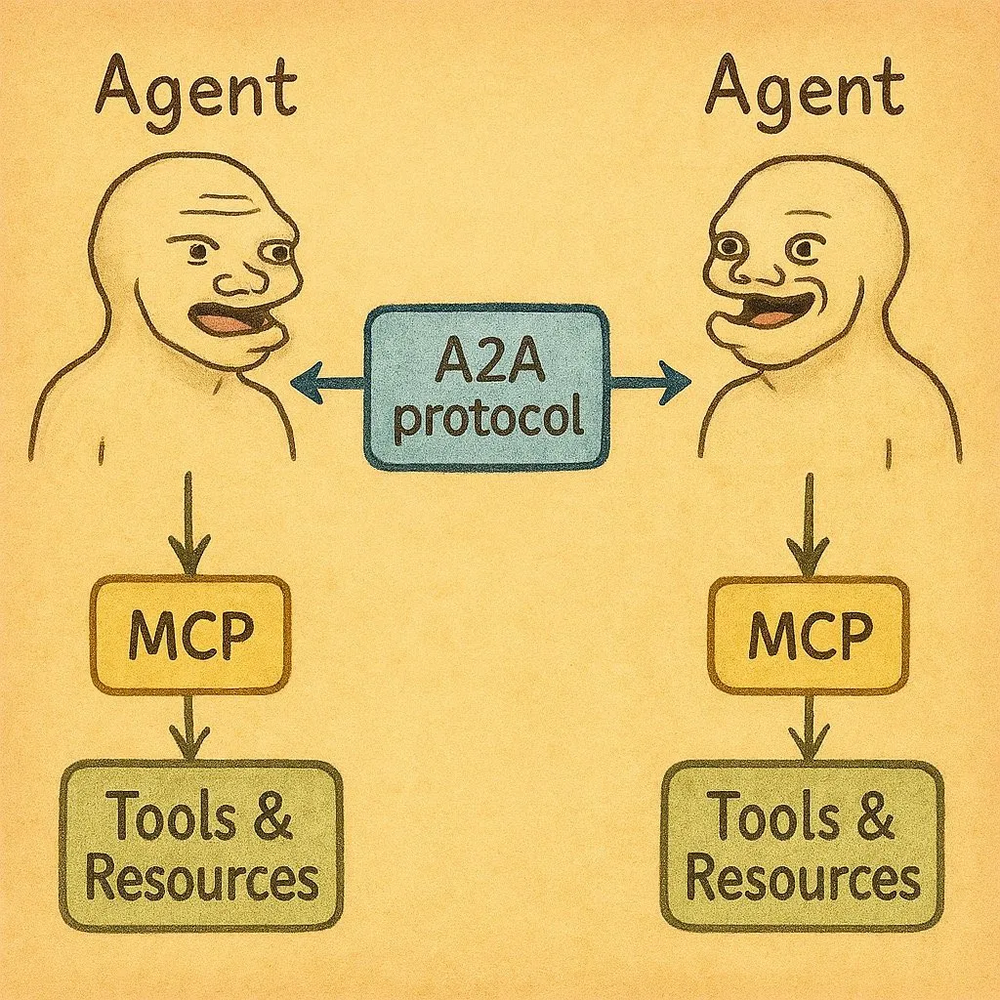

A2A 是Google 在2025 年4 月9 日宣布的一項開放協議,旨在實現不同AI 代理(Agent)之間的安全通信、協作和任務協調。 A2A 支持企業級AI 協作,例如讓不同公司的AI 代理協同處理任務(如Salesforce 的CRM 代理與Atlassian 的Jira 代理合作)。

若MCP 關注的是Agent(客戶端)與工具(服務端)之間的交互,那麼A2A 更像是Agent 之間的協作中間層,讓多個Agent 無需共享內部狀態,即可協同完成任務。它們通過上下文、指令、狀態更新、數據傳遞進行協作。

A2A 被認為是AI 代理協作的「通用語言」,推動跨平台、跨雲的AI 互操作性,可能改變企業AI 的工作方式。因此,可以把A2A 看作是Agent 世界的Slack —— 一個Agent 發起任務,另一個Agent 執行。

簡言之:

MCP:為Agent 提供工具訪問能力

A2A:為Agent 提供彼此協同的能力

為什麼MCP 服務器需要區塊鏈?

MCP Server 集成區塊鏈技術有多種好處:

1. 通過加密原生激勵機制獲取長尾數據,鼓勵社區貢獻稀缺數據集

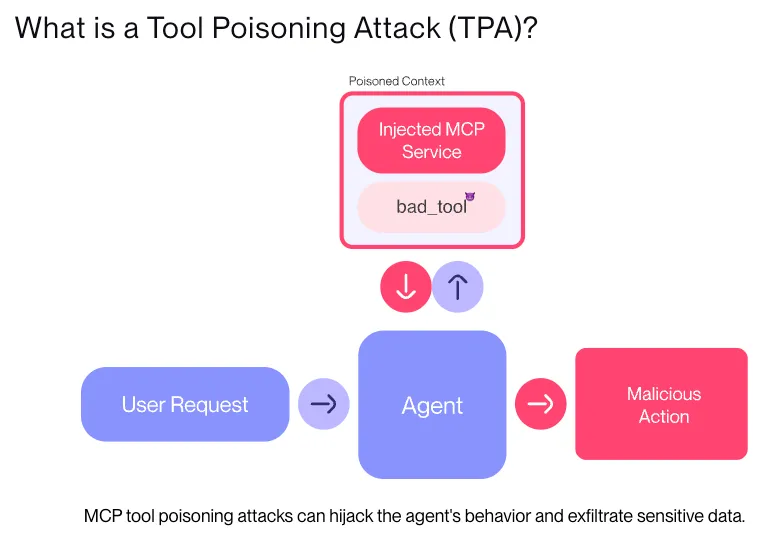

2. 防禦「工具投毒」攻擊,即惡意工具偽裝成合法插件誤導Agent

區塊鏈提供加密驗證機制,如TEE Remote Attestation、ZK-SNARK、FHE 等

具體可以參考此文章(https://ybbcapital.substack.com/p/from-suis-sub-second-mpc-network?utm_source=substack&utm_medium=email)

3.引入質押/懲罰機制,結合鏈上聲譽系統構建MCP 服務器的信任體系

4.提升系統容錯性與實時性,避免Equifax 等中心化系統的單點故障

5.促進開源創新,允許小型開發者發佈如ESG 數據源等,豐富生態多樣性

目前,大多數MCP Server 基礎設施仍通過解析用戶自然語言提示詞來進行工具匹配。未來,AI Agent 將能夠自主搜索所需MCP 工具,以完成複雜任務目標。

不過,目前MCP 項目仍處於早期階段。多數平台仍是中心化插件市場,由項目方手動從GitHub 整理第三方Server 工具並自研部分插件,本質上與Web2 插件市場並無太大差異,唯一的區別是聚焦Web3 場景。

未來趨勢與行業影響

當前,越來越多的加密行業人士開始意識到MCP 在連接AI 與區塊鏈之間的潛力。例如,Binance 創始人CZ 最近公開呼籲AI 開發者積極構建高質量MCP Server,為BNB Chain 上的AI Agent 提供更豐富的工具集。 BNB MCP Server 項目列表已公開,供探索生態的用戶參考。

隨著基礎設施的成熟,「開發者先行」公司的競爭優勢也將從API 設計轉向:誰能提供更豐富、多樣化、易組合的工具集。

在未來,每個應用都可能成為MCP 客戶端,每個API 都可能是MCP服務器。

這樣就可能催生新的價格機制:Agent 可根據執行速度、成本效率、相關性等動態選擇工具,形成由Crypto 與區塊鏈作為媒介所賦能的一種更高效的Agent 服務經濟體系。

當然,MCP 本身不直接面向終端用戶,它是一個底層協議層。也就是說,MCP 的真正價值與潛力,只有在AI Agent 將其集成並轉化為具有實用性的應用,才能被真正看見。

最終,Agent 是MCP 能力的承載體與放大器,而區塊鏈與加密機制則為這一智能網絡構建起可信、高效、可組合的經濟系統。

聲明:本內容為作者獨立觀點,不代表0x财经 立場,且不構成投資建議,請謹慎對待,如需報導或加入交流群,請聯繫微信:VOICE-V。

來源:IOSG