短期來看,Web3 驅動的分佈式算力的實現難度高,但是中長期看,這個是一個必然的結果和選擇。

原文標題:《A&T 前瞻: 為什麼Web3 驅動的分佈式算力網絡是元宇宙的基礎設施? 》

撰文:Rosie,A&T Capital 高級投資經理

Intro

根據網上對元宇宙的定義,元宇宙是利用科技手段(AR/VR/MR/XR 等) 在與現實世界映射或3D 虛擬世界裡進行鏈接和創造。筆者建議,把元宇宙看作與真實世界平行的空間,通過不同的技術手段,可以建立趨近於無數個平行的空間。 AR/VR/MR/XR 產業帶來的不僅僅是對硬件交互的顛覆,也給人類對空間的理解和在空間的使用上帶來了新的可能。

隨著明年蘋果推出名為Reality 的MR 設備,Meta 不斷迭代其Oculus 的VR,國內的Rokid、光粒、Nreal 等AR 設備廠商也在紛紛出貨,我們已經站在元宇宙爆發的前夕。本文基於對元宇宙硬件發展的理解,推導元宇宙應用大規模爆發時對計算和傳輸的要求,論證為何Web3 和分佈式算力將成為元宇宙時代的計算基礎設施。

元宇宙的發展現狀

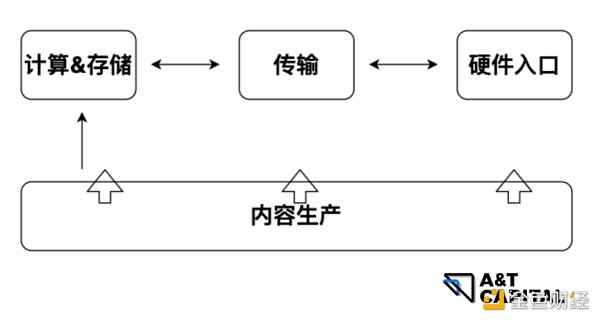

以內容作為驅動整個生態發展的底層邏輯,內容與計算和存儲諮詢交互,通過傳輸,內容到達AR/VR/MR/XR 硬件設備。用戶通過使用終端硬件進入元宇宙。本篇文章講AR/VR 的發展,重心主要落在計算和傳輸,存儲是另外一個大話題,將在後續文章裡單獨進行分析。

硬件

AR/VR 設備是用戶進入元宇宙的硬件入口。

AR

AR 全稱Augmented Reality/ 增強現實,即利用計算機模擬將虛擬物體疊加在真實環境裡,使他們在同一畫面和空間存在。

AR 的技術趨勢為光波導+Micro LED。

VR

VR 全稱Virtual Reality/ 虛擬現實,即利用計算機模擬生成3D 虛擬世界,向提供使用者近似真實的感官模擬。

VR 的技術趨勢為折疊光路+Micro OLED。

雖然AR 和VR 的具體技術路線有差異,但是總體的技術框架相似。兩者都是需要通過選擇光源和成像方案,將圖像呈現在顯示屏幕上,給用戶從視覺上製造沉浸感。

本篇文章對沉浸感的定義,是人對計算機系統創造和顯示出來的虛擬環境的感受無限趨近於人類對真實自然環境的感受。為了實現最高沉浸感,也就是最趨於人對真實世界感知的感受,對AR/VR 設備的顯示要求是類視網膜的要求。 AR/VR 設備的顯示屏有2 個重要參數直接影響用戶的沉浸感:

-

分辨率/Resolution 這裡先提一個單位,叫做PPD(Pixel Per Degree),它決定顯示的清晰程度。與傳統屏幕不同,AR/VR 等近眼設備採用PPD 衡量屏幕的清晰程度,PPD 代表視野中每一度視場角的像素密度。類視網膜的屏幕需要達到60PPD。另外一個需要理解的是FOV(Field of View)/ 視場角,也可以理解為視野。假設單眼橫向FOV 為110°,縱向約120°:2*(110 x 60) x (120 x 60) 按照分辨率定義,也就是一塊差不多13k 的屏幕才能滿足類視網膜的顯示需求。

-

刷新率/Rate of Refresh 可以用fps(frame per second) 理解,也就是每秒裡面有多少幀圖像( 一幀就是一張圖像)。見下圖,當fps 低的時候,人眼看到的物品的移動是不連續的。隨著幀數增加,人眼感受到的是物品在連續的移動。

引用:《Frame Rate: A Beginner’s Guide for Live Streaming》

當fps 低的時候,人會因為畫面的不連續產生暈眩感。所以通過提高fps 能降低使用AR/VR 硬件感受到的暈眩感。當達到60fps 的時候,基本上不會產生暈眩;當達到144 fps 的時候,就能達到人眼能察覺的最高極限,也就達到了人類感知真實環境的效果。

用戶數量

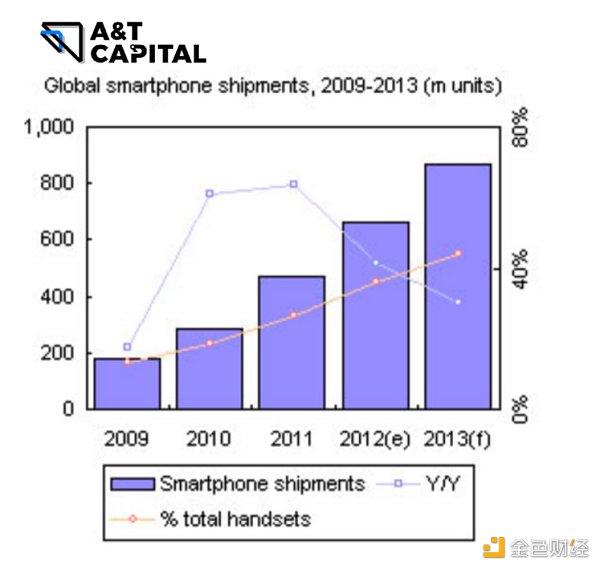

IDC 公佈2021 年全球AR/VR 出貨量達到1,120 萬台,同比增長92.1%。如果與智能手機的出貨量做類比( 見下圖),我們正所處在AR/VR 時代爆發的前夕。

隨著AR/VR 總出貨量的增加,越來越多的用戶將通過AR/VR 設備進入元宇宙,同時使用AR/VR 設備的在線人數會隨之增加。

現狀和痛點

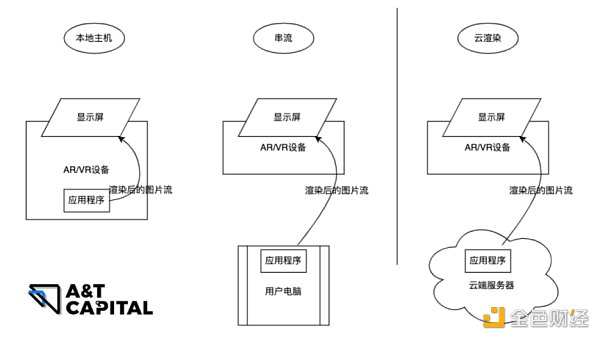

沉浸感是通過使用計算機生成的3D 虛擬世界或是通過圖像生成三維重建世界,投射在2D 屏幕上讓人感受到距離、光影、色差而得到的。 3D 虛擬世界是使用專業的建模軟件( 如unity) 生成的,而3D 世界( 包括三維重建的世界) 及里面的模型如何成像在2D 屏幕上是由渲染決定的。渲染是元宇宙世界裡使用最多算力的計算工作類型。渲染算法通過一系列參數( 例如光照角度、強度等) 計算出模型該有的陰影、顏色灰度等,生產出一張張讓人眼看上去與真實世界非常相近的圖片。用戶在AR/VR 設備裡看到的其實是渲染好的圖片流。現在做渲染的方式大類有三種( 見下):

本地主機:也就是應用程序跑在AR/VR 設備裡,直接使用AR/VR 設備的硬件進行渲染,渲染完成後直接推圖片流到AR/VR 設備裡的顯示屏。本地主機渲染架構有幾個大的痛點:

-

AR/VR 應用程序包大,導致在主機端無法同時下載和存儲多個應用;

-

AR/VR 主機廠的因為需要控制設備成本價格,不會選擇在主機上安裝很多計算資源,因此,AR/VR 設備不能滿足對渲染要求高的場景的應用程序,限制了能在AR/VR 設備上運行的應用程序數量和類型;

-

AR/VR 設備與人體接觸,需要維持其運行的溫度在人體能接受的區間,如果做太多本地計算則會使其溫度上升,讓熱管理成為一個問題;

-

由於是佩戴型設備,如果在本地做太多計算,用電速度則會加快,導致用戶需要頻繁充電,降低了用戶的佩戴時間。

基於上述的幾個痛點,AR/VR 內容提供商和主機廠普遍建議不要在本地做太多計算。

-

串流:也就是應用程序跑在用戶的電腦裡,使用電腦的硬件進行渲染,渲染完成後直接推圖片流到AR/VR 設備裡的顯示屏。串流架構最大的痛點在於渲染速度限制於用戶的硬件參數。非常少量的用戶擁有能做到13k@144 fps 渲染能力的硬件。因此,要達到大規模類人眼的渲染,需要更經濟和拓展性更強的計算方案。

-

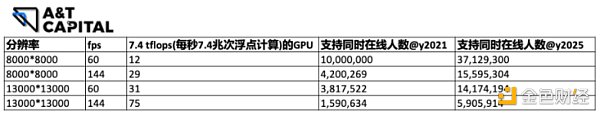

雲渲染:也就是應用程序跑在雲端服務器裡,使用雲端服務器的硬件進行渲染,渲染完成後直接推圖片流到AR/VR 設備裡的顯示屏。由於GPU 的設計是最適合做渲染類型的計算工作,假設:

-

所有的渲染工作都由雲端GPU 計算資源完成;

-

每個GPU 的算力為7.4TFLOPS – 即每秒處理7.4 兆個浮點計算。 7.4TFLOPS 這個數字是出貨量最大的GPU 的算力;

-

雲廠商擁有所有算力的30% – 30% 這個數字是基於全球雲滲透率是15.7% 的假設。

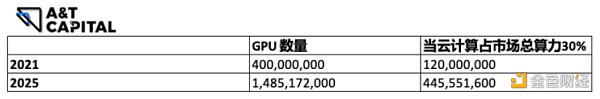

2021 年全球GPU 總出貨量加保有量大約是4 億顆,預計到2025 年年底GPU 總出貨量加保有量大約是~15 億顆。假設雲廠商擁有全市場30% 的算力,按照同比例,雲廠於2021 年擁有1.2 億顆GPU,於2025 年擁有4.5 億顆GPU。

根據分辨率和fps 的要求,算出每渲染一張照片每秒同時使用多少顆GPU;再從總GPU 數量,算出支持全球同時在線的AR/VR 設備數量。可以看到,當渲染計算強度是類人眼時,也就是渲染算力需求是13k@144 fps 時,使用雲渲染框架於2025 年年底僅支持同時在線AR/VR 設備數量約為6 百萬台。根據預測,僅2025 年單年AR/VR 設備出貨量會超1 億台。

因此,在可預見未來的幾年內,以雲廠商為主要渲染提供商的中心化的渲染算力將不足以支持AR/VR 時代的到來,需要新的計算方案和框架來支撐元宇宙的爆發。

Web3 驅動的分佈式算力網絡發展現狀

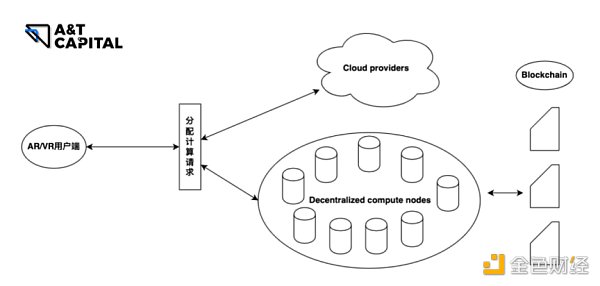

本文把用戶擁有的節點稱為分佈式計算節點,雲廠/IDC 擁有的計算節點稱為中心化計算節點。

通過區塊鏈技術+tokenomics 的方式來激勵現實世界算力的發展。 Multicoin Capital 將這個機制稱為物理工作證明Proof of Physical Work(PoPW)。 PoPW 獎勵用戶執行可驗證的物理工作,在本文裡是渲染計算。通過使用協議算法驗證設備的狀態並根據一組預定的規則獎勵算力貢獻者和驗證者。

是什麼

分佈式計算節點執行一個完整的渲染工作,或者一個渲染工作的一部分,將渲染後的圖像以圖像流的方式發送到客戶端(AR/VR 設備端)。

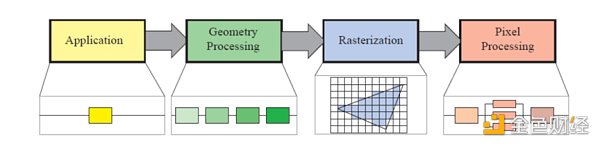

在元宇宙裡,渲染是對算力要求最高的計算工作。渲染的流程可以大致分為4 個階段,也叫做渲染管線:

引用《3D 可視化入門基礎:看渲染管線如何在GPU 運作》

-

Application 階段:在CPU 端執行,通常用於準備繪製所需的幾何數據、Uniform 數據等,並發送給GPU 端;

-

Geometry Processing 階段:又可以拆分為頂點著色、細分著色、幾何著色、Stream Out( 用於將Geometry Processing 階段處理的結果寫回到Buffer 中)、裁剪( 將超過NDC 的坐標裁剪掉並生成新的頂點)、以及屏幕映射(Screen Mapping,將NDC 坐標映射到屏幕坐標);

-

Rasterization( 光柵化) 階段:將上一階段處理的圖( 點,線,三角形) 轉變為一個個離散的像素塊;

-

Pixel Processing 階段:將光柵化生成的像素進行著色(Pixel Shading),之後將計算好的像素根據一定規則寫入到frame buffer 或者開發者指定的buffer 中。

在這些步驟裡,有幾步是可以被並行處理的,例如像素著色、頂點變換、圖元組裝或者通用計算等。這些可以被並行處理的計算可以被發送到不同的節點上進行工作,利用分佈式節點的算力,成為元宇宙的計算基礎設施。

如何成為元宇宙的基礎設施解決算力焦慮

在上文裡提到,當渲染強度是類人眼時,也就是渲染算力需求是13k@144 fps 時,根據我們的假設和估算,使用雲渲染框架於2025 年年底僅支持同時在線AR/VR 設備數量~6 百萬台。到這個零界點時,分佈式算力將不僅僅是作為算力的補充,而是成為支持元宇宙發展的剛需。另外一方面,由於雲廠的節點分佈相比起邊緣節點離用戶的物理距離遠,導致在雲端邊渲染好的圖片沒有邊緣邊渲染好的圖片傳輸的快。為了實現144 fps 的刷新速度,邊緣節點在傳輸距離上比起中心的服務器更短,也就是傳輸會更快。以tokenomics 的方式作為激勵全球節點貢獻算力的機制,使用POPW 的方式驗證數據完整性、正確性,推動全球的有算力的節點加入網絡,更好的服務全球不同地方用戶對元宇宙渲染工作的需求。

我們構想的元宇宙算力分佈將會類似下圖的架構:

算力

-

雲廠商的GPU 資源還是會被充分利用,但是作為general compute resource providers,GPU 資源除了被渲染使用,還有很大一部分會被AI 相關的領域所使用,所以需要調動更多的計算資源;

-

通過激勵模式,讓更多的節點加入算力網絡。通過評估網絡裡不同節點的算力的強度,分發相應的渲染工作;

-

AR/VR 端最終會收到多個節點推來的照片流。 AR/VR 端只需要對這些照片流進行排序即可在顯示屏上顯示給用戶。

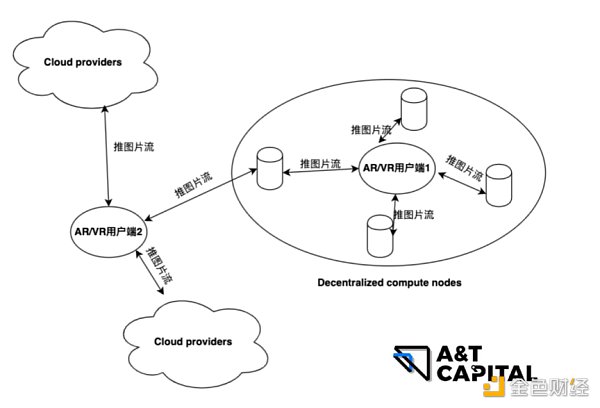

傳輸

理論上來說,電信號的傳播速度是光速,由於物理距離帶來的數據傳輸延遲高的原因在於這些信號在傳輸過程中會有損耗,因此,長距離傳輸需要經過「中轉站」。這些中轉站在收到數據後需要把這個數據的信號加強,還原成剛發出的信號。因為這個過程需要時間,所以總的來說是地理距離越遠,延遲越高。

-

如上圖所示,當用戶端1 在離雲廠商的機房物理距離遠時,選擇使用就近的分佈式網絡節點完成渲染任務;

-

用戶端2 在離雲廠商的機房物理距離近時且離某些分佈式節點近時,選擇混合渲染方案,即中心+ 分佈式方案;

-

AR/VR 端會接收多個節點推來的圖片流,完成排序後,顯示在屏幕上。

Tokenomics + PoPW

使用tokenomics 激勵全球的網絡用戶加入算力網絡,PoPW 的共識協議確保數據的正確性和完整性。

Tokenomics 用於基礎設施網絡有兩個好處:

-

能夠在全球範圍內快速擴展網絡,更好的響應全球的渲染工作的需求;

-

大型物理網絡需要資金投入,不管是前期購入硬件成本還是後期的運維和維護成本。通過使用tokenomics 構建和維護網絡並將收益全部分配給供應方是一種更具成本效益的解決方案。

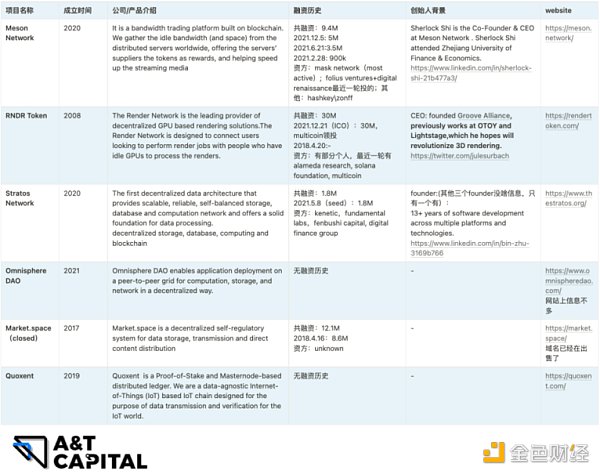

分佈式算力市場Mapping

總結

筆者認為,短期來看,Web3 驅動的分佈式算力的實現難度高,不管對於渲染模型、降低使用的GPU 門檻、還是傳輸,還需要時間發展。但是中長期看,這個是一個必然的結果和選擇,將會支持元宇宙大規模爆發,成為元宇宙裡算力的重要基建。