如何製造和使用人工智能的未來正處在一個十字路口

撰文:Will Douglas Heaven

來源:麻省理工科技評論

近日一份據稱是由谷歌高級工程師Luke Sernau 撰寫的洩密備忘錄,大聲說出了矽谷許多人幾週來的心聲:一場開源的自由競爭正在威脅著科技巨頭對人工智能的控制。

新的開源大型語言模型– 谷歌的Bard 或OpenAI 的ChatGPT 的替代品,允許研究人員和應用開發人員研究、建立和修改。這些模型是大公司創造的同類AI 模型的更小、更便宜的版本,性能上(幾乎)與它們相當,且是免費共享的。

像谷歌這樣的公司– 它在上週的年度產品展示會上透露,它正在將生成式人工智能應用於它所擁有的一切,從Gmail 到照片到地圖– 都忙著自己的產品,沒有看到真正的競爭到來,Sernau 寫道:“當我們在一直爭吵的時候,第三方一直在悄悄吃掉我們的午餐。”

在許多方面,這是件好事。更多接觸這些模型的機會有助於推動創新,也可以幫助抓住缺陷。如果只有幾家巨頭公司為這項技術把關或決定它的使用方式,人工智能就不會茁壯成長。

但這種開源的繁榮是不穩定的。大多數開源版本仍然站在擁有雄厚財力的大公司所推出的巨型模型的肩膀上。如果OpenAI 和Meta 決定關閉商店,繁榮的小鎮可能會變成落後之地。

例如,這些模型中有許多是建立在LLaMA 之上的,LLaMA 是Meta AI 發布的一個開源大型語言模型。其他模型則使用了一個名為Pile 的大規模公共數據集,該數據集由開源非營利組織EleutherAI 組建。 EleutherAI 之所以存在,只是因為OpenAI 的開放性意味著一群編碼員能夠逆向設計GPT-3 的製作方法,然後在空閒時間創建他們自己的。

“Meta AI 在培訓和向研究界發布模型方面做得非常好,”Stella Biderman 說,她是EleutherAI 的執行董事和研究主管,也在諮詢公司Booz Allen Hamilton 工作。 Sernau 在其穀歌備忘錄中強調了Meta AI 的關鍵作用。 (谷歌向《麻省理工科技評論》證實,該備忘錄是由其一名員工撰寫的,但指出它不是一份官方戰略文件)。

這一切都可能改變。由於擔心競爭,OpenAI已經在扭轉其之前的開放政策。而Meta 可能開始想遏制後起之秀用其開源代碼做不良的事情。 “說實話,我覺得現在這樣做(向外界開放代碼)是對的,”Meta AI 的總經理Joelle Pineau 說,“但這也是我們未來五年要採取的策略嗎?我不知道,因為人工智能的發展非常之快。”

如果關閉權限的趨勢繼續下去,那麼不僅開源社區會被孤立,下一代人工智能的突破也將完全回到世界上最大、最富有的人工智能實驗室手中。

如何製造和使用人工智能的未來正處在一個十字路口。

開源模型“富礦”

開源軟件已經存在了幾十年。它是互聯網運行的基礎。但建立強大模型的成本意味著開源人工智能直到大約一年前才開始騰飛。現在的它已迅速成為一種財富。

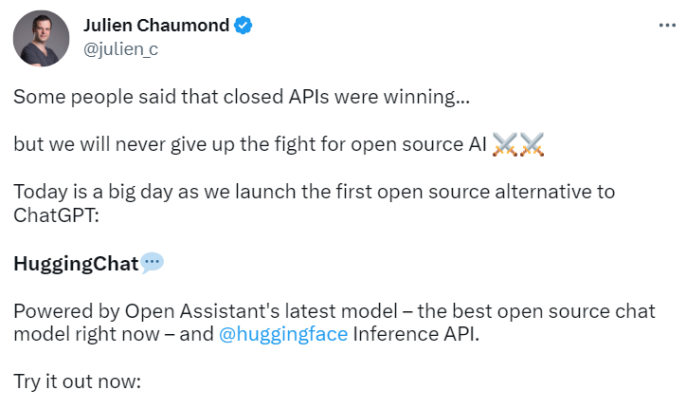

看看過去幾週的情況就知道了。 3 月25 日,倡導免費開放人工智能的初創公司Hugging Face 發布了ChatGPT 的第一個開源替代品。

Hugging Face 的聊天機器人HuggingChat 建立在開源的大型語言模型之上,該模型是在大約13000 名志願者的幫助下訓練的,並在一個月前發布。而Open Assistant 本身是建立在Meta 的LLaMA 之上的。

然後是StableLM,由Stability AI 於3 月19 日發布,該公司是熱門文本到圖像模型Stable Diffusion 的背後公司。 3 月28 日,Stability AI 發布了StableVicuna,這是StableLM 的一個版本,與Open Assistant 或HuggingChat 一樣,為對話而優化。 (可以把StableLM 看作是Stability 對GPT-4 的回應,StableVicuna 則是對ChatGPT 的回應)。

這些新的開源模型加入了過去幾個月發布的一系列其他模型,包括Alpaca(來自斯坦福大學的一個團隊)、Dolly(來自軟件公司Databricks)和Cerebras-GPT(來自AI 公司Cerebras)。這些模型中的大多數都是建立在LLaMA 或EleutherAI 的數據集和模型上;Cerebras-GPT 遵循DeepMind 設定的模板。而未來,相信會有更多的模型出現。

對於一些人來說,開源是一個原則問題。 “這是一個全球社區的努力,將對話式人工智能的力量帶給每個人……讓它脫離少數大公司的掌控,”人工智能研究員和YouTuber Yannic Kilcher 在介紹開放助理的視頻中表示。

“我們永遠不會放棄為開源人工智能而戰,”Hugging Face 的聯合創始人Julien Chaumond上個月在推特上如是說。

對其他人而言,這也是個利益問題。 Stability AI 希望在聊天機器人方面重複它在圖像方面的方法:為使用其產品的開發者的創新爆發提供動力,然後從中獲益。該公司計劃從這些創新中汲取精華,並將其帶回為廣泛的客戶定制的產品中。 “我們激發創新,然後進行挑選,”Stability AI 的首席執行官Emad Mostaque 說。 “這是世界上最好的商業模式。”

不管怎樣,大量免費和開放的大型語言模型將這項技術推向了世界各地數百萬人的手中,激勵了許多人創造新的工具並探索它們的工作原理。 Biderman 說:“使用這項技術的途徑比以往任何時候都要多。”

“坦率地說,人們使用這項技術的方式之多令人難以置信,令人興奮,”Fried Frank 律師事務所的律師Amir Ghavi 表示。他代表了包括Stability AI 在內的多家生成式人工智能公司。 “我認為這證明了人類的創造力,而這正是開源的全部意義所在。”

融化GPU

但是,從頭開始訓練大型語言模型– 而不是建立或修改它們– 是困難的。 Mostaque 說:“這仍然超出了絕大多數公司的能力範圍。”“我們在構建StableLM 時熔掉了一堆GPU。”

Stability AI 的第一個版本,即文本到圖像模型Stable Diffusion,與穀歌的Imagen 和OpenAI 的DALL-E 等封閉式同類產品一樣好,甚至更好。它不僅可以免費使用,而且還可以在一台好的家用電腦上運行。 Stable Diffusion 比其他任何模式都更能激發去年圍繞圖像製作人工智能的開源開發的爆發。

不過,這一次,Mostaque 希望管理好預期:StableLM 與GPT-4 相差甚遠。 “還有很多工作要做,”他說。 “它不像Stable Diffusion 那樣,可以立即獲得超級好用的東西。語言模型更難訓練。”

另一個問題是,模型越大就越難訓練。這不僅僅是由於計算能力的成本問題。訓練過程中,更大的模型也更經常出現故障,需要重新啟動,這使得這些模型的建立更加昂貴。

Biderman 說,在實踐中,大多數團體能夠負擔得起的訓練參數數量是有上限的。這是因為大型模型必須在多個不同的GPU 上進行訓練,而將所有這些硬件連在一起是很複雜的。她說:“在這種規模下成功地訓練模型是高性能計算研究的一個非常新的領域。”

確切的數字隨著技術的進步而變化,但現在Biderman 認為這個上限大致在60 億到100 億個參數之間。 (相比之下,GPT-3 有1750 億個參數;LLaMA 有650 億個。) 這不是一個確切的關聯,但一般來說,更大的模型往往表現得更好。

Biderman 預計,圍繞開源大型語言模型的大量活動將繼續下去。但它將集中於擴展或調整一些現有的預訓練模型,而不是推動基本技術的發展。她說:“只有少數幾個組織對這些模型進行了預訓練,我預計在不久的將來會保持這種狀態。”

這就是為什麼許多開源模型是建立在LLaMA 之上的原因,LLaMA 是由Meta AI 從頭開始訓練的,並由EleutherAI 發布的,EleutherAI 是一個非營利組織,它對開源技術的貢獻是獨一無二的。 Biderman 說,她知道只有一個類似的組織,而且是在中國。

EleutherAI 的起步得益於OpenAI。倒退到2020 年,這家位於舊金山的公司剛剛推出一個熱門的新模型。 “對於很多人來說,GPT-3 改變了他們對大規模人工智能的看法,”Biderman 說。 “就人們對這些模型的期望而言,它常常被認為是一種智力範式的轉變。”

由於對這項新技術的潛力感到興奮,Biderman 和其他一些研究人員想玩玩這個模型,以更好地了解它的工作原理。他們決定對其進行複制。

那時OpenAI 還沒有發布GPT-3,但它確實分享了足夠多的關於它是如何構建的信息,讓Biderman 和她的同事們弄清楚它是怎麼構建的。在OpenAI 之外,從來沒有人訓練過這樣的模型,但當時正值疫情,團隊沒有什麼其他事情可做。 Biderman 說:“當我參與其中時,我正在做我的工作並與我的妻子玩桌遊。”“因此,每週拿出10 或20 個小時來做這件事是比較容易的。”

該團隊的第一步是把一個巨大的新數據集放在一起,其中包含數十億的文本段落,與OpenAI 用來訓練GPT-3 的數據相媲美。 EleutherAI 將其數據集稱為Pile,並在2020 年底免費發布。

然後,EleutherAI 使用這個數據集來訓練其第一個開源模型。 EleutherAI 訓練的最大模型花了三個半月,由一家云計算公司贊助。 “如果我們自掏腰包,將花費我們大約40 萬美元,”她說。 ”這對一個大學研究小組來說要求太高了。”

援助之手

由於成本高昂,在現有模型的基礎上進行構建要容易得多。 Meta AI 的LLaMA 已經迅速成為許多新的開源項目的首選起點。自從Yann LeCun 在十年前成立以來,Meta AI 一直傾向於開源開發。這種心態是文化的一部分,Pineau 說:“這在很大程度上是一種自由市場,’快速行動,建造東西’的方法。”

Pineau 清楚地知道其好處。她說:“這確實讓有能力為開發這項技術做出貢獻的人多樣化。這意味著研究人員,企業家或民間組織等也可以看到這些模型。”

像更廣泛的開源社區一樣,Pineau 和她的同事們認為,透明度應該是一種規範。她說:“我敦促我的研究人員做的一件事是,在開始一個項目時,就考慮到你想要開源。因為當你這樣做時,它在數據使用和如何建立模型方面設定了更高的標準。”

大型語言模型會散播錯誤信息、偏見和仇恨言論。它們可以用來大規模生產宣傳或為惡意軟件工廠提供動力。 “你必須在透明度和安全性之間做出權衡,”Pineau 說。

對於Meta AI 來說,這種權衡可能意味著一些模型根本不會被發布。例如,如果Pineau 的團隊在Facebook 用戶數據上訓練了一個模型,那麼它將留在內部,因為私人信息洩露的風險太大。或者,該團隊可能會以點擊許可的方式發布該模型,規定它只能用於研究目的。

這就是它為LLaMA 採取的方法。但在其發布後的幾天內,有人在互聯網論壇4 chan 上發布了完整的模型和運行說明。 “我仍然認為對於這個特定的模型來說,這是正確的權衡,”Pineau 說。 “但我對人們會這樣做感到失望,因為這使得做這些發布更難。”

“我們一直得到來自公司領導層一直到馬克 [扎克伯格] 對這種做法的大力支持,但這並不容易,”她說。

Meta AI 的風險很高。她說:“當你是一個非常小的創業公司時,做一些瘋狂的事情的潛在責任要比你是一個非常大的公司時低得多。”“現在我們向成千上萬的人發布這些模型,但如果它變得更有問題,或者我們覺得安全風險更大,我們將關閉這個圈子,我們將只向已知的學術夥伴發布,他們有非常強大的證書– 根據保密協議或NDA,防止他們用這個模型建立任何東西,甚至為了研究目的。”

如果發生這種情況,那麼開源生態系統的許多寵兒可能會發現,他們在Meta AI 接下來推出的任何產品上構建的許可都將被取消。如果沒有LLaMA,Alpaca、Open Assistant 或Hugging Chat 等開源模型就不會那麼好。下一代的開源創新者也不會像現在的這批人那樣得到發展。

平衡

其他團隊也在權衡開源自由競爭的風險和回報。

在Meta AI 發布LLaMA 的同時,Hugging Face 推出了一個門禁機制,人們在下載該公司平台上的許多模型之前,必須申請訪問並得到批准……這個想法是為了只允許那些有正當理由的人接觸這個模型——由Hugging Face 決定。

“我不是一個開源的佈道者,”Hugging Face 首席倫理科學家Margaret Mitchell 說。 “我確實明白為什麼封閉很有意義。”

Mitchell 指出,未授權的色情製品是使強大的模型被廣泛使用的一個弊端例子。她說,這是圖像製作AI 的主要用途之一。

Mitchell 曾在谷歌工作,並共同創建了其道德人工智能團隊,她理解其中的緊張關係。她贊成她所說的“負責任的民主化”– 一種類似於Meta AI 的方法,即根據模型造成傷害或被濫用的潛在風險,以有控制的方式發布。她說:“我真的很欣賞開源的理想,但我認為建立某種問責機制是有用的。”

此外,OpenAI 也在關閉水龍頭。上個月,當它宣布GPT-4– 該公司為ChatGPT 提供動力的大型語言模型的新版本時,技術報告中有一個引人注目的句子:“鑑於像GPT-4 這樣的大規模模型的競爭格局和安全影響,本報告沒有包含關於架構(包括模型大小)、硬件、訓練計算、數據集構建、訓練方法或類似的進一步細節。”

這些新限制的部分原因是,OpenAI 現在是一家以盈利為目的的公司,與穀歌等公司競爭。但它們也反映了一種心態的變化。聯合創始人兼首席科學家Ilya Sutskever 在接受The Verge採訪時表示,該公司過去的開放性是一個錯誤。

OpenAI 的政策研究員Sandhini Agarwal 說:“以前,如果某樣東西是開源的,也許只有一小群程序員會關心。現在,整個環境已經改變。開源真的可以加速發展,並導致競爭。”

但它並不總是這樣。如果OpenAI 在三年前公佈GPT-3 的細節時有這種感覺,就不會有EleutherAI。

今天,EleutherAI 在開源生態系統中發揮著舉足輕重的作用。此後,它建立了幾個大型語言模型,Pile 被用來訓練許多開源項目,包括Stability AI 的StableLM(Mostaque 是EleutherAI 的董事會成員)。

如果OpenAI 分享的信息較少,這一切都不可能發生。像Meta AI 一樣,EleutherAI 實現了大量的開源創新。

但隨著GPT-4 甚至5、6 的封鎖,開源社區可能會再次被留在幾家大公司的後面進行修補。他們可能會發布狂野的新版本– 甚至可能威脅到谷歌的一些產品。但是,他們將被困在上一代的模式中。真正的進步,接下來的飛躍,將在閉門造車中發生。

這重要嗎?人們如何看待大型科技公司關閉權限的影響,以及這將對開源產生的影響,在很大程度上取決於你對人工智能應該如何製造以及應該由誰製造的看法。

“人工智能很可能成為未來幾十年社會組織方式的驅動力,”Ghavi 說。 “我認為,建立一個更廣泛的監督和透明體系,比把權力集中在少數人手中要好。”

Biderman 對此表示贊同:“我絕對不認為每個人都做開源有某種道德上的必要性,”“但說到底,讓人們開發和研究這項技術是非常重要的,而不是為其商業成功進行經濟投資。”

然而,她很清楚其中的利害關係。她說:“實際上,我對OpenAI 的批評比很多人認為的要少得多,”她說。 “公開發布這項技術有真正的風險,真正的潛在危險。”

OpenAI 聲稱它只是在謹慎行事。 OpenAI 信任與安全團隊負責人Dave Willner 表示:“我們並不是認為透明度不好。”“更重要的是,我們正在努力弄清楚如何協調透明度和安全性。隨著這些技術變得越來越強大,在實踐中,這些東西之間存在一定程度的緊張關係。”

“人工智能的很多規範和思維都是由學術研究團體形成的,它們重視合作和透明度,這樣人們就可以在彼此的工作基礎上發展,”Willner 說。 “也許隨著這項技術的發展,這種情況需要有所改變。”

展開全文打開碳鏈價值APP 查看更多精彩資訊