人工智能時代,我們需要了解什麼?

來自:Techcrunch

編譯:巴比特

人工智能(AI)似乎出現在現代生活的每一個角落,從音樂和媒體到商業和生產力,甚至是約會。有太多東西很難跟上。本文將介紹AI 從最新的大發展到你需要知道的術語和公司的一切,以便在這個快速發展的領域了解最新狀態。

首先,什麼是人工智能?

人工智能,也稱為機器學習(Machine Learning),是一種基於神經網絡的軟件系統,這種技術實際上是幾十年前開創的,但最近由於強大的新計算資源而蓬勃發展。目前,AI 已經實現了有效的語音和圖像識別,以及生成合成圖像和語音的能力。研究人員正在努力使人工智能能夠實現瀏覽網頁、訂票、調整食譜等功能。

但是,如果你擔心黑客帝國式的機器崛起——不必擔憂。我們稍後再談這個問題!

本篇AI 指南包含兩個主要部分:

- 首先,你需要了解的最基本概念以及最近的重要概念。

- 然後,概述AI 的主要參與者及其重要性。

AI 101

圖片來源: Andrii Shyp / Getty Images

關於AI 的一個瘋狂之處是,儘管其核心概念可以追溯到50 多年前,但在最近之前,即使是精通技術的人也很少熟悉其中的概念。因此,如果你感到迷茫,請不要擔心——每個人都是如此。

有一件事我們要預先明確:雖然它被稱為“人工智能”,但這個詞有點誤導。目前智能沒有統一的定義,但這些系統所做的絕對更接近於計算器而不是大腦,只是這個計算器的輸入和輸出更加靈活。人工智能可能就像“人造椰子”(Artificial Coconut)——它是模仿智能。

以下是在任何有關AI 的討論中都會找到的基本術語。

神經網絡

我們的大腦主要由稱為神經元的相互連接的細胞構成,它們相互嚙合形成執行任務和存儲信息的複雜網絡。自20 世紀60 年代以來,人們一直在嘗試在軟件中重建這個驚人的系統,但所需的處理能力直到15-20 年前才被廣泛應用,當時的GPU 讓數字定義的神經網絡蓬勃發展。

從本質上講,它們只是很多點和線:點是數據,線是這些值之間的統計關係。就像在大腦中一樣,這可以創建一個多功能係統,快速接收一個輸入,通過網絡傳遞並產生一個輸出。這個系統被稱為模型。

模型

模型是接受輸入並返回輸出的實際代碼集合。與統計模型或模擬複雜自然過程的建模系統在術語上的相似性並非偶然。在AI 中,模型可以指像ChatGPT這樣的完整系統,或者幾乎任何AI 或機器學習結構,無論它做什麼或產生什麼。模型有各種大小,這意味著它們佔用多少存儲空間以及它們運行需要多少計算能力。而這些都取決於模型的訓練方式。

訓練

為了創建一個AI 模型,構成系統基礎的神經網絡會暴露在所謂的數據集或語料庫中的一堆信息中。在這樣做的過程中,這些巨大的網絡創建了該數據的統計表示。這個訓練過程是計算最密集的部分,這意味著它需要在巨大的高功率計算機上花費數週或數月的時間。這樣做的原因不僅是網絡複雜,而且數據集可能非常大:必須分析數十億個單詞或圖像,並在巨大的統計模型中給出表示。另一方面,一旦模型完成訓練,它在使用時可以小得多,要求也低得多,這個過程稱為推理(Inference)。

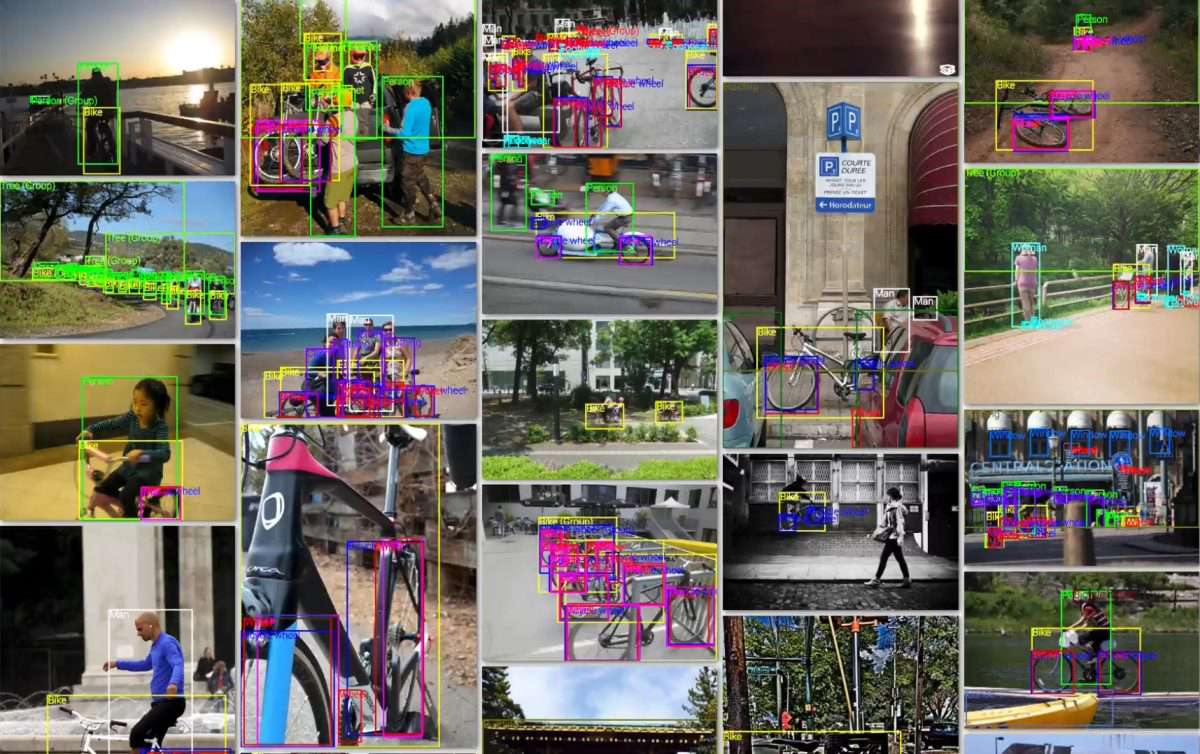

圖片來源:谷歌

圖片來源:谷歌

推理(Inference)

當模型真正發揮作用時,我們稱之為推理,這個詞的傳統含義非常多:通過對可用證據的推理來陳述一個結論。當然,這不完全是“推理”,而是在統計學上將它攝取的數據中的點聯繫起來,實際上是預測下一個點。例如,說“完成以下序列:紅色、橙色、黃色……”它會發現這些詞對應於它所攝取的列表的開頭,即彩虹的顏色,並推斷下一個項目,直到它產生了該列表的其餘部分。

推理的計算成本通常比訓練低得多:可以把它想像成瀏覽卡片目錄而不是組裝它。大型模型仍然必須在超級計算機和GPU 上運行,但較小的模型可以在智能手機或更簡單的設備上運行。

生成式人工智能

每個人都在談論生成式AI,這個廣義術語僅指生成原始輸出(如圖像或文本)的AI 模型。一些AI 進行總結,一些進行重組,一些進行識別等等——但真正生成某些東西(無論它是否“創造”是有爭議的)的AI 現在特別流行。請記住,僅僅因為AI 生成了某些東西,並不意味著它是正確的,甚至不意味著它反映了現實!只是它在你要求之前並不存在,就像一個故事或一幅畫。

現在的熱門詞彙

除了基礎知識,以下是2023 年年中最相關的AI 術語。

大型語言模型(LLM)

大型語言模型是當今最具影響力和用途最廣泛的人工智能形式,大型語言模型是在幾乎所有構成網絡的文本和大部分英語文學作品上進行訓練的。攝取所有這些會產生一個巨大的基礎模型(繼續閱讀)。 LLMs 能夠用自然語言交談和回答問題,並模仿各種風格和類型的書面文件,ChatGPT、Claude 和LLaMa 等工具就證明了這一點。

儘管這些模型無疑令人印象深刻,但必須牢記它們仍然是模式識別引擎,當它們回答問題時,就是試圖完成它已識別的模式,無論該模式是否反映現實。 LLMs 經常在它們的答案中產生幻覺,我們很快就會談到。

如果你想了解更多關於LLM 和ChatGPT 的信息,點擊此處查閱。

基礎模型(Foundation Model)

在巨大的數據集上從頭開始訓練一個巨大的模型既昂貴又復雜,所以你不想做得比你必須做的更多。基礎模型是需要超級計算機才能運行的從頭開始的大型模型,但通常通過減少參數的數量,它們可以被縮減到更小的容器中。你可以將這些視為模型必須處理的總點數,如今它可以達到數百萬、數十億甚至數万億。

微調

像GPT-4這樣的基礎模型很聰明,但它在設計上也是一個通才——它吸收了從狄更斯到維特根斯坦再到龍與地下城規則的所有內容,但如果你想讓它根據你的簡歷寫一封求職信,這些都是沒有用的。幸運的是,可以通過使用專門的數據集對模型進行一些額外的訓練來對模型進行微調。例如,碰巧有幾千份工作申請。這讓模型更好地了解如何在該領域幫助用戶,而不會丟棄它從其餘訓練數據中收集的一般知識。

從人類反饋中強化學習(RLHF),是一種你會經常聽到的特殊微調——它使用人類與LLM 交互的數據來改善其溝通技巧。

擴散(Diffusion)

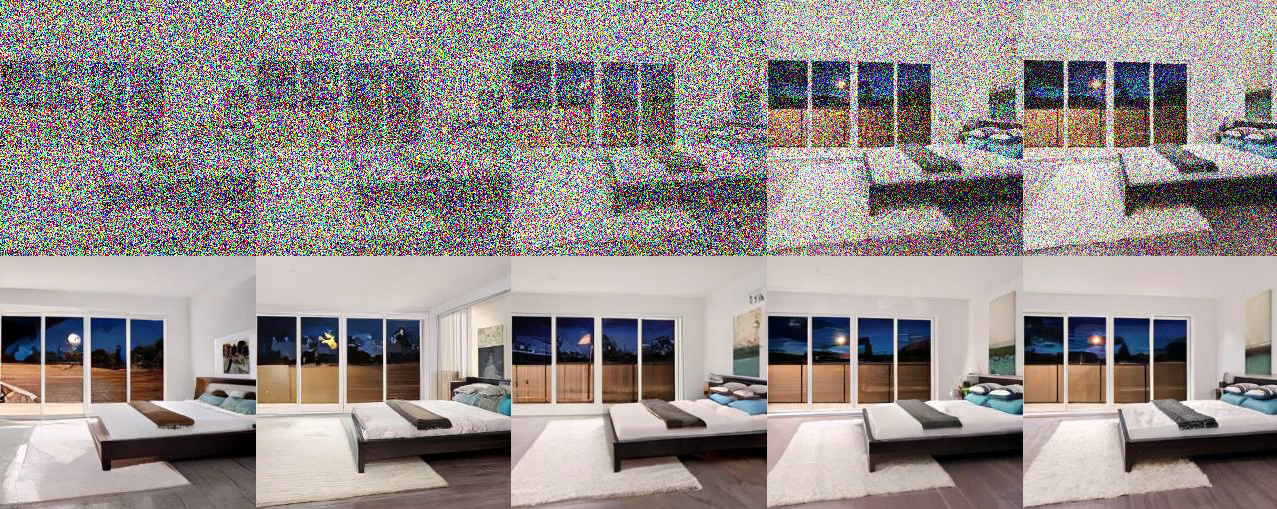

從一篇關於高級後擴散技術的論文中,你可以看到如何從非常嘈雜的數據中再現圖像。

圖像生成可以通過多種方式完成,但迄今為止最成功的是擴散,這是Stable Diffusion、Midjourney 和其他流行的生成AI 的核心技術。通過向擴散模型展示圖像來訓練擴散模型,這些圖像通過添加數字噪聲逐漸退化,直到原始圖像一無所有。通過觀察這一點,擴散模型也學會了反向執行該過程,逐漸向純噪聲添加細節以形成任意定義的圖像。我們已經開始在圖像上超越這一點,但該技術是可靠的並且相對容易理解,所以它會很快被淘汰。

幻覺(Hallucination)

最初這是一個訓練中的某些圖像滑入不相關輸出的問題,例如由於訓練集中狗圖片的過度流行,建築物似乎變得由狗組成。現在據說人工智能會產生幻覺,因為它的訓練集中沒有足夠或相互衝突的數據,它只是編造一些東西。

一個被要求創造原創或甚至衍生藝術的AI 正在產生幻覺。例如,一個LLM 可以被告知以Yogi Berra 的風格寫一首情詩,它會很樂意這樣做——儘管這樣的東西在它的數據集中並不存在。但是當需要一個事實答案時,這可能是一個問題;模型將自信地呈現出一半真實、一半幻覺的反應。目前除了自己檢查之外沒有簡單的方法來判斷哪個是哪個,因為模型本身實際上並不知道什麼是“真”或“假”,它只是試圖盡可能地完成一個模式。

AGI 或強人工智能

通用人工智能(AGI)或強人工智能,並不是一個真正定義明確的概念,但最簡單的解釋是,它是一種足夠強大的智能,不僅可以做人們所做的事情,還可以像我們一樣學習和改進自己。有些人擔心,這種學習、整合這些想法、然後更快地學習和成長的循環將是一種自我延續的循環,會導致一個無法約束或控制的超級智能係統。一些人甚至提議推遲或限制研究以防止這種可能性。

這是一個可怕的想法。而像《黑客帝國》和《終結者》這樣的電影已經探索瞭如果人工智能失控並試圖消滅或奴役人類可能會發生的情況。但這些故事並不以現實為基礎。我們在ChatGPT 等事物中看到的智能外觀令人印象深刻,但與我們與“真實”智能相關聯的抽象推理和動態多領域活動幾乎沒有共同之處。

儘管預測未來的發展幾乎是不可能的,但把AGI 想像成星際太空旅行在理解上可能會有所幫助:我們都理解這個概念,並似乎也在朝著這個方向努力,但與此同時,我們離實現它還有很長的路要走。正如AGI,由於需要巨大的資源和基礎科學進步,沒有人會突然偶然地完成它!

思考AGI 很有趣,但沒有必要自找麻煩,因為正如評論員指出的那樣,儘管AI 有其局限性,但它已經在今天帶來了真實而重大的威脅。沒有人想要天網,但你不需要配備核武器的超級智能來造成真正的傷害:今天人們正在失去工作並上當受騙。如果我們不能解決這些問題,我們還有什麼機會對抗T-1000?

人工智能領域的頂級玩家

OpenAI

圖片來源: Leon Neal / Getty Images

圖片來源: Leon Neal / Getty Images

如果AI 中有一個家喻戶曉的名字,那就是OpenAI。顧名思義,OpenAI 是一個打算進行研究併或多或少公開提供結果的組織。此後,它重組為一家更傳統的營利性公司,通過API 和應用程序提供對ChatGPT 等高級語言模型的訪問。它由Sam Altman 領導,他是一位技術派的億萬富翁,儘管如此,他還是對人工智能可能帶來的風險發出了警告。 OpenAI 是LLMs 領域公認的領導者,但也在其他領域進行研究。

微軟

如你所料,微軟在AI 研究方面做出了應有的貢獻,但與其他公司一樣,或多或少未能將其實驗轉化為主要產品。它最明智的舉動是儘早投資OpenAI,這使它與該公司建立了獨家長期合作夥伴關係,該公司現在為其Bing 對話代理提供支持。儘管它自己的貢獻較小且不太直接適用,但該公司確實擁有相當大的研究實力。

谷歌

谷歌以其登月計劃而聞名,不知何故錯過了人工智能的機會,儘管它的研究人員確實發明了直接導致今天人工智能爆炸的技術:變壓器。現在它正在努力開發自己的LLMs 和其他代理,但在過去十年花費大部分時間和金錢來推動過時的人工智能“虛擬助手”概念之後,它顯然正在追趕。首席執行官Sundar Pichai 多次表示,公司在搜索和生產力方面堅定支持AI。

Anthropic

在OpenAI 偏離開放性之後,Dario 和Daniela Amodei 離開了它,創辦了Anthropic,意在填補一個開放和道德上考慮周全的AI 研究組織的角色。憑藉他們手頭的現金數量,他們是OpenAI 的有力競爭對手,即使他們的模型(如Claude)還沒有那麼受歡迎或知名。

圖片來源: Bryce Durbin / TechCrunch

圖片來源: Bryce Durbin / TechCrunch

Stability

有爭議但不可避免的是,Stability 代表了“隨心所欲”的AI 實施開源流派,它收集了互聯網上的所有內容,並在你擁有運行它的硬件的情況下,免費提供它訓練的生成AI 模型。這非常符合“信息想要自由”的理念,但也加速了道德上可疑的項目,如生成色情圖像和未經同意使用知識產權(有時同時發生)。

埃隆·馬斯克(Elon Musk)

馬斯克也不例外,他直言不諱地表達了他對失控的人工智能的擔憂,以及在他早期為OpenAI 做出貢獻並且朝著他不喜歡的方向發展之後的一些酸葡萄情緒。雖然馬斯克不是這方面的專家,但像往常一樣,他的滑稽動作和評論確實引起了廣泛的反響(他是上述“人工智能暫停”信件的簽署人),而且他正試圖建立自己的研究機構。

展開全文打開碳鏈價值APP 查看更多精彩資訊