撰文:Faust,極客web3

摘要:

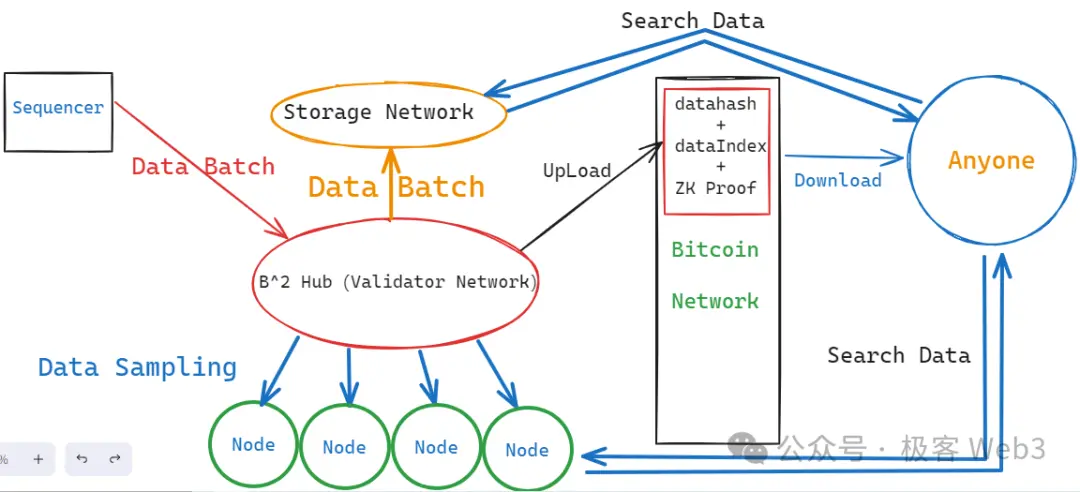

B^2 Network 在比特幣鏈下設置了名為B^2 Hub 的DA 層,該DA 層網絡借鑒了Celestia 的思路,引入數據採樣與糾刪碼,確保新增數據可以快速的分發給大量的外部節點,並極力避免資料扣留的發生。同時,B^2 Hub 網路中的Committer 會把DA 資料的儲存索引以及資料hash 上傳到比特幣鏈上,供任何人讀取;

為了減輕DA 層節點的壓力,B^2 Hub 中的歷史資料不會永久保存,所以B^2 又嘗試搭建起一個儲存網絡,透過類似Arweave 的儲存激勵方式,刺激更多節點儲存更完整的歷史資料集,以獲取儲存激勵;

在狀態驗證方面,B^2 採用了混合式的驗證方案,在鏈下驗證ZK 證明,鏈上通過bitVM 的思路,挑戰ZK 證明驗證痕跡,只要有1 個挑戰者節點在檢測到錯誤後發起挑戰,B^2 網路就是安全的,這符合詐欺證明協議的信任模型,但由於用到了ZK,這種狀態驗證實際上是混合型的。

依照B^2 Network 的未來路線圖,EVM 相容的B^2 Hub 可以成為對接多個比特幣Layer2 的鏈下驗證層與DA 層,成為一個類似BTCKB 的比特幣鏈下功能拓展層。由於比特幣本身無法支援許多場景,這種鏈下搭建功能拓展層的方式將會成為Layer2 生態越來越常態化的現象。

B^2 Hub:比特幣鏈下的通用DA 層與驗證層

如今的比特幣生態可謂是一片機會與騙局共存的藍海,這個因銘文之夏而煥發生機的全新領域簡直是一片肥沃的處女地,到處都瀰漫著金錢的氣息。隨著今年1 月比特幣Layer2 如雨後春筍般集體湧現,這片原本如荒蕪原野的土地瞬間就成為了無數造夢者的搖籃。

但回歸到最本質的問題:什麼是Layer2,人們似乎始終沒有共識。側鍊是嗎?索引器是嗎?搭橋的鏈條就叫Layer2 嗎?一個依賴比特幣和以太坊的簡易插件,可不可以當一個Layer?這些問題就像一組難解的方程式,始終沒有一個確切的結局。

而依照以太坊和Celestia 社群的思路,Layer2 只是模組化區塊鏈的特殊情況,在這種情況下,所謂的「二層」與「一層」之間會存在緊密的耦合關係,二層網絡可以很大程度,或一定程度繼承Layer1 的安全性。至於安全性這個概念本身,可以拆解為細分的多個指標,包括:DA、狀態驗證、提款驗證、抗審查性、抗重組等。

由於比特幣網路本身存在許多問題,其天生不利於支援較完整的Layer2 網路。例如在DA 上,比特幣的資料吞吐量遠低於以太坊,以其平均10min 的出塊時間來計算,比特幣最大的資料吞吐量僅6.8KB/s,差不多是以太坊的1/20 ,如此擁擠的區塊空間自然而然地造就了高昂的資料發布成本。

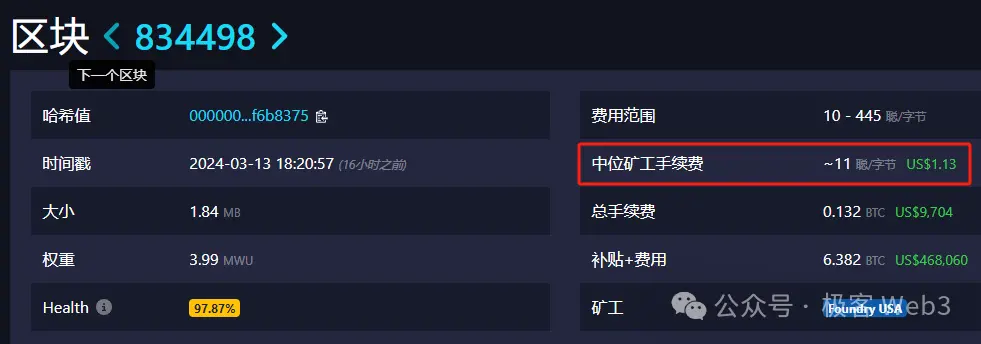

(比特幣區塊裡的數據發布成本,甚至可以達到每位元組1.13 美元)

如果Layer2 直接把新增的交易資料發佈到比特幣區塊裡,既無法實現高吞吐量,也無法實現低手續費。所以要嘛就透過高度壓縮,把資料尺寸壓縮的盡可能小,再上傳到比特幣區塊。目前Citrea 採用了這種方案,它們聲稱,將把一段時間內的狀態變化量(state diff),也就是多個帳戶上發生的狀態變更結果,連同對應的ZK 證明,一起上傳到比特幣鏈上。

在這種情況下,任何人都可以從比特幣主網下載state diff 和ZKP,驗證是否有效,但上鍊的資料尺寸卻可以輕量化。

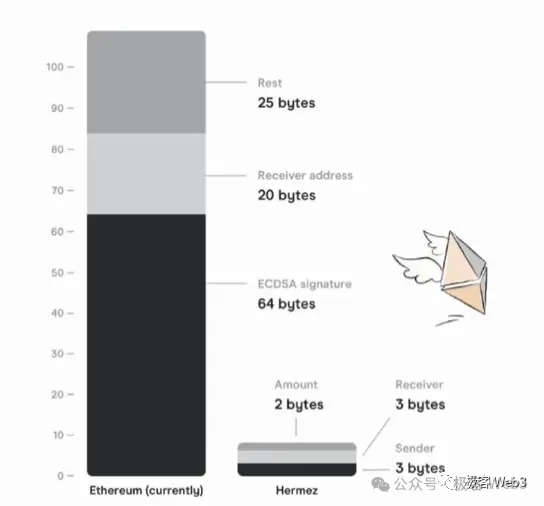

(前Polygon Hermez 的白皮書中,說明了上述壓縮方案的原理)

這種方案在極大程度壓縮了資料尺寸的同時,最終還是容易遇到瓶頸。例如,假設在10 分鐘內發生了幾萬筆交易,使得上萬個帳戶發生了狀態變更,你最終還是要把這些帳戶的變化情況,匯總上傳到比特幣鏈上。雖然比起直接上傳每筆交易數據,要輕量很多,但還是會產生很可觀的數據發布成本。

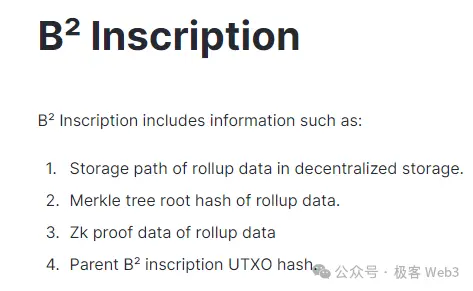

所以很多比特幣Layer2 乾脆就不要把DA 資料上傳到比特幣主網,直接採用Celestia 等第三方DA 層。而B^2 採取了另一種方式,直接在鏈下搭建一個DA 網路(資料分發網路),名為B^2 Hub。在B^2 的協議設計中,交易數據或state diff 等重要數據存放於鏈下,只向比特幣主網上傳這些數據的存儲索引,以及數據hash(其實是merkle root,為了表述方便說成數據hash)。

這些資料hash 和儲存索引,以類似銘文的方式寫入到比特幣鏈上,只要你運行一個比特幣節點,就可以把資料hash 和儲存索引下載到本地,根據索引值,能從B^2 的鏈下DA 層或儲存層中,讀取到原始資料。根據數據hash,你可以判斷,自己從鏈下DA 層獲取的數據是否正確(能否和比特幣鏈上的數據hash 相對應)。透過這種簡單的方式,Layer2 可以避免在DA 問題上過度依賴比特幣主網,節省手續費成本並實現高吞吐量。

當然,有一點不可忽視,就是這種鏈下的第三方DA 平台有可能搞數據扣留,拒絕讓外界獲取到新增的數據,這種場景有一個專用術語,叫「數據扣留攻擊」,可以歸納為數據分發中的抗審查問題。不同的DA 方案有不同的解決辦法,但核心宗旨,都是要把資料盡可能快、盡可能廣泛的傳播出去,防止一小撮特權節點控制著資料擷取權限不放。

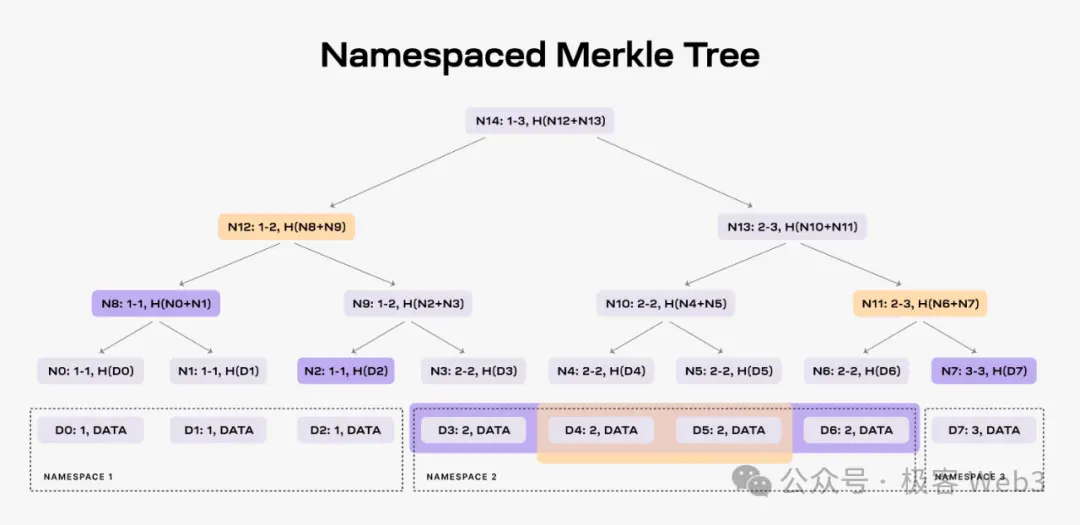

按照B^2 Network 官方新的路線圖,其DA 方案借鑒了Celestia。在後者的設計中,第三方的數據提供者會不斷的向Celestia 網路提供數據,Celestia 出塊者會把這些數據片段,組織為Merkle Tree 的形態,塞到TIA 區塊裡,廣播給網路裡的Validator/ 全節點。

由於這些數據比較多,區塊比較大,多數人運作不起全節點,只能運行輕節點。輕節點不同步完整區塊,只同步一個區塊頭,寫有Mekrle Tree 的樹根Root。

輕節點僅憑區塊頭,自然不知道Merkle Tree 的全貌,不知道新增資料都有什麼,無法驗證資料是否有問題。但輕節點可以向全節點索取樹上的某個葉子leaf。全節點會依照要求,把leaf 和對應的Merkle Proof,一併提交給輕節點,讓後者確信,這個leaf 的確存在於Celestia 區塊裡的Merkle Tree 上,而不是被節點憑空杜撰出的虛假數據。

(圖片來源:W3 Hitchhiker)

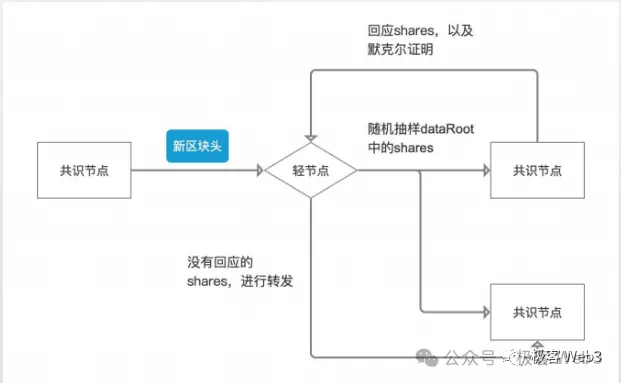

Celestia 網路裡存在大量的輕節點,這些輕節點可以向不同的全節點發起高頻的資料取樣,隨機性的抽選Merkle Tree 上的某幾個資料片段。輕節點獲取到了這些資料片段後,也可以傳播給他能連接到的其他節點,這樣就可以快速的把資料分發給盡可能多的人/ 設備,以此來實現高效的資料傳播,只要足夠多的節點都能快速取得最新的數據,人們就不用再信任一小撮數據提供者,這其實就是DA/ 數據分發的核心目的之一。

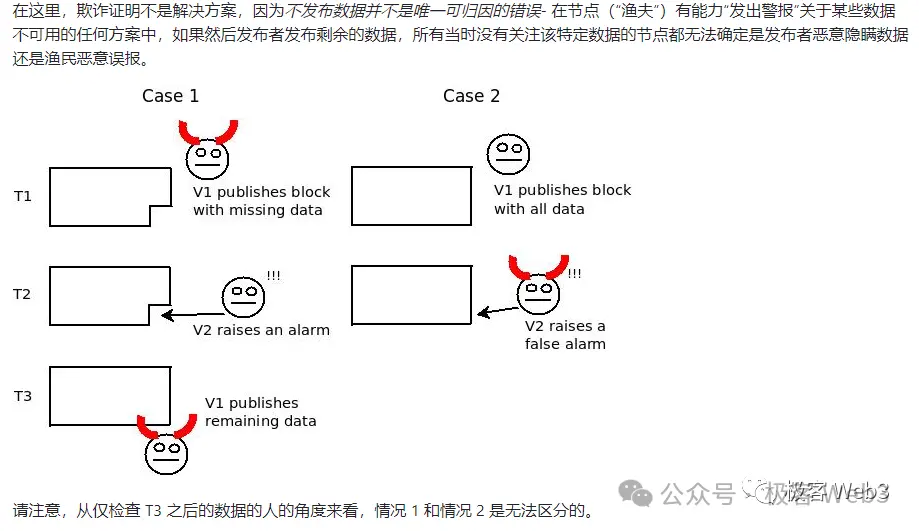

當然,僅憑上面描述的方案,還是存在攻擊場景,因為它只能保證數據分發時,人們都能快速獲取到數據,但無法保證數據的生產源頭不作惡。例如,Celestia 出塊者可能在區塊裡摻雜一點垃圾數據,人們即便獲取了區塊中的全部數據片段,也無法還原出「本應包含」的完整數據集(注意:這裡「本應」這個字很重要)。

進一步說,原始資料集中可能有100 筆交易,其中某筆交易的資料沒有完整傳播給外界。這時,只需要隱藏1% 的資料片段,外界就無法解析出完整資料集。這正是最早的數據扣留攻擊問題中,所探討的場景。

其實,根據這裡描述的場景來理解數據可用性,可用性這個詞描述的是區塊裡的交易數據是否完整,是否可用,能否直接交由其他人去驗證,而不是像很多人理解的那樣,可用性代表區塊鏈歷史資料能否被外界讀取。所以,Celestia 官方和L2BEAT 創辦人曾指出,數據可用性應該改名為資料發布,意思是區塊裡是否發布了完整可用性的交易資料集。

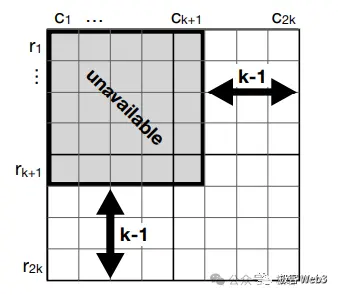

Celestia 引入了二維糾刪碼,解決上面描述的資料扣留攻擊。只要區塊裡包含的1/4 的資料片段(糾刪碼)有效,人們就可以還原出對應的原始資料集。除非出塊者在區塊裡摻雜3/4 的垃圾資料片段,才能讓外界無法還原出原始資料集,但在這種情況下,區塊裡包含的垃圾資料太多了,很容易就會被輕節點們檢測出來。所以對於區塊生產者而言,還是不要作惡來的更好些,因為作惡幾乎很快就被無數人察覺到。

透過前面描述的方案,可以有效防止「資料分發平台」出現資料扣留,而B^2 Network 未來會以Celestia 的資料採樣作為重要參考,可能結合KZG 承諾等密碼學技術,進一步降低輕節點執行資料採樣和驗證的成本。只要執行資料採樣的節點夠多,就能讓DA 資料的分發變得有效且去信任。

當然,上述方案只解決了DA 平臺本身的資料扣留問題,但在Layer2 的底層結構中,有能力發動資料扣留的不只DA 平台,還有排序器(Sequencer)。在B^2 Network 乃至大多數Layer2 的工作流程中,新增資料是由排序器Sequencer 產生的,它會把用戶端發來的交易匯總處理,附帶這些交易執行後的狀態變更結果,打包成批次(batch),再發送給充當DA 層的B^2 Hub 節點們。

如果排序器一開始產生的batch 就有問題,就還存在資料扣留的可能性,當然也包含其他形式的作惡場景。所以,B^2 的DA 網路(B^2 Hub) 收到排序器產生的Batch 後,會先對驗證Batch 的內容,有問題就拒收。可以說,B^2 Hub 不但扮演了類似Celestia 的DA 層,也扮演了鏈下的驗證層,有點類似CKB 在RGB++ 協定中的角色。

(不完整的B^2 Network 底層結構圖)

按照B^2 Network 最新的技術路線圖,B^2 Hub 在收到並驗證了Batch 後,只保留一段時間,過了這個視窗期,Batch 資料就會被過期淘汰,從B^2 Hub 節點本地刪除掉。為了解決類似EIP-4844 的資料淘汰及遺失問題,B^2 Network 設定了一組儲存節點,這些儲存節點會負責永存Batch 數據,這樣一來,任何人在任何時候,都可以在儲存網路中搜尋到自己需要的歷史資料。

不過,沒有人會平白無故的運行B^2 儲存節點,如果想讓更多人來運作儲存節點,增強網路的去信任程度,就要提供激勵機制;要提供激勵機制,就要先想辦法反作弊。例如,假如你提出了一套激勵機制,任何人在自己的設備本地存儲了數據,就可以獲得獎勵,可能有人在下載了數據後,又偷偷的把一部分數據刪掉,卻聲稱自己存儲的數據是完整的,這就是最常見的作弊方法。

Filecoin 透過名為PoRep 和PoSt 的證明協議,讓儲存節點向外界出示儲存證明,證明自己在給定時間段內的確完整的保存了資料。但這種儲存證明方案需要產生ZK 證明,且運算複雜度很高,對儲存節點的硬體設備會有較高要求,可能不是一個經濟成本上可行的方法。

在B^2 Network 的新版技術路線圖中,儲存節點會採用類似Arweave 的機制,需要爭奪出塊權來取得代幣誘因。如果儲存節點私自刪除了一些數據,則其成為下一個出塊者的機率會降低,而保留資料最多的節點,越有可能成功出塊,獲取到更多的獎勵。所以對於大多數儲存節點而言,還是保留完整的歷史資料集比較好。

當然,激勵的不只是儲存節點,還包括前面提到的B^2 Hub 節點,按照路線圖,B^2 Hub 會組成一個Permissionless 的POS 網絡,任何人只要質押了足夠多的Token,就可以成為B^2 Hub 或儲存網路中的一員,透過這種方式,B^2 Network 嘗試在鏈下打造去中心化的DA 平台及儲存平台,並在未來整合B^2 以外的比特幣Layer2 ,搭建通用的比特幣鏈下DA 層與資料儲存層。

ZK 與詐欺證明混用的狀態驗證方案

前面我們闡述了B^2 Network 的DA 解決方案,接下來我們將重點放在其狀態驗證方案。所謂的狀態驗證方案,就是指Layer2 如何確保自己的狀態轉換足夠「去信任」。

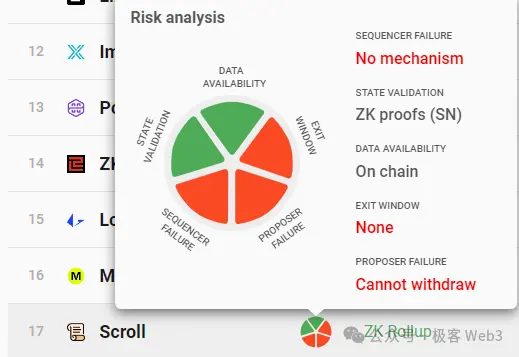

(L2BEAT 網站針對Scroll,評估出的五大安全指標,State Validation 是指狀態驗證方案)

前面我們曾提到,在B^2 Network 乃至大多數Layer2 的工作流程中,新增資料是由排序器Sequencer 產生的,它會把用戶端發來的交易匯總處理,附帶這些交易執行後的狀態變更結果,打包成批次(batch),發送給Layer2 網路中的其他節點,包括普通的Layer2 全節點,以及B^2 Hub 節點。

B^2 Hub 節點收到Batch 資料後,會解析其內容並做出驗證,這裡就包含了前面提到的「狀態驗證」。其實狀態驗證,就是驗證排序器產生的Batch 中,記錄的「交易執行後的狀態變化」是否正確。如果B^2 Hub 節點收到了包含錯誤狀態的Batch,會將其拒收。

其實,B^2 Hub 本質是一條POS 公鏈,會有出塊者和驗證人的分野。每隔一段時間,B^2 Hub 的出塊人會產生新的區塊,並傳播給其他節點(驗證人),這些區塊包含了排序器提交的Batch 資料。剩下的工作流程和前面提到的Celestia 有些許類似,有很多外部的節點,頻繁的向B^2 Hub 節點索取資料片段,在這個過程中,Batch 資料會被分發給很多節點設備,也包括前面提到的儲存網路。

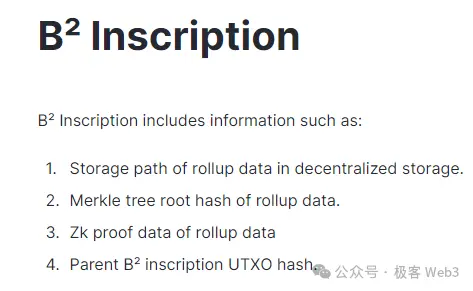

B^2 Hub 中存在名為Committer(承諾人)的可輪換角色,它會把Batch 的資料hash(其實是Merkle root),以及儲存索引,以銘文的形式提交到比特幣鏈上。只要你讀取到這個資料hash 和儲存索引,就有辦法在鏈下的DA 層/ 儲存層取得完整的資料。假設鏈下有N 個節點存放著Batch 數據,只要其中1 個節點願意對外提供數據,就能讓任何人取得到它需要的數據,這裡的信任假設是1/N。

當然,我們不難發現,在上述過程中,負責驗證Layer2 狀態轉換有效性的B^2 Hub,是獨立於比特幣主網的,只是一個鏈下的驗證層,所以這個時候,Layer2 的狀態驗證方案,在可靠性上無法等價於比特幣主網。

一般而言,ZK Rollup 可以完整的繼承Layer1 的安全性,但目前比特幣鏈上只支援一些極為簡單的計算,無法直接驗證ZK 證明,所以還沒有哪個Layer2 可以在安全模型上等價於以太坊的那種ZK Rollup,包括Citrea 和BOB 等。

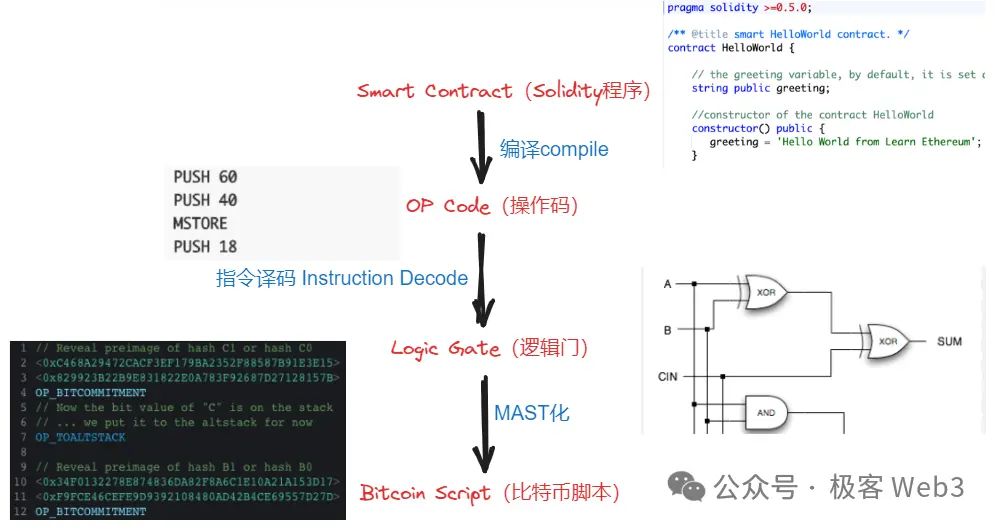

目前看來,「比較可行」的想法是BitVM 白皮書中所闡述的那樣,複雜的計算過程挪到比特幣鏈下,僅在必要時把某些簡單的計算挪到鏈上進行。例如驗證ZK 證明時產生的計算痕跡,可以公開,交由外界檢查。如果人們發現其中某個比較細微的計算步驟有問題,就可以在比特幣鏈上驗證這道「有爭議的計算」。這裡面需要用比特幣的腳本語言,模擬出EVM 等特殊虛擬機器的功能,消耗的工程量可能會非常龐大,但並不是不可行。

在B^2 Network 的技術方案中,排序器產生了新的Batch 後,會轉發給聚合器以及Prover,後者把Batch 的資料驗證過程ZK 化,生成ZK 證明,最終轉發給B^2 Hub 節點。 B^Hub 節點是EVM 相容的,透過Solidity 合約來驗證ZK Proof,這其中涉及的全部計算過程,會被拆分為非常底層的邏輯閘電路形態,這些邏輯閘電路又會以比特幣腳本語言的形式表達出來,全部提交至吞吐量足夠大的第三方DA 平台中。

如果人們對這些披露出來的ZK 驗證痕跡存在疑問,覺得某個小步驟有錯誤,就可以在比特幣鏈上進行「挑戰」,要求比特幣節點直接檢查這個有問題的步驟,並適當做出懲罰。

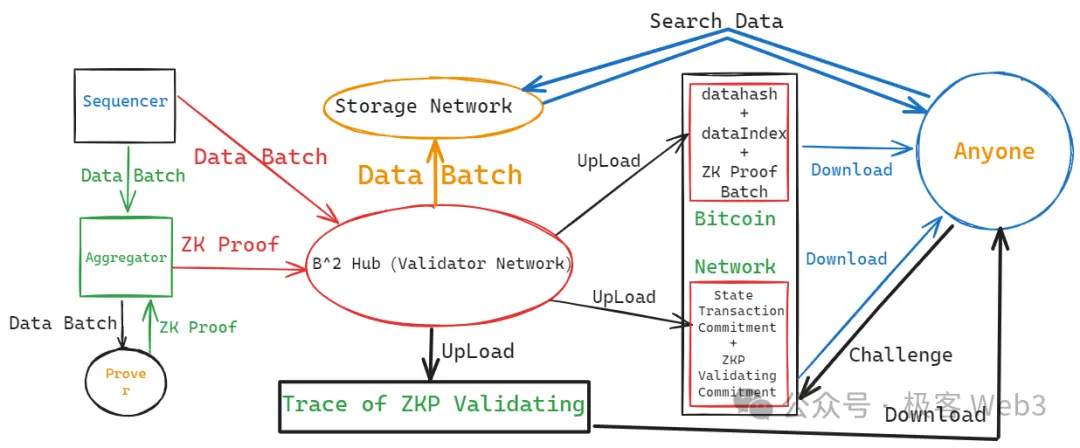

(B^2 Network 的整體結構圖,不包含資料採樣節點)

那麼是誰被懲罰呢?其實是Committer。在B^2 Network 的設定中,Committer 不但會把前面說的數據hash 發佈到比特幣鏈上,還要把ZK 證明的驗證「承諾」發佈到比特幣主網。透過比特幣Taproot 的一些設定,你可以隨時在比特幣鏈上,對Committer 發布的「ZK 證明驗證承諾」進行質疑和挑戰。

這裡解釋下什麼「承諾」(Commitment)。 「承諾」的含義在於,某些人聲稱,某些鏈下數據是準確無誤的,並在鏈上發布對應的聲明,這個聲明就是“承諾”,承諾值與特定的鏈下數據相綁定。在B^2 的方案中,如果有人認為Committer 發布的ZK 驗證承諾有問題,就可以進行挑戰。

或許有人會問,前面不是提到B^2 Hub 在收到Batch 後,會直接驗證其有效性嗎,這裡為何又要「多次一舉」的驗證ZK 證明?為什麼不直接把驗證Batch 的流程公開揭露,讓人們直接挑戰,非要引進ZK 證明幹嘛?這其實是為了把計算痕跡壓縮的夠小,如果直接把驗證Layer2 交易、產生狀態變更的計算流程,全部以邏輯閘電路和比特幣腳本的形式公開披露,將會產生極大的資料尺寸。而ZK 化之後,可以把資料尺寸大大壓縮後,再發佈出去。

這裡大致總結下B^2 的工作流程:

- B^2 的排序器Sequencer 負責產生新的Layer2 區塊,並將多個區塊聚合為data batch(資料批次)。 data batch 會被送給聚合器Aggregator,以及B^Hub 網路中的Validator 節點。

- 聚合器會將data Batch,傳送給Prover 節點,讓後者產生對應的零知識證明。 ZK 證明隨後會被發送給B^2 的DA 與驗證者網路(B^2Hub)。

- B^2Hub 節點會驗證聚合器發來的ZK Proof,能否和Sequencer 發過來的Batch 相對應。若兩者可以對應,則通過驗證。透過驗證的Batch,其資料hash 與儲存索引,會被某個指定的B^Hub 節點(稱為Committer)傳送至比特幣鏈上。

- B^Hub 節點會將其驗證ZK Proof 的整個計算過程公開披露,將計算過程的Commitment 發送到比特幣鏈上,允許任何人對其進行挑戰。如果挑戰成功,則發布Commitment 的B^Hub 節點將受到經濟懲罰(它在比特幣鏈上的UTXO 將被解鎖並轉移給挑戰者)

B^2 Network 的這種狀態驗證方案,一面引入了ZK,一面採用了欺詐證明,實際上屬於混合型的狀態驗證方式。只要鏈下存在至少1 個誠實的節點,在偵測出錯誤後願意發起挑戰,就可以保證B^2 Network 的狀態轉換是沒有問題的。

按照西方比特幣社群成員的看法,未來比特幣主網可能會進行適當的分叉,以支援更多的運算功能,也許在未來,直接在比特幣鏈上驗證ZK 證明會成為現實,屆時將為整個比特幣Layer2 帶來新的範式級變革。而B^2 Hub 作為一個通用的DA 層與驗證層,不但可以作為B^2 Network 的專用模組,還可以賦能其他比特幣二層,在比特幣Layer2 的大爭之世中,鏈下功能拓展層必將越來越重要,而B^Hub 和BTCKB 的湧現,或許才剛揭開這些功能拓展層的冰山一角。