Meta聯合英偉達正式推出了一個全新的超算。

編輯:好困袁榭

從「黑客帝國」到「西部世界」,無數文藝作品都展望了跑在超級計算機上的超級AI,控制虛擬現實世界、統治地球的未來。 2022年1月25日,Meta公佈的AI超級計算機RSC,似乎正在往這個方向邁去。

1月25日,Meta聯合英偉達正式推出了一個全新的超算——「人工智能研究超級集群」( AI Research SuperCluster,縮寫RSC)。

Meta的計劃也很「樸素」,首先把CV、NLP、語音識別等技術所需的模型都做到最大,參數量差不多「數万億」個吧。

這些模型可以在數百種不同的語言中工作;無縫分析文本、圖像和視頻;開發新的增強現實工具等等。

然後再構建全新的人工智能係統。例如,為使用不同語言的人群提供實時語音翻譯,這樣大家就可以就研究項目無縫協作,或者一起暢玩AR增強現實遊戲。

最終,RSC將和相關的AI工作一起,為構建「元宇宙」鋪平道路。

值得一提的是,RSC從論文靈感到實物只用了18個月的時間。

要整就整最大的

自2013年Facebook正式設立人工智能實驗室開始,Meta在AI方面取得了很多重大進展。

諸如從大量未標註的樣本中學習的自監督學習,以及讓AI模型能夠進行更有效推理的Transformer。

不過,想要發揮自監督學習和基於Transformer的模型的優勢,無論是視覺、語音、語言,還是關鍵信息的識別,都需要訓練越來越大、越來越複雜的模型。

計算機視覺需要以更高的數據採樣率來處理更大、更長的視頻。語音識別需要在有大量背景噪音的挑戰性場景中也能很好地工作,如聚會或音樂會。 NLP需要理解更多的語言、方言和口音。

而其他領域的進步,包括機器人技術、具身人工智能和多模態人工智能,將能夠完成現實世界中的任務。

為此,Meta在2017年打造了第一代超算。其中,一個集群中擁有22000個英偉達V100 Tensor Core GPU,每天執行35000個訓練作業。

2020年初,Meta決定從0開始設計一個新的超算,進而在大到一個Exabyte的數據集上訓練出超過一萬億個參數的模型,換句話說,這個數據量相當於36000年的高質量視頻。

反正神經網絡模型中的參數數量也一直在猛增,例如自然語言處理器GPT-3有1750億個參數,超級計算機跑超級神經網絡AI,沒毛病。

具體參數

RSC由760個英偉達DGX A100系統構成運算節點,總共有6080個英偉達A100 GPU在Quantum InfiniBand網絡上連接,達到每秒1895千萬億次運算的TF32程度性能。

RSC的存儲層有175PB的Pure Storage FlashArray,46PB的Penguin Computing Altus系統的緩存存儲,以及10PB的Pure Storage FlashBlade。

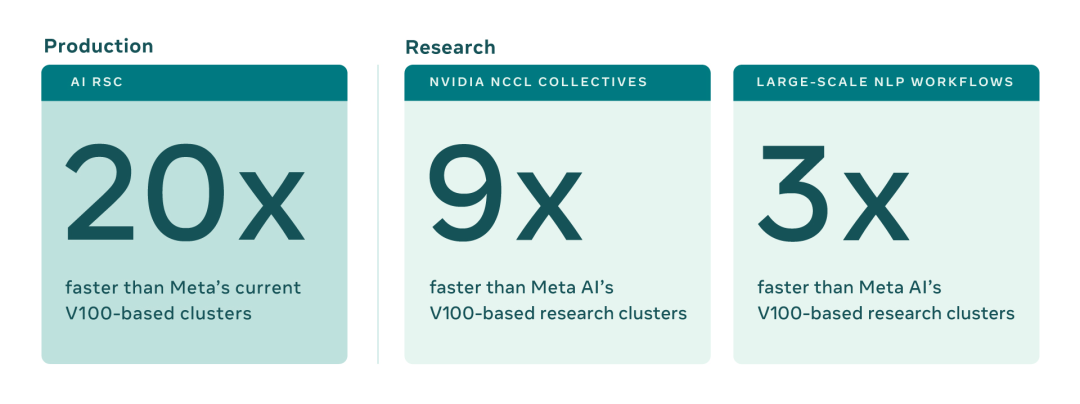

20倍性能增益

Meta的第一代超算設計於2017年,其中一個集群中擁有22000個英偉達V100 Tensor Core GPU,每天執行35000個訓練作業。

RSC的早期基準測試表明,較於第一代超算,它運行計算機視覺工作流程的速度提高了20倍,運行英偉達集體通信庫(NCCL)的速度提高了9倍多,訓練大規模NLP模型的速度提高了3倍。

這意味著一個擁有數百億個參數的模型可以在三週內完成訓練,而之前是九週。

在2022年度的第二階段,RSC的GPU數量將從6080個增加到16000個,使AI的訓練性能提高2.5倍以上,成為世界上最快的人工智能超級計算機。

在混合精度方面,RSC將達到驚人的每秒5百億億次運算。存儲系統則會擴容到Exabyte(10億GB)級別,並具有16TB/s的目標傳輸帶寬。

此外,InfiniBand結構將支持16000個端口,採用雙層拓撲結構且沒有超佔比。

作為對照物,在最新一輪MLPerf神經網絡訓練基準測試中,最大的系統是Nvidia部署的4320-GPU系統。

其可在不到一分鐘的時間內訓練自然語言處理器BERT。然而,與Meta的RSC將使用的數万億個參數相比,BERT只有1.1億個參數。

真是小巫見大巫了。

超算的優勢

負責RSC的Meta項目經理凱文·李稱,超級計算機的巨型規模在多方面都很有必要。

首先,Meta公司本身的基礎業務就帶來了不間斷處理海量信息的需求,這對數據處理性能的規模下限有很高要求。

其次,AI研發項目使用的數據量也有下限要求,因為數據集內容越複雜越整全,研究結果就越好。

訓練AI模型的算力下限,遠高於運行AI模型的算力下限。這就是你的智能手機在掃臉認證時不需要連上堆滿服務器的數據中心的原因。

再次,所有這些基礎設施的管理是很大的挑戰。所以大規模帶來的管理去碎片化,簡化了管理工作,提高了管理工作、耗能、佔地等任務的效率。

元宇宙:請加大力度

Meta在公開宣布超算時,並沒有忘記公司最近的元宇宙主旋律。

2021年10月,Facebook正式宣布改名,META!

當蒙在矽谷總部標誌牌上的「豎起大拇指」被揭掉的那一刻起,「元宇宙新紀元」也正式拉開帷幕。

Meta老闆馬克·扎克伯格週一在自己的Facebook帖文中寫道:「我們為元宇宙構建的體驗需要巨大的算力(每秒數万億次操作!),RSC將啟用新的AI模型,可以從數万億個示例中研究,理解數百種語言等等。」

Meta公司也多次在消息公佈文章中表示:開發超算的目的之一是「幫助實現公司的元宇宙願景

」。用超算跑AI也是因為「AI驅動的應用和產品將在元宇宙中發揮重要作用。」

Meta稱:「我們希望算力的躍階提升不僅能幫助我們為現有服務創建更精確的人工智能模型,同時能夠實現全新的用戶體驗,尤其是在元宇宙之中……正在幫我們創造為元宇宙提供動力、並推動更廣泛的人工智能社區前進的基礎技術。」

RSC能推動的具體產品與落地場景也不乏展望。除了多次提到的「審查海量內容」和「為包含數百種語言的人群實時翻譯語音」外,還有Facebook與Instagram正在開發的增強現實設備也可以從中獲益。

正如馬克·扎克伯格提到自家的data2vec模型所說,高性能AI與AR的結合將提升元宇宙的用戶體驗:「高性能的AI助手最終將內置於AR眼鏡中。例如當用戶做飯時少放調料、爐火開太大等等時,AR眼鏡中的AI助手能及時彈窗/語音提示,協助用戶完成複雜任務。」

如何造一個AI超算

設計、建造RSC這類項目,並不只消考慮性能參數,而是要用當今最好的方案在盡可能大的範圍內實現這些性能。

與外界夥伴協作

所有這些基礎設施必須非常可靠耐用,因為Meta公司估計有些實驗可以運行數週,並需要成千上萬的GPU。而且使用RSC的整個體驗必須對研究人員友好,以便研究團隊可以輕鬆地探索廣泛的人工智能模型。

這一目標實現的很大一部分,是Meta與長期合作夥伴的協力結果,他們也都在2017年幫助設計了Meta的第一代AI基礎設施。

SGH旗下的企鵝計算公司是Meta的架構和管理服務合作夥伴,它與Meta的運營團隊合作,進行硬件集成以部署集群,並幫助建立控制平面的主要部分。

Pure Storage為Meta提供了強大的、可擴展的存儲解決方案。

英偉達為Meta提供了以尖端系統、GPU和InfiniBand結構為特色的AI計算技術,以及用於集群的NCCL等軟件棧組件。

開發中應對時勢變故

但在RSC的發展過程中還出現了其他意想不到的挑戰–即新冠大流行。

新冠讓RSC初始時成為完全的遠程項目,項目團隊得用大約一年半的時間裡將其從一個簡單的共享文件變成了一個正常運作的工作集群。

新冠和全行業的晶圓供應短缺還帶來了供應鏈問題,使得從芯片、光學組件到GPU,甚至建材都難以獲得–所有這些都必須按照新的安全規程進行運輸。

為了有效地建立這個集群,Meta的項目團隊不得不從頭開始設計,創造了許多全新的Meta獨有流程,並在此過程中重新思考以前的先例。

比如Meta必須圍繞其數據中心設計編寫新的規則–包括其冷卻、電源、機架佈局、佈線和網絡(包括一個全新的控制界面),以及其他重要的考量因素。

Meta必須確保公司內的所有團隊,從建築到硬件到軟件和人工智能,都與合作夥伴步調一致地工作。

為超算開發的AIRStore

除了核心系統本身,AI超級計算機還需要一個強大的存儲解決方案:一個能夠從一個超字節規模的存儲系統提供TB級帶寬的解決方案。

為了滿足人工智能訓練日益增長的帶寬和容量需求,Meta從頭開始開發了一個存儲服務–人工智能研究商店(AIRStore)。

為了優化人工智能模型,AIRStore採用了一個新的數據準備階段,對用於訓練的數據集進行預處理。一旦準備工作完成,準備好的數據集可用於多次訓練,直至過期。

AIRStore還優化了數據傳輸,使Meta數據中心間主幹網的跨區域流量降至最低。

保障數據安全

幾十年來高性能計算一直都在解決規模上的問題,然而安全和隱私的控制也尤為重要。

為了滿足隱私和安全要求,數據從存儲系統到GPU的整個鏈路都是端到端加密的,直到訓練前才會被解密。而且在導入RSC之前,數據都必須經過隱私審查程序,以保證被正確地匿名化。

此外,RSC與互聯網也是隔離,沒有直接的入站或出站連接,流量只能來自Meta的生產數據中心。

Meta的RSC可以說是第一次在這樣的規模下去解決性能、可靠性、安全性和隱私問題。

最後,一旦完全啟用,Meta的RSC超級電腦將是英偉達DGX A100系統的最大規模客制化安裝項目。

參考資料:

https://ai.facebook.com/blog/ai-rsc

https://blogs.nvidia.com/blog/2022/01/24/meta-ai-supercomputer-dgx/

Facebook Parent Company Meta Builds Massive AI Supercomputer

展開全文打開碳鏈價值APP 查看更多精彩資訊