3月22日,玩家和AI從業者又愛又恨的老黃帶著他的新“核彈”來了。可惜這顆新“核彈”與玩家關係不大,主要面向企業和工業市場。估計與玩家相關的RTX 40系列最早要到9月份才會有消息。

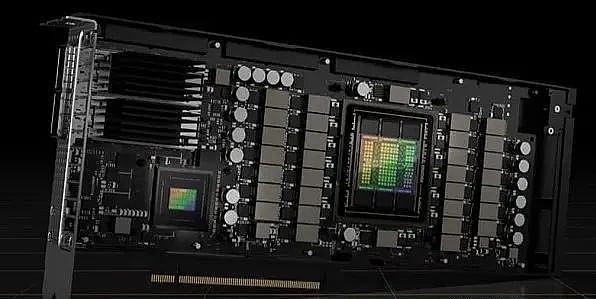

好了,廢話不多說,看看老黃這次帶出了什麼樣的“大寶貝”。首先是A100顯卡的繼任者。新一代計算卡H100登場。 H100採用全新的Hopper架構和台積電最新的4nm工藝。與上一代A100相比,各方面的參數都有明顯提升。

英偉達的超級服務器芯片Grace 也再次曝光。與上次給出的數據相比,本次曝光的格雷斯芯片的性能有了驚人的提升。根據發布會的描述,英偉達似乎和蘋果走在了同一條路上。使用更多芯片來組裝處理器。

除了硬件產品的曝光和發布,NVIDIA還在軟件領域帶來了很多新的東西,比如Omniverse Cloud,主打雲端協同,讓多個用戶直接參與同一個媒體文件的編輯和渲染在雲端。

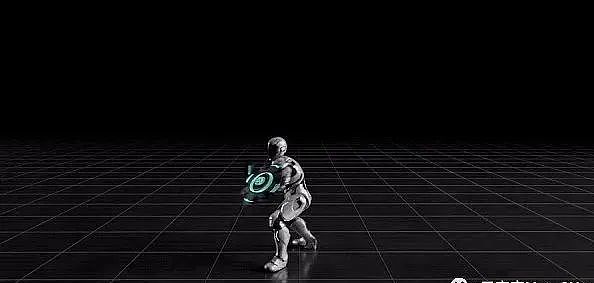

此外,NVIDIA還展示了多個基於虛擬現實環境的工業和交通仿真案例,以及一套AI驅動的虛擬角色系統。系統可以通過深度學習進行動作訓練,訓練後無需額外的骨骼動作設計。操作可以根據指令做出相應的動作。這不僅是AI從業者的狂喜,也是電影和遊戲從業者的狂喜。

不得不說,老黃這次帶來了很多東西,每一個都能給AI等行業的發展帶來明顯的變化。讓我們來詳細看看英偉達發布的內容。

H100 和Grace

從去年開始,就有消息稱英偉達今年將發布新一代計算卡,並將採用全新的Hopper架構。目前消息是準確的,不過大家都猜測新一代計算卡會採用台積電的5nm工藝,但現在看來,英偉達一步步選擇了採用最新的4nm工藝。雖然本質上是5nm+,但就是功耗。它具有更好的性能,還可以集成更高的晶體管。

其實從H100的核心規格來看,不難理解為什麼英偉達最終選擇了4nm,晶體管集成度高達800億,比上一代A100多了260億。核心數增加到16896,這是世界上核心數最多的芯片核心,也是上一代100的2.5倍。

誇張的內核參數提升帶來的性能提升也是極其誇張的。根據英偉達官方給出的數據,H100的浮點計算和張量核心計算能力將比上一代提升至少3倍,FP32最高可達60 teraflops/秒。 ,而上一代A100 為19.5 teraflops。

H100也將率先支持PCIe 5.0和HBM3,讓內存帶寬達到驚人的3TB/s。老黃說,目前全球網絡流量只有20台H100可以處理。雖然聽上去有些誇張,但確實反映了H100誇大的性能參數。

強大的性能也伴隨著誇張的功耗。 NVIDIA給出的H100功耗高達700W(真正的“核彈”顯卡),相比上一代A100。功耗只有400W,換來的卻是兩倍的功耗。 3倍的性能提升整體來說不算虧。

H100還針對AI訓練中用到的模型等進行針對性優化,配備Transformer優化引擎,使大型模型的訓練速度可以提高到原來的6倍,大大減少了大型模型所需的訓練人工智能模型時間,這個功能也呼應了下面將要討論的AI分身系統。

在NVIDIA 給出的測試數據中,訓練一個1750 億參數的GPT-3 模型將時間從原來的一周縮短到僅19 小時,一個3950 億參數的Transforme 模型只需21 小時即可完成。訓練,效率提升近9倍。

雖然參數看起來很不錯,但實際表現還有待後續實際測試結果來揭曉。至少從RTX 30系列和A100的體驗來看,最終的實際性能提升可能在2倍到2.5倍之間。 ,實現3倍的可能性不大,但即使只有2倍,也已經相當不錯了,至少在AI方面,已經徹底碾壓了AMD的計算卡。

此外,H100還引入了NVIDIA最新的NVIDIA NVLink第四代互連技術,可以進一步提升多GPU串連的效率。在NVIDIA給出的數據中,串聯後的I/O帶寬可以擴展至900GB/s,比上一代提升50%。

再來看看英偉達的新“玩具”Grace,這是英偉達為服務器業務準備的超級服務器芯片。系列產品。 Grace 芯片採用了最新的Arm V9 架構,Nvidia 以此為基準構建了兩款超級芯片——Grace Hopper 和Grace CPU 超級芯片。

其中,Grace Hopper 由一個Grace CPU 和一個採用Hopper 架構的GPU 組成。兩者將組成一個完整的計算系統。只需要一個芯片就可以構建一個強大的計算服務器。芯片串聯起來形成更大的計算陣列。

Grace CPU超級芯片由兩顆Grace CPU組成,它們通過NVIDIA NVLink-C2C技術互連,形成一個內置144個Arm核心和1TB/s內存帶寬的巨型芯片(Grace CPU Ultra)。

說實話,英偉達的Grace CPU 超級芯片很難不讓人聯想到蘋果在春季發布會上發布的M1 Ultra。它同樣基於Arm 架構,同樣由兩顆芯片組成。它也有誇張的特點。內存帶寬和性能。

顯然,芯片互連與組裝技術已成為行業趨勢之一,AMD也透露類似技術的CPU正在研發中,最早將於2023年與大家見面。只能說性能發展單個芯片現在正在接近極限。如果想要有更大的提升,可能不得不使用類似的互連技術進行芯片堆疊。

不過,Grace CPU 超級芯片的功耗並不低。 NVIDIA官方給出的數據是500W,已經遠超傳統x86架構CPU。當然,考慮到格雷斯CPU超級芯片的誇張表現:SPECrate跑分740分,比第二名高出60%,這樣的功耗也不是不能接受的。

顯然,在Arm 服務器領域,英偉達的野心非常大。

英偉達的虛擬世界

除了一堆高性能硬件,NVIDIA這次還展示了很多軟件演示案例,包括使用H100等硬件模擬虛擬現實環境進行各種測試和模擬。在英偉達的演示中,未來企業可以通過強大的英偉達硬件搭建逼真的虛擬測試環境,在其中測試自動駕駛、智能工廠運營等。

通過使用虛擬測試環境,研究人員可以更輕鬆地測試自動駕駛在面對各種突發事件時的反饋,並在測試過程中直接定位問題,降低整體測試成本。此外,可以構建1:1的“數字工廠”,提前模擬運營,尋找提高效率,發現可能出現的問題,降低工廠正式運營後出現問題的概率。

英偉達將這組應用稱為“數字孿生”,可以大大減少自動化工廠和自動駕駛方面的研究和測試投入。

Omniverse Cloud 是NVIDIA 推出的全新雲創建服務。通過Omniverse Cloud,用戶可以隨時隨地訪問和編輯大型3D場景,無需等待大量數據的傳輸,還可以讓用戶直接在線協作構建3D模型。

過去,3D模型和3D場景的協同構建需要在服務器上進行。 Omniverse Cloud上線後,相關創作者可以通過任何支持Omniverse Cloud的終端直接訪問協作空間並參與其中。大大提高了創作者的反應速度和工作自由度。

此外,NVIDIA還為創作者準備了第二個驚喜,一套AI驅動的虛擬角色系統,可以讓AI在短時間內完成訓練,學習各種指令對應的動作。比如一個簡單的砍殺動作,在正常的製作過程中,動作架構師首先需要一步步調整動作骨架(俗稱K幀),然後放到場景中進行測試。整個過程需要很多時間。並且每個不同的動作都需要重新調試。

借助這套AI虛擬角色系統,當你想讓虛擬模型做出斬擊動作時,只需要一個命令,AI就會從學習到的動作中找出關聯的動作並自動運行,直接保存儲蓄。大量的時間和人力,對於遊戲開發者和視覺特效創作者來說,這個系統可以讓他們將更多的精力集中在其他地方。

雖然NVIDIA 的發布會並沒有過多提及元宇宙,但從硬件到軟件,都是未來構建元宇宙的基礎。元宇宙目前無法成為現實的主要原因有兩個。一是硬件性能無法滿足我們的需求,二是軟件領域還不夠成熟,無法提供實時的真實環境模擬。技術的基礎。

在此之前,我們首先需要的是更強大的計算硬件和更智能的人工智能係統。 Nvidia 的H100,虛擬現實環境和AI 虛擬角色系統的出現,將使我們離真正的元宇宙更近一步。