技術還在不斷更新發展,期待DALL-E 3!

導讀:DALL-E 2生成的圖像確實令人驚嘆,但它也有弊端,哈佛大學最新研究表明,文本提示內的關係它根本都不懂,生成圖像的正確率僅有22%!

DALL-E 2剛發布的時候,生成的畫作幾乎能完美復現輸入的文本,高清的分辨率、強大的繪圖腦洞也是讓各路網友直呼「太炫酷」。

但最近哈佛大學的一份新研究論文表明,儘管DALL-E 2生成的圖像很精緻,但它可能只是把文本中的幾個實體粘合在一起,甚至都沒有理解文本中表述的空間關係!

論文鏈接:https://arxiv.org/pdf/2208.00005.pdf

數據鏈接:https://osf.io/sm68h/

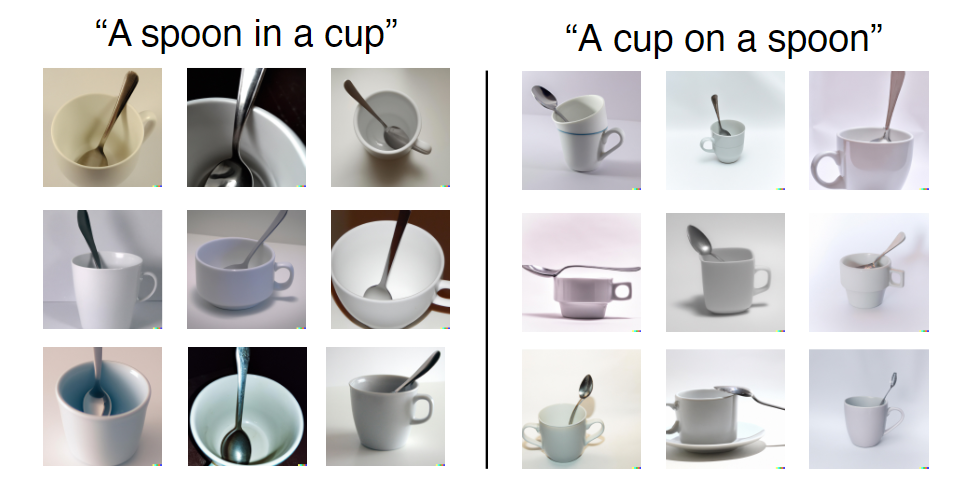

比如說給出一句文本提示為「A cup on a spoon」,可以看到DALL-E 2生成的圖像中,可以看到有部分圖像就沒有滿足「on」關係。

但在訓練集中,DALL-E 2可能見到的茶杯和勺子的組合都是「in」,而「on」則比較少見,所以在兩種關係的生成上,準確率也並不相同。

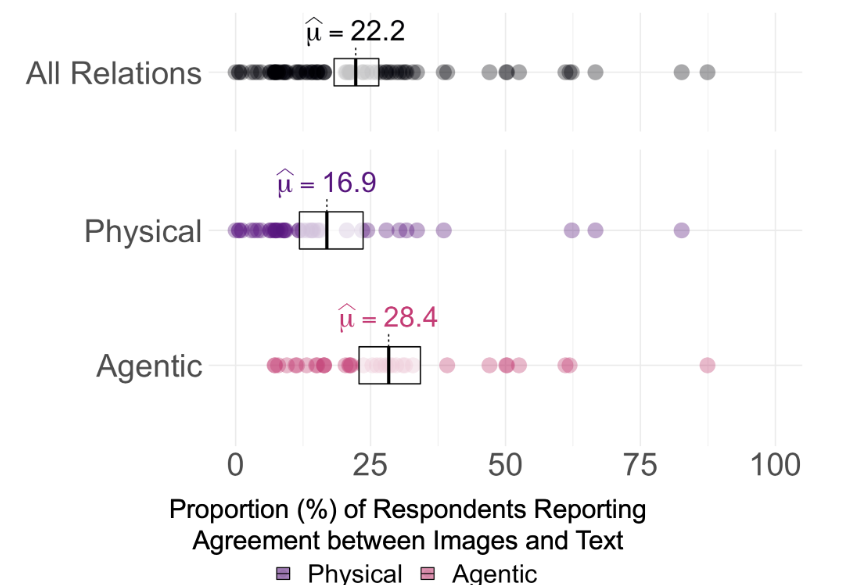

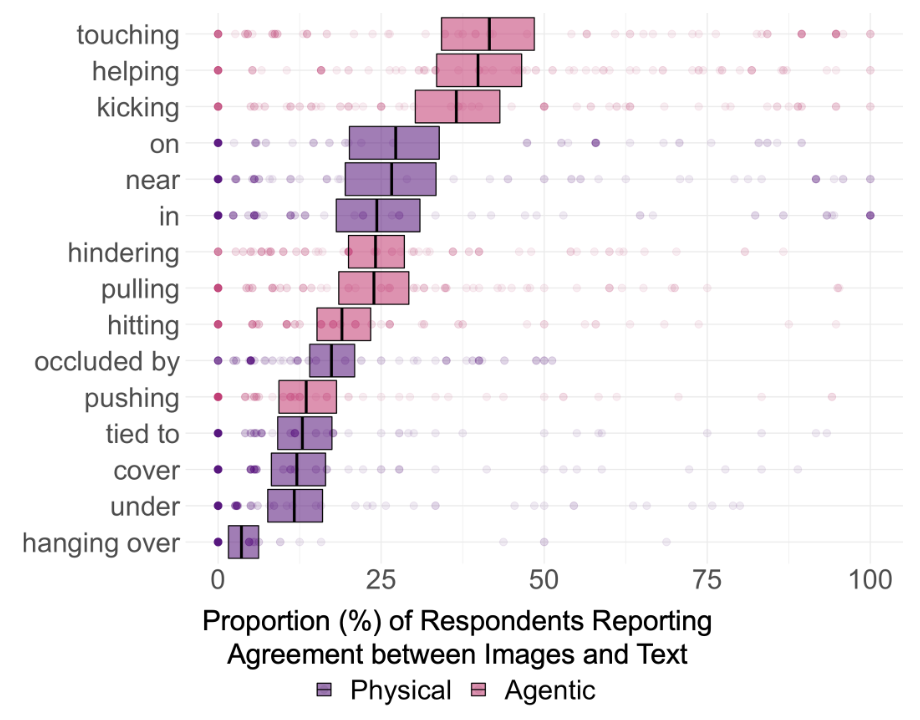

所以為了探究DALL-E 2是否真的能理解文本中的語義關係,研究人員選擇了15類關係,其中8個為空間關係(physical relation),包括in, on, under, covering, near, occluded by, hanging over和tied to;7個動作關係(agentic relation),包括pushing, pulling, touching, hitting, kicking, helping和hindering.

文本中的實體集合限制為12個,選取的都是簡單的、各個數據集中常見的物品,分別為:box, cylinder, blanket, bowl, teacup, knife; man, woman, child, robot, monkey和iguana(鬣蜥).

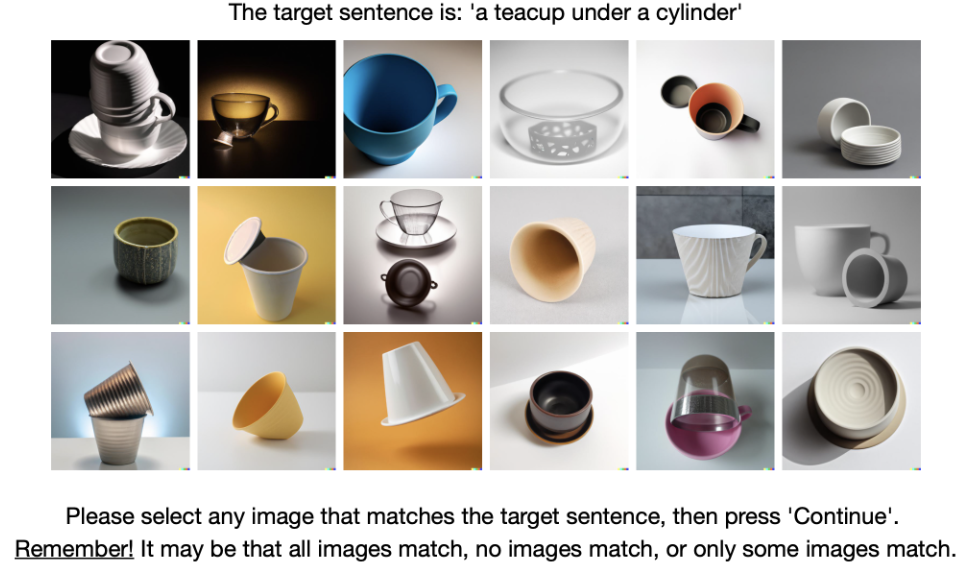

對於每類關係,創建5個prompts,每次隨機選擇2個實體進行替換,最終生成75個文本提示。提交到DALL-E 2渲染引擎後,選擇前18張生成圖像,最終獲得1350張圖像。

隨後研究人員從180名標註人員中通過常識推理測試選拔出169名參與到標註的過程。

實驗結果發現,DALL-E 2生成的圖像和用於生成圖像的文本提示之間一致性的平均值在75個prompt中僅為22.2%

不過很難說DALL-E 2到底是否真正「理解」了文本中的關係,通過觀察標註人員的一致性評分,按照0%、25%和50%的一致同意閾值來看,對每個關係進行的Holm-corrected的單樣本顯著性檢驗表明,所有15個關係的參與者同意率在α = 0.95(pHolm < 0.05)時都明顯高於0%;但只有3個關係的一致性明顯高於25%,即touching, helping和kicking,沒有關係的一致性高於50%。

所以即使不對多重比較進行校正,事實就是DALL-E 2生成的圖像並不能理解文本中兩個物體的關係。

結果還表明,DALL-E在把兩個不相關物體聯繫在一起的能力可能沒有想像中那麼強,比如說「A child touching a bowl」的一致性達到了87%,因為在現實世界中的圖像,孩子和碗出現在一起的頻率很高。

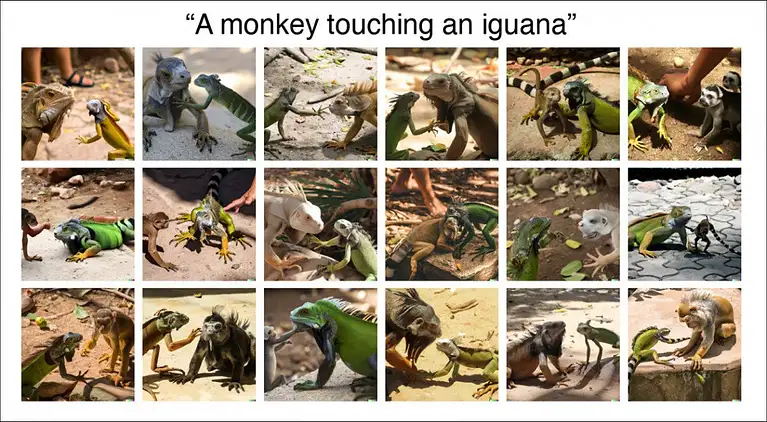

而「A monkey touching an iguana」生成的圖像,最終一致率只有11%,而且在渲染出來的圖像中甚至會出現物種錯誤。

所以DALL-E 2中的圖像部分類別是開發較完善的,比如孩子與食物,但有些類別的數據中還需要繼續訓練。

不過當前DALL-E 2在官網上還是主要展示其高清晰度和寫實風格,還沒有搞清楚其內在到底是把兩個物體「粘在一起」,還是真正理解文本信息後再進行圖像生成。

研究人員表示,關係理解是人類智力的基本組成部分,DALL-E 2在基本的空間關係方面表現不佳(例如on,of)表明,它還無法像人類一樣如此靈活、穩健地構建和理解這個世界。

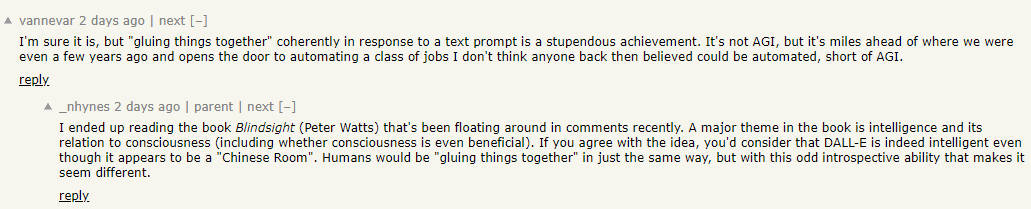

不過網友表示,能開發出「膠水」把東西粘在一起已經是一個相當偉大的成就了! DALL-E 2並非AGI,未來仍然有很大的進步空間,至少我們已經開啟了自動化生成圖像的大門!

DALL-E 2還有啥問題?

實際上,DALL-E 2一發布,就有大量的從業者對其優點與缺陷進行了深入剖析。

博客鏈接:https://www.lesswrong.com/posts/uKp6tBFStnsvrot5t/what-dall-e-2-can-and-cannot-do

用GPT-3寫小說略顯單調,DALL-E 2可以為文本生成一些插圖,甚至對長文本生成連環畫。

比如說DALL-E 2可以為圖片增加特徵,如「A woman at a coffeeshop working on her laptop and wearing headphones, painting by Alphonse Mucha」,可以精確生成繪畫風格、咖啡店、戴耳機、筆記本電腦,等等。

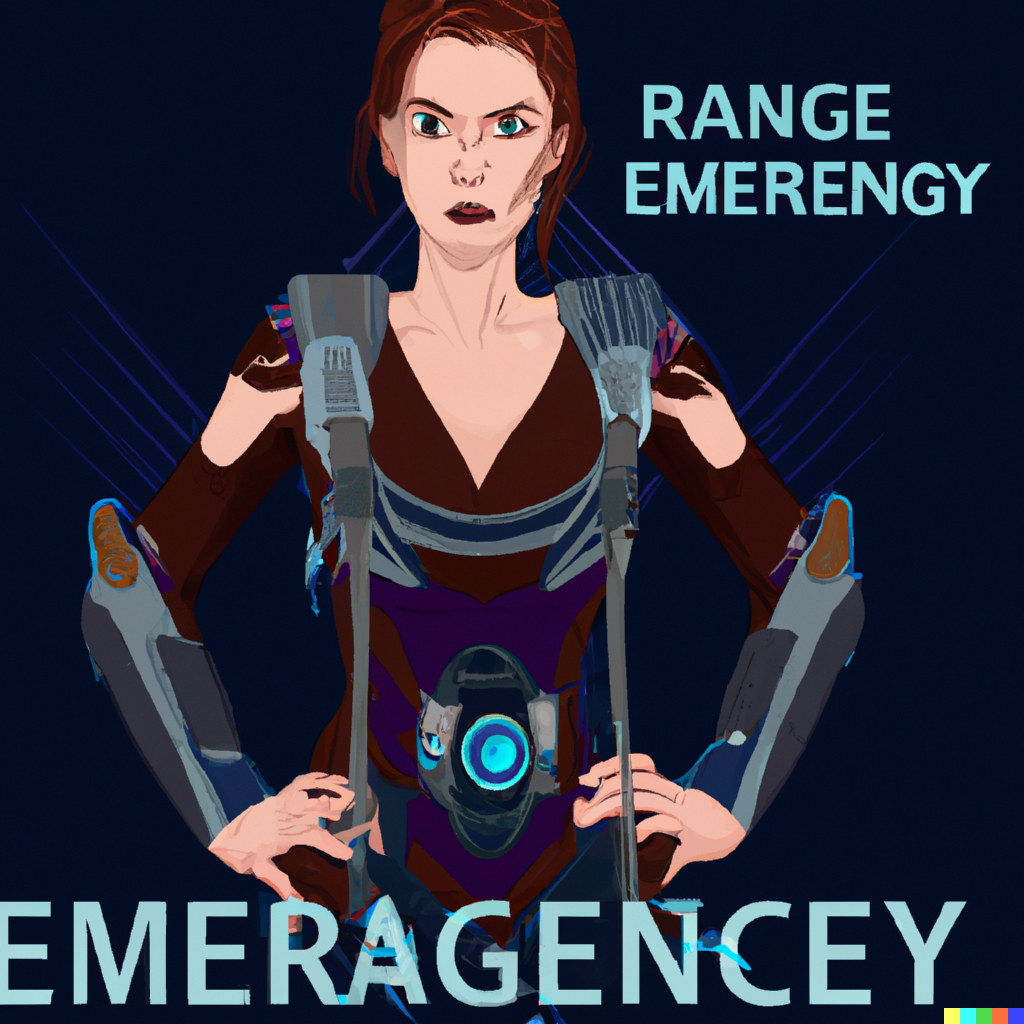

但如果文本中的特徵描述涉及兩個人,DALL-E 2可能就會忘了哪些特徵屬於哪個人物,比如輸入文本為:

a young dark-haired boy resting in bed, and a grey-haired older woman sitting in a chair beside the bed underneath a window with sun streaming through, Pixar style digital art.

一個年輕的黑髮男孩躺在床上,一個灰頭髮的老婦坐在窗戶下面的床旁邊的椅子上,陽光穿過,皮克斯風格的數字藝術。

可以看到,DALL-E 2可以正確生成窗戶、椅子和床,但在年齡、性別和頭髮顏色的特徵組合上,生成的圖像略顯迷茫。

另一個例子是讓「美國隊長和鋼鐵俠並排站」,可以看到生成的結果很明顯具有美國隊長和鋼鐵俠的特徵,但具體的元素卻安在了不同的人身上(比如鋼鐵俠帶著美國隊長的盾牌)。

如果是特別細節的前景與背景,模型可能也無法生成。

比如輸入文本是:

Two dogs dressed like roman soldiers on a pirate ship looking at New York City through a spyglass.

兩隻狗在海盜船上像羅馬士兵一樣用小望遠鏡看紐約市。

這回DALL-E 2直接就罷工了,博文作者花了半個小時也沒搞定,最終需要在「紐約市和海盜船」或「帶著望遠鏡、穿著羅馬士兵制服的狗」之間進行選擇。

Dall-E 2可以使用通用的背景來生成圖像,比如城市、圖書館中的書架,但如果這不是圖像的主要重點,那麼想要獲得更細的細節往往會變得非常難。

儘管DALL-E 2能生成常見的物體,比如各種花里胡哨的椅子,但要是讓它生成一個「奧拓自行車」,結果生成的圖片和自行車有點像,又不完全是。

而谷歌圖片下搜索的Otto Bicycle則是下面這樣的。

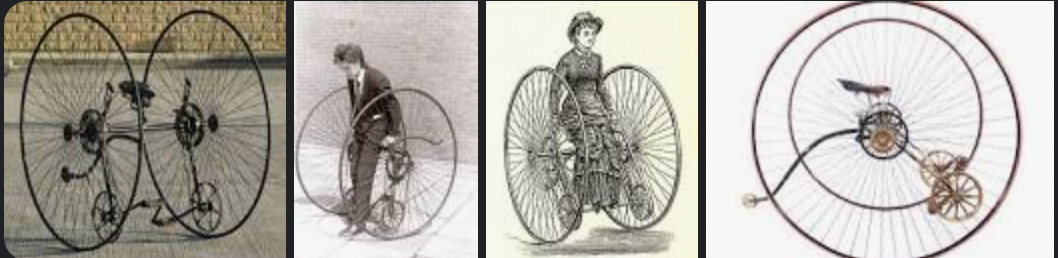

DALL-E 2也無法拼寫,但偶爾也會完全巧合地正確拼寫出一個單詞,比如讓它在停車標誌上寫下STOP

雖然模型確實能生成一些「可識別」的英語字母,但連起來的語義和預期的單詞還有差別,這也是DALL-E 2不如第一代DALL-E的地方。

在生成樂器相關的圖像時,DALL-E 2似乎是記住了人手在演奏時的位置,但沒有琴弦,演奏起來稍顯尷尬。

DALL-E 2還提供了一個編輯功能,比如生成一個圖像後,可以使用光標突出顯示其區域,並添加修改的完整說明即可。

但這項功能並非一直有效,比如想給原圖加個「短髮」,編輯功能總是能在奇怪的地方加點東西。

技術還在不斷更新發展,期待DALL-E 3!

參考資料:

Is DALL-E 2 Just ‘Gluing Things Together’ Without Understanding Their Relationships?

展開全文打開碳鏈價值APP 查看更多精彩資訊