圍繞OpenAI推出的第二代DALL-E 2系統的討論一直處於兩極分化的狀態,甚至在其推出了幾個月後依舊如此。

有用戶認為這是一項可以重新定義藝術的突破性創新,而批評者則將其視為人工智能圖像生成器給創意產業帶來厄運的開始。

然而毫無疑問的是,DALL-E 2為我們創造和消費藝術開闢了新的可能性和挑戰。本文詳細介紹了AI圖像生成器DALL-E 2的用法和缺點。

什麼是DALL-E 2?

DALL-E 2是一款人工智能圖像生成器,它可以根據自然語言的文本描述創建圖像和藝術形式。換句話說,它是一個根據文本生成圖像的人工智能係統。

2021年1月,OpenAI推出了DALL-E模型,DALL-E 2是其升級版。 “DALL-E”這個名字源於西班牙著名藝術家Salvador Dalí和廣受歡迎的皮克斯動畫機器人“Wall-E”的組合。

2022年7月,DALL-E 2進入測試階段,可供白名單中的用戶使用。同年9月28日,OpenAI取消了白名單的要求,推出了任何人都可以訪問並且使用的開放測試版。

與最初的DALL-E一樣,DALL-E 2也是一種語言生成模型,它使用文本提示來創建原始圖像。

儘管和之前DALL-E具有的120億個參數的模型不同,DALL-E僅僅具有大約35億個參數,但DALL-E 2生成的圖像分辨率是DALL-E的四倍,這是一次令人印象深刻的升級。同時,DALL-E 2在真實感和字幕匹配方面似乎也做得更好。

如何使用DALL-E 2?

聽起來,DALL-E 2很有未來感,可能會讓新用戶望而生畏,但它使用起來非常簡單。我們不進行詳細介紹,僅通過迷你教程為大家提供快速概覽。

首先,登陸DALL-E 2的官網並創建一個帳戶,如果您此前已經擁有OpenAI的帳戶,登陸即可。需要注意的是,系統會要求您提供電子郵件和電話號碼以進行驗證。

一旦帳戶準備就緒,我們就可以開始生成圖像。用戶最多提供400個字符的描述性文本,AI藝術生成器將對其進行處理。根據測試,我們可以從文本提示中得到許多原創且有趣的結果。

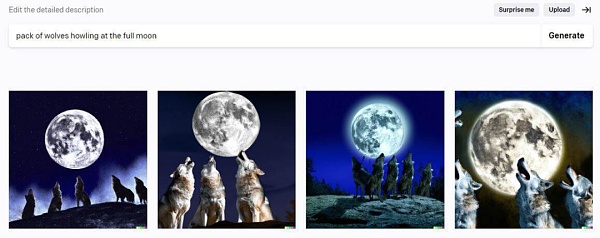

比如,我們輸入“狼群在滿月時嚎叫”就收到瞭如下的結果。

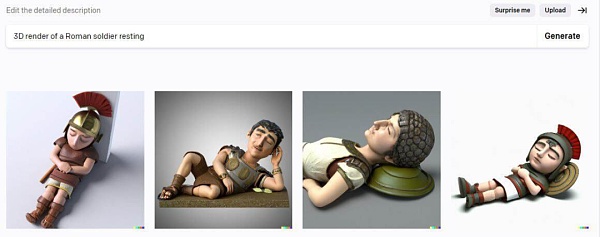

輸入“一個3D渲染的羅馬士兵正在休息”則獲得了以下的圖像。

DALL-E 2的工作原理是什麼?

DALL-E 2為AI圖像生成器的質量提供了新的基準。它與之前的同類產品相比,能夠更好地理解文本描述。

其卓越的自然語言理解能力可以更嚴格地控製圖像的風格、主題、角度、背景、位置和概念,並獲得更高質量的圖像和令人印象深刻的藝術形式。

那麼讓我們來看看DALL-E 2的工作原理。

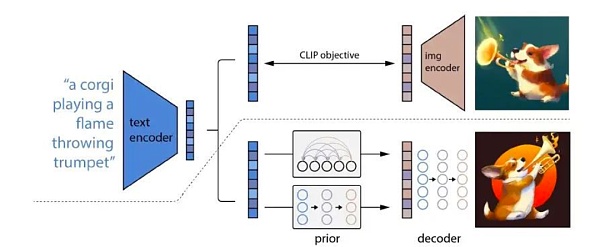

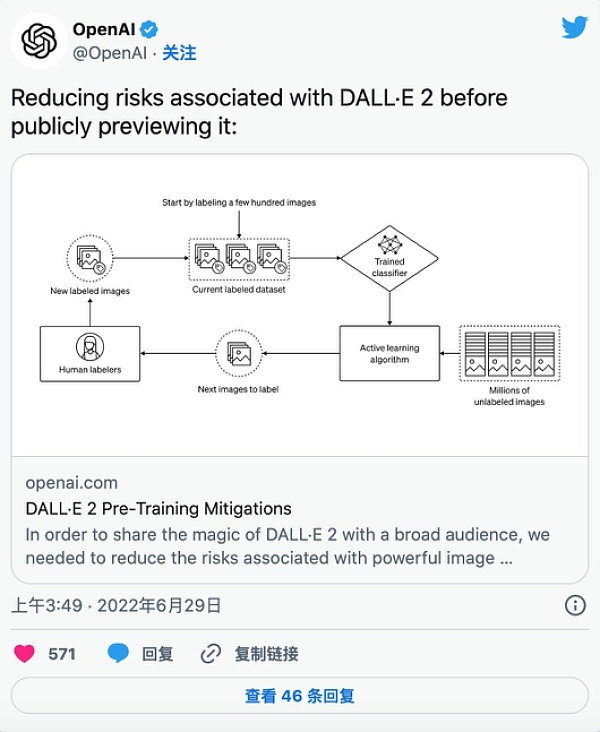

要了解AI圖像生成器的工作原理,我們首先需要了解CLIP、先驗模型和解碼器擴散模型(unCLIP)。

什麼是CLIP? CLIP指的是對比語言圖像預訓練,是DALL-E 2架構中最關鍵的模塊。

該訓練基於用戶可以用自然語言教計算機不同圖像之間如何相互關聯,並由文本和圖像編碼器這兩個神經網絡組成。

文本和圖像編碼器都接受了大量不同的圖像文本對集合的訓練。該模型分析這些圖像-標題對以創建稱為文本/圖像嵌入的矢量表示。換句話說,CLIP充當文本(輸入)和圖像(輸出)之間的橋樑。

先驗模型採用標題/CLIP文本嵌入,並以此為基礎生成CLIP圖像嵌入。

unCLIP則是使用CLIP圖像嵌入生成圖的原始CLIP模型的逆模型。 DALL-E 2通過先驗模型和unCLIP模型來創建輸出。

下圖大致概述了其基本過程。

如圖所示,unCLIP模型創建了圖像的“心理”表示。基於此,創建了原始圖像。

這些“心理再現”保留了語義一致的核心特徵和特點,例如“動物、物體、顏色、風格和背景等關鍵要素”。然而,因為擴散學習是變化的,每一次輸出的圖像也會有所不同。

請注意,上文只是DALL-E 2工作原理的簡要表述,實現的技術細節和數學更加複雜,我們就不在這裡贅述。如果您對DALL-E 2的技術規格感興趣,可以參看OpenAI在今年早些時候發表的論文《Hierarchical Text-Conditional Image Generation with CLIP Latents》。

使用DALL-E 2可以做什麼?

只要用戶給出精確和具有描述性的文本提示,就可以通過AI藝術生成器得到多個高質量的圖像,甚至在幾秒鐘的時間裡實現畫家或數字藝術家需要數小時甚至數天才能達到的質量水平。

用戶可以免費查看所有這些視覺創意,無需支付場地費,也無需向創意人員和模特支付工資。

然而這也對我們的內容創作經濟帶來了一定的影響。

DALL-E 2使用自己對主題、風格、調色板和所需概念意義的“理解”,生成相應的圖像。

每個圖像最多可以產生四個變體。每一個都與原作的外觀、感覺和意義相呼應,但又具有自己獨特的風格。

您也可以在DALL-E 2中編輯圖像,無需任何照片編輯經驗。與Adobe Photoshop不同,使用DALL-E進行編輯非常簡單。

例如,用戶想要在火星上行走的宇航員的肖像中添加一隻狗,只需要輸入“在宇航員身後放一隻狗”。同樣,用戶還可以要求程序通過放大和縮小來更改圖像的視圖框架,直到獲得所需的結果。而就DALL-E 2的功能而言,這些只是冰山一角。

同時,根據設計,該系統無法生成涉及色情、血腥或政治元素的內容。也就是說,該程序有其合理的局限性和缺點。

DALL-E 2的局限性

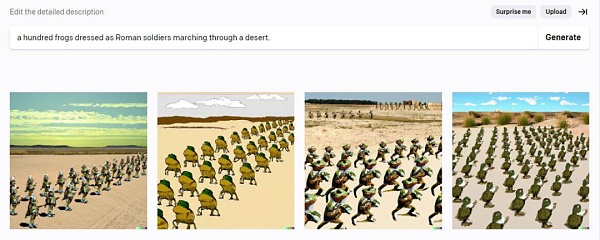

DALL-E 2的輸出質量很大一部分取決於用戶提供的文本提示的質量,文本越具體,獲得所需輸出的機會就越高。然而,該系統有一些內在的局限性。

例如,當前它還不具有很精確組合性,儘管似乎會隨著時間的推移而改善。這意味著DALL-E 2通常無法有意義地合併多個對像或對象屬性,例如形狀、方向和顏色。

同時在一些意料之外的情況下,有一些相對簡單的文本,程序也可能無法充分執行。

例如,我們輸入文本“一百隻打扮成羅馬士兵的青蛙在沙漠中行進”。即使我們嘗試了多種提示變體,結果也不盡如人意。

另一個例子是當我們嘗試相當簡單的提示時,如“霸王龍騎著獨輪車在艾菲爾塔前”。不知道為什麼,程序拒絕畫獨輪車,取而代之的是自行車。而當我們從提示中刪除“Eifel Tower”,產生預期圖像則沒有任何阻礙。

這些只是DALL-E 2局限性的幾個例子。更令人擔憂的問題本質上很複雜,可能會對公司及其用戶造成嚴重不良影響。

OpenAI限定DALL-E 2不創建公眾人物和名人的圖像。事實上,它完全拒絕生成包含真實面孔或真人的圖像,這是朝著防止濫用該程序邁出的重要一步。

隨著DALL-E 2越來越受歡迎,版權侵權也可能成為一個大問題。 OpenAI堅持認為,用戶“獲得了將他們使用DALL-E創建的圖像商業化的全部權利,包括轉載、銷售和商品化的權利。”

然而,人工智能藝術生成器依賴於分析、學習人類藝術家的作品來創造藝術。因此,不能排除潛在的侵犯知識產權法的可能性,無論是否有意。

總結

DALL-E 2完美嗎?作為一項正在完善的項目,答案是否定的。

但是,正如機器學習的本質一樣,隨著時間的推移,該程序正變得越來越聰明,也越來越有能力。從純技術的角度來看,DALL-E 2是AI技術演進的一大進步。

人們普遍認為人工智能係統在創意領域實際上無法超越人類,至少不會很快。但是DALL-E 2已經使這個論點受到了衝擊。

然而儘管OpenAI已經採取了一系列措施來預測和防止DALL-E 2的潛在濫用,但這並非萬無一失。在沒有任何道德界限的情況下可以使用的AI系統將在多久後出現?需要我們保持警惕。

無論如何,我們都需要密切關注這個新興行業。因為AI藝術生成器及其背後的技術只會在未來的歲月裡變得更加普遍。